数据挖掘:降低汽油精制过程中的辛烷值损失模型(二)

目录

一、选取主要特征操作变量

1.1问题分析

汽油的实际精制生产工序十分繁琐,可操作位点繁多,而不同操作位点之间可能存在着某些相关性质,例如装置内部温度的变化可能会导致装置内部压力的变化。同时也存在 一些与汽油成品质量相关性不大的常规操作变量。为了降低后续数据处理过程中所消耗的计算资源,需要对354个操作变量进行筛选,使得筛选出的操作变量最具代表性,与目标输出指标的相关程度高。

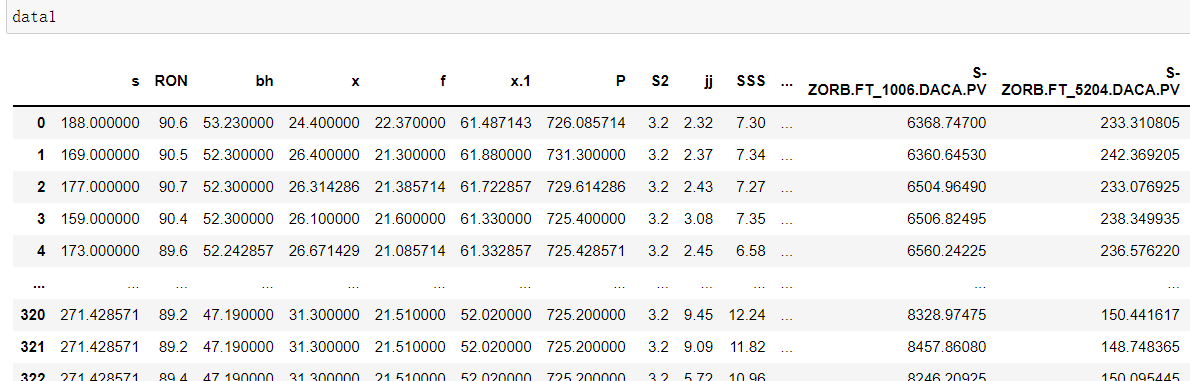

数据来源:原始数据采集来源于中石化高桥石化实时数据库(霍尼韦尔 PHD)及 LIMS 实验数据库。

问题要求:附件一中提供的 325 个样本数据中,包括 7 个原料性质、2 个待生吸附剂 性质、2 个再生吸附剂性质、2 个产品性质等变量以及另外 354 个操作变量(共计 367 个 变量)。对上述 367 个变量进行降维,选出不超过 30 个特征变量对模型进行建模。要求 选择具有代表性、独立性。

目标:由于附件一中的 325 个样本的原料性质均有差异,故本文将样本的 7 个原料性质作为模型输入的一部分,且对单个样本进行分析时原料性质不可进行操作更改。此外,本文将对 367 个操作变量进行特征选择,从中选择 10 个对模型输出影响较大的操作变量作为降维后的特征。综上所述,本文对上述 367 个变量(其中预先确定选择 7 个原料属性变量)选择合适的特征降维方法进行降维后,得到共 17 个特征。

1.2 特征降维

12种降维方法终极指南

1.2.1低方差滤波

该方法假设数据列变化非常小的列包含的信息量少。因此,所有的数据列方差小的列被移除。需要注意的一点是:方差与数据范围相关的,因此在采用该方法前需要对数据做归一化处理。

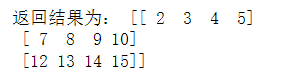

example1:

1、初始化VarianceThreshfold,指定阀值方差

2、调用fit_transform

处理之后的数据、变量缩减至211:

1.2.2灰色关联分析

对于两个系统之间的因素,其随时间或不同对象而变化的关联性大小的量度,称为关联度。在系统发展过程中,若两个因素变化的趋势具有一致性,即同步变化程度较高,即可谓二者关联程度较高;反之,则较低。因此,灰色关联分析方法,是根据因素之间发展趋势的相似或相异程度,亦即“灰色关联度”,作为衡量因素间关联程度的一种方法。

灰色系统理论提出了对各子系统进行灰色关联度分析的概念,意图透过一定的方法,去寻求系统中各子系统(或因素)之间的数值关系。因此,灰色关联度分析对于一个系统发展变化态势提供了量化的度量,非常适合动态历程分析。

计算步骤

1、确实参考数列与比较数列

2、对参考数列与比较数列进行无量纲化处理

3、计算关联系数,求关联度

这里要把变量RON放在最后一列。

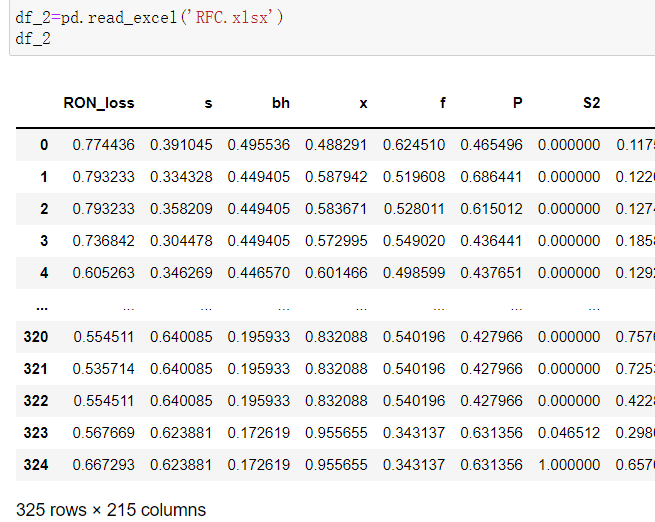

1.3 初步RFC模型

通过随机森林(RFC)模型对汽油辛烷值RON进行特征提取与模型优化。

1.3.1 导入相关的数据库

这里,产品辛烷值RON作为数据标签,其余作为特征,由于特征过多,需要对对特征进行降维提取。

1.3.2 构建初步随机森林模型

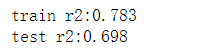

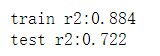

初步构造未提取特征之前的随机森林模型,测试集与训练集结果展示如下:

可以看到,模型训练集比测试集程度好,说明模型拟合程度待优化,这里通过网格搜索方法实现模型参数的优化。

1.3.3 GridSearch实现参数调优

参数调优后就是进行模型最优参数导出:

可以看到,模型拟合分数为0.65,再次对模型进行拟合查看参数调优后的效果。

可以看到,模型的训练集拟合优度大幅度提升,测试集模型额拟合优度也有明显额提升,但幅度不大。

1.4 特征提取

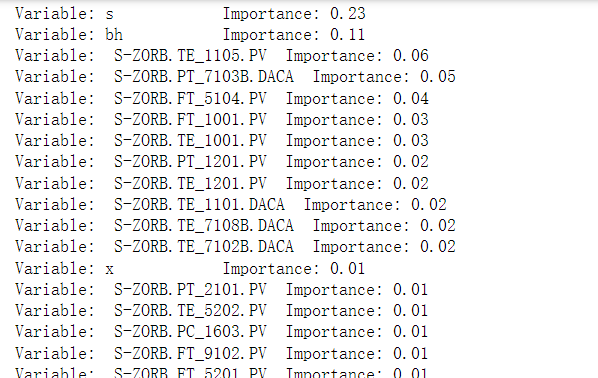

1.4.1 获取影响辛烷值的特征重要性

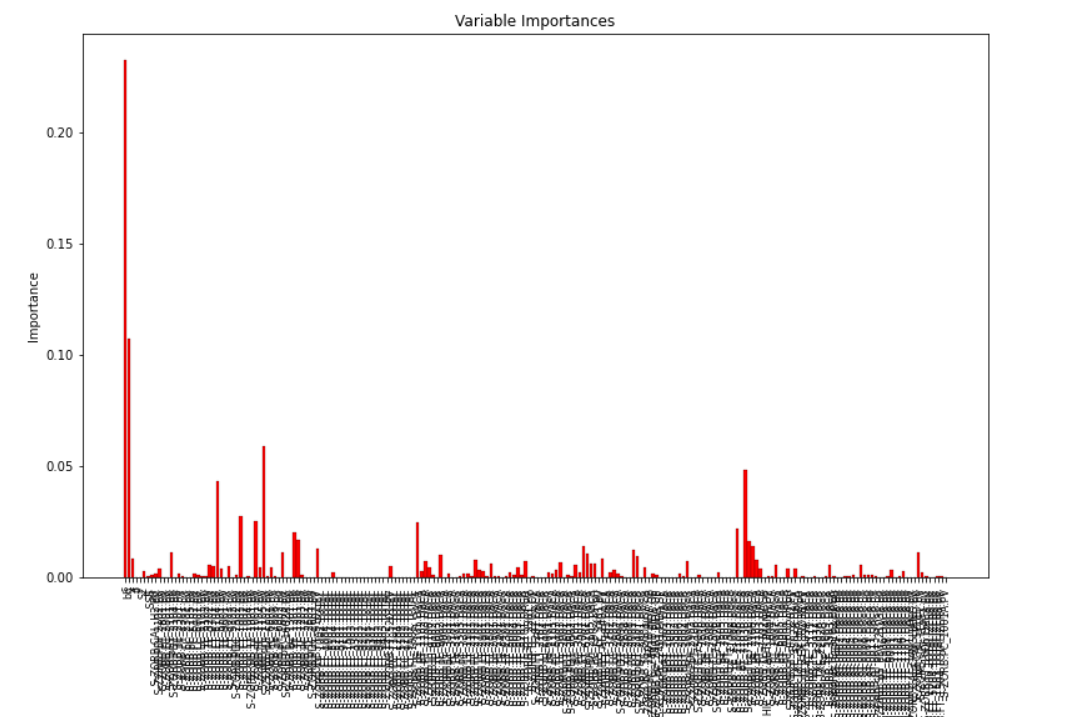

1.4.2 可视化变量的重要性

这里选择15个特征变量,并最终作为辛烷值RON的特征。

- 点赞

- 收藏

- 关注作者

评论(0)