K8S的Kafka监控(Prometheus+Grafana)

【摘要】 本文实战操作如何在K8S环境对kafka做监控(Prometheus+Grafana)

欢迎访问我的GitHub

这里分类和汇总了欣宸的全部原创(含配套源码):https://github.com/zq2599/blog_demos

- 对于部署在K8S上的Kafka来说,Prometheus+Grafana是常用的监控方案,今天就来实战通过Prometheus+Grafana监控K8S环境的Kafka;

准备工作

- 今天聚焦的是Kafka监控,因此需要K8S、Helm、Kafka、Prometheus、Grafana等服务都已就绪,下面提供了一些链接,在您做相关部署时可以作为参考:

- 搭建K8S:《kubespray2.11安装kubernetes1.15》

- 搭建Helm:《部署和体验Helm(2.16.1版本)》

- 搭建Prometheus和Grafana:《kubernetes1.15极速部署prometheus和grafana》

- 部署Kafka:《K8S环境快速部署Kafka(K8S外部可访问)》

版本信息

- Kubernetes:1.15

- Kubernetes宿主机:CentOS Linux release 7.7.1908

- NFS服务:IP地址192.168.50.135,文件夹/volume1/nfs-storageclass-test

- Helm:2.16.1

- Kafka:2.0.1

- Zookeeper:3.5.5

- Prometheus:2.0.0

- Grafana:5.0.0

- 准备完毕就可以开始实战了;

确认kafka-exporter参数

- 即将部署的kafka-exporter要从kafka取得数据,因此要准备kafka-exporter参数;

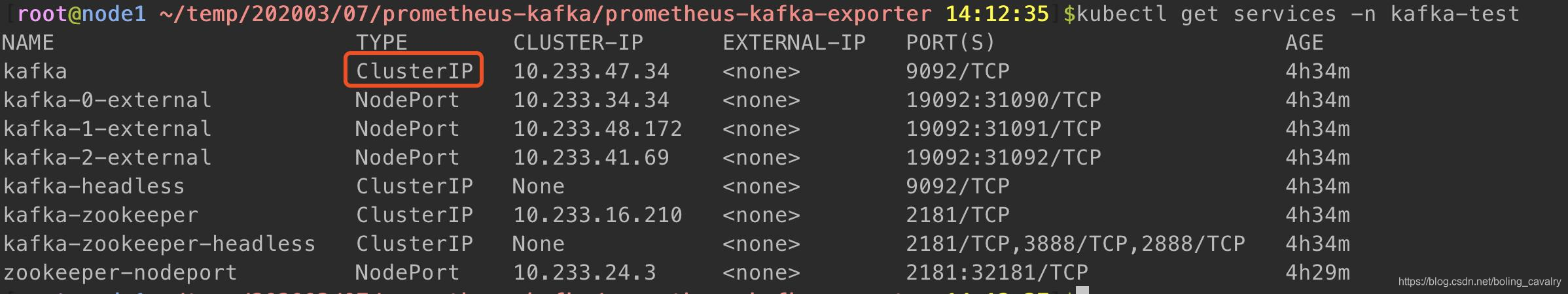

- 查看kafka的服务中TYPE是ClusterIP的那个,如下图红框所示:

- 上述红框中的服务名字是kafka、端口是9092,因此稍后在kafka-exporter中配置的kafka信息就是kafka:9092

实际操作

- 添加Helm仓库(该仓库中有我们需要的kafka-exporter):helm repo add gkarthiks https://gkarthiks.github.io/helm-charts

- 下载kafka-exporter:helm fetch gkarthiks/prometheus-kafka-exporter

- 解压下载的chart文件:tar -zxvf prometheus-kafka-exporter-0.1.0.tgz

- 进入解压后的目录:cd prometheus-kafka-exporter

- 修改values.yaml文件,如下图红框,kafka:9092就是同一namespace下访问kafka的地址:

- 在values.yaml文件所在目录执行:helm install --name-template kafka-exporter -f values.yaml . --namespace kafka-test (kafka的namespace是kafka-test,这里的namespace要和kafka保持一致)

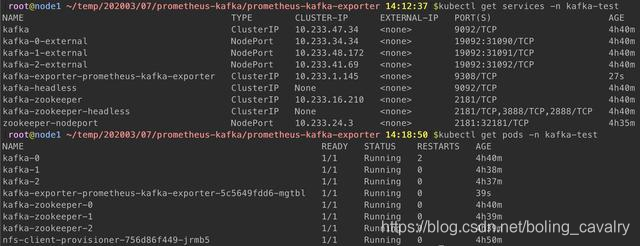

- 查看服务和pod是否就绪:

- 此时我们部署好了kafka-exporter,能给prometheus提供监控数据了,但prometheus并不知道要来这里采集数据,因此接下来要配置prometheus;

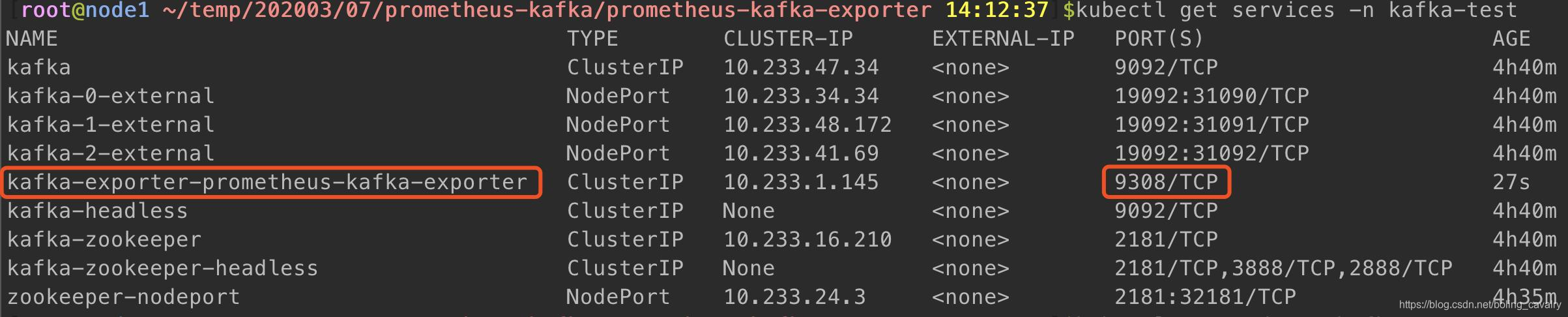

- 确认kafka-exporter服务的访问地址,prometheus采集数据要用到,名字和端口如下图红框所示,因此可以拼接处跨namespace的访问地址:kafka-exporter-prometheus-kafka-exporter.kafka-test.svc.cluster.local:9308

- 如果您是参照《kubernetes1.15极速部署prometheus和grafana》部署的prometheus,请打开部署时下载的configmap.yaml文件,里面是prometheus的配置,如果是其他途径部署的,请按照自己的部署情况找到prometheus.yml的位置;

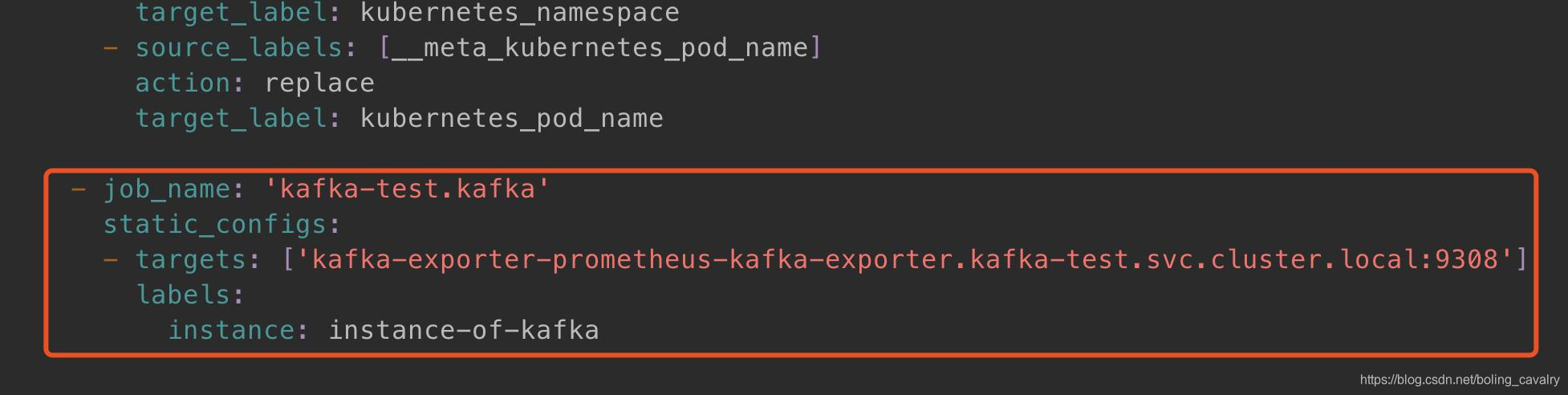

- configmap.yaml中增加下图红框中的内容,这样prometheus就可以采集kafka-exporter的数据了:

- 使得配置生效:kubectl apply -f configmap.yaml

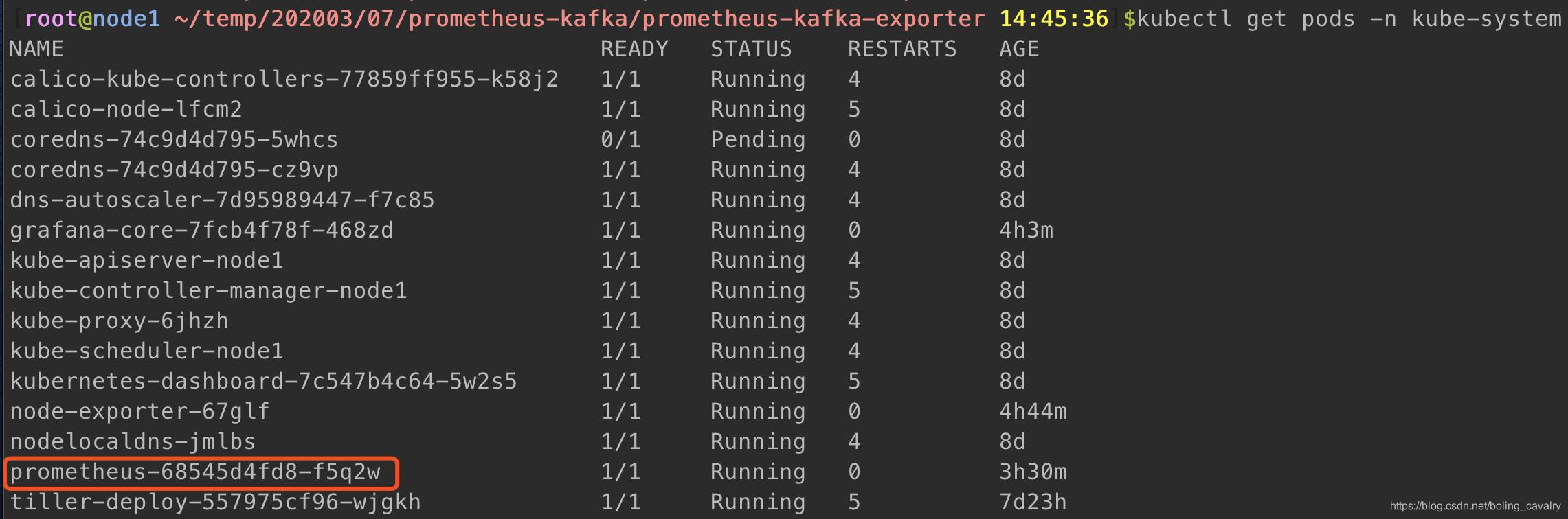

- 此时的prometheus容器用的还是旧配置,为了让配置生效,要把prometheus的pod删除,这样K8S自动创建的新pod就用上了新的配置,找出prometheus的pod:kubectl get pods -n kube-system

- 删除旧的pod:kubectl delete pod prometheus-68545d4fd8-f5q2w -n kube-system

- 等待新的pod被自动创建;

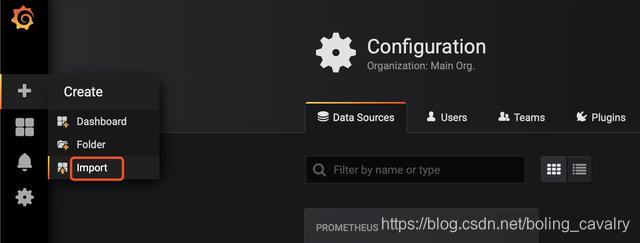

- 接下来登录Grafana,配置监控页面,如下图,做模板导入操作:

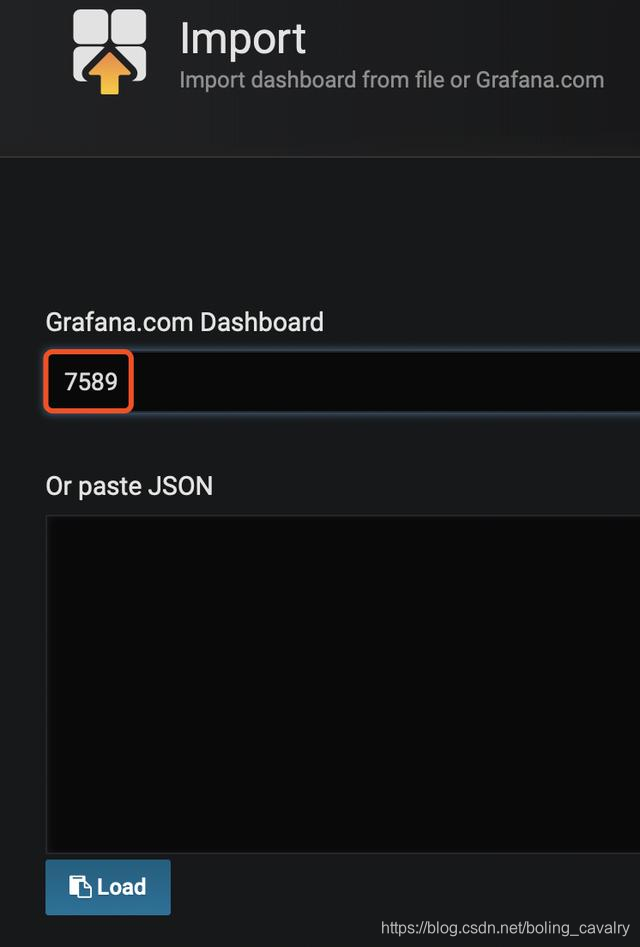

- 在导入模板的页面输入编号7589:

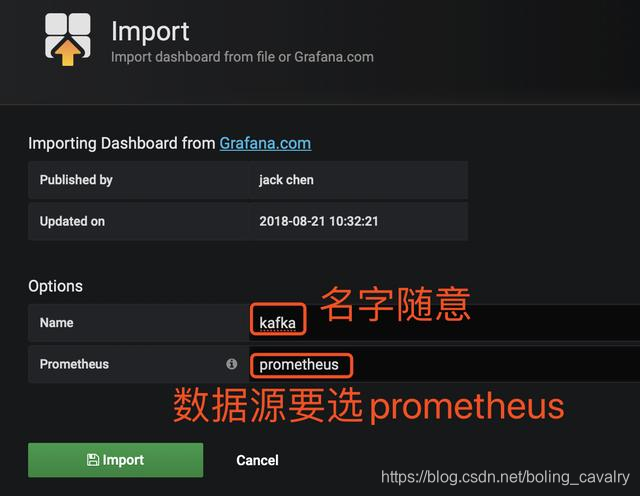

- 选择数据源的时候,要选prometheus,如下图:

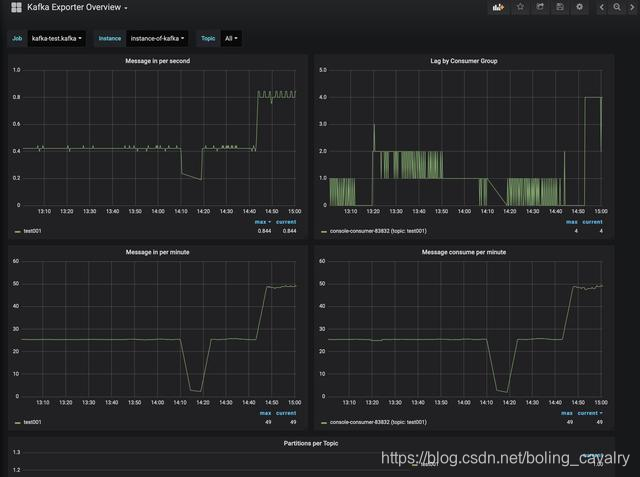

- 此时如果您的kafka有消息的收发,就可以立即看到数据了:

- 至此,K8S环境下的kafka监控已经部署完成,希望本文能给您一些参考;

欢迎关注华为云博客:程序员欣宸

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)