Text to Image综述阅读 基于GAN的文本生成图像(介绍、原理、发展、定量指标和未来方向)

本系列是根据2021年的一篇论文《Adversarial Text-to-Image Synthesis: A Review》理解所写,主要在于总结和归纳基于GAN的“文本生成图像”(text to image)方向的研究情况。

论文地址:https://arxiv.org/abs/2101.09983

一、介绍

起源:基于GAN的文本生成图像,最早在2016年由Reed等人提出,最开始是Conditional GANs的扩展,仅在受限的数据集取得成果,小图像分辨率64*64。

2016到2020的发展:生成图像质量提升、所用数据集复杂性提升、生成图像的分辨率提升256*256、文本编码、损失代价函数、新的GAN架构、定量评价标准的提升。

目前的挑战:基于文本描述生成包含多个对象的复杂场景、分辨率的再次提升、重现许多方法的定量结果、评价指标不准,很难对结果进行定量比较。

思维导图

二、基本原理

GANs

GANs:生成对抗网络(Generative Adversarial Networks),实现方式是让两个网络相互竞争。其中一个叫做生成器网络( Generator Network),它不断捕捉训练库中的数据,从而产生新的样本。另一个叫做判别器网络(Discriminator Network),它也根据相关数据,去判别生成器提供的数据到底是不是足够真实。

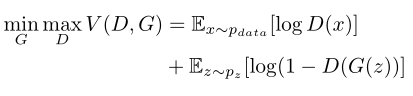

损失函数公式:

框架模型:

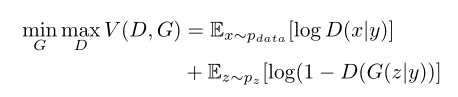

ConditionalGANs

Mirza等人提出了ConditionalGANs(cGAN)通过在生成器和鉴别器处加入条件变量y(例如,类别标签)

损失函数公式:

框架模型:

框架模型:

Text encoding

文本编码最开始使用的是pre-trained char-CNN-RNN,即预训练的字符级卷积循环神经网络,之后发展有用到CA、SI、LSTM、BERT等。

数据集的使用

Oxford-102 Flowers、CUB-200 Birds、COCO

思维导图

三、发展与基本方法

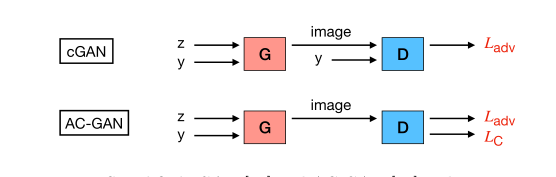

1、起源:GAN-INT-CLS和TAC-GAN

GAN-INT-CLS:输入TE后的文本和一定噪声,使用GAN的生成器拥有的图片合成能力合成一张图像传给辨别器,辨别器根据生成的图像和TE的文本来识别真假,这是初始最简单的模型。

TAC-GAN:在辨别器上面做出改动,他加了一个辅助分类任务y,从而辨别生成的图像是否符合y类。

文本理解采用:pre-trained char-CNN-RNN text encoder

y:TAC-GAN使用的一个辅助分类任务

φ:TE的文本,Embedding φ

z:噪声

TE:Text Encoder

2、栈的引入

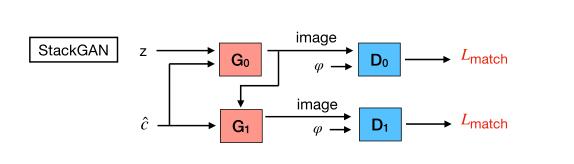

2.1、StackGAN

StackGAN采用了两级的GAN,第一个生成器G0生成6464,第二个生成器G1在此基础上生成256256。

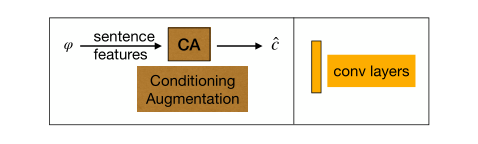

CA:Conditioning Augmentation(CA),一个文本理解模块

c:CA后的文本

z:噪声

φ:Embedding文本

CA:Conditoning Augmentation,一种条件增强技术,帮助在不同的分辨率下生成更一致的图像

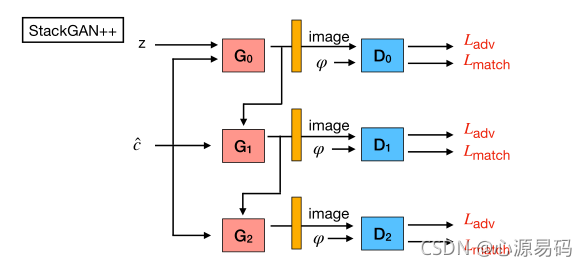

2.2、StackGAN++

StackGAN++将级数提高到了多层,依然是逐级提高分辨率,但采用端到端的方式进行训练。

2.3、其他

FusedGAN、HDGAN、PPGAN、HfGAN,文章中也有介绍,这里暂时不展开。

2.4、创新与不足

改进:把生成高质量图片这个复杂问题,分解成了一些更好控制的子问题;

不足:输入是全局的句子向量,丢失了细粒度的单词级别的信息,即丢失了相应的细节。

3、注意力机制的引入

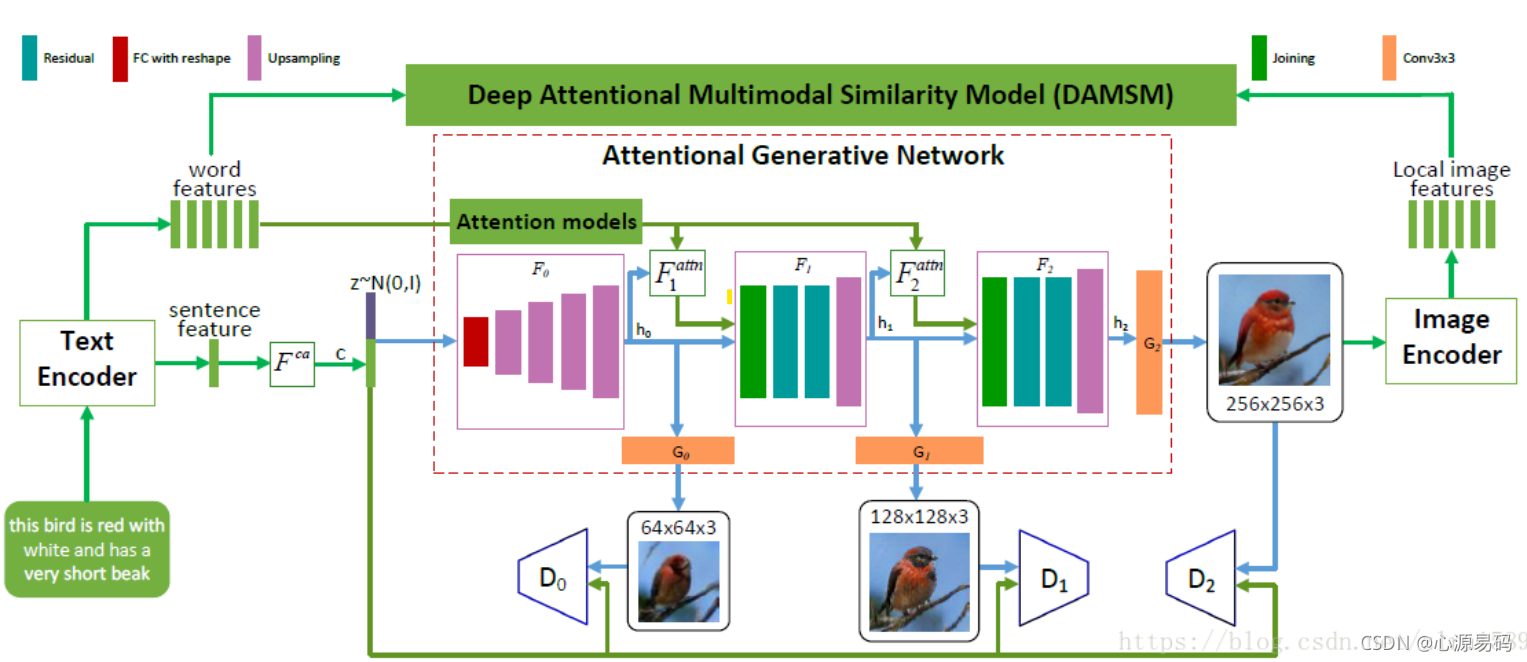

3.1、AttnGAN

AttnGAN是在Stack++GAN进行了延伸,加入了一个attention module来关注自然语言描述中的相关单词,进而合成图像不同子区域的细粒度细节。

w:单词特征 z:噪声 c:CA后的文本

attention module:包括word features和sentence features;

一个具体例子:

3.2、其他

SEGAN、ControlGAN,文章中也有介绍,这里暂时不展开。

3.3、创新

提出了一种注意力集中的多模态相似度模型,以计算出细粒度的图像-文本匹配损失。效果明显提高,在CUB数据集上比之前的最优结果提升14.14%,在更具挑战性的COCO数据集上提高了170.25%。

4、孪生(siamese)网络的引入

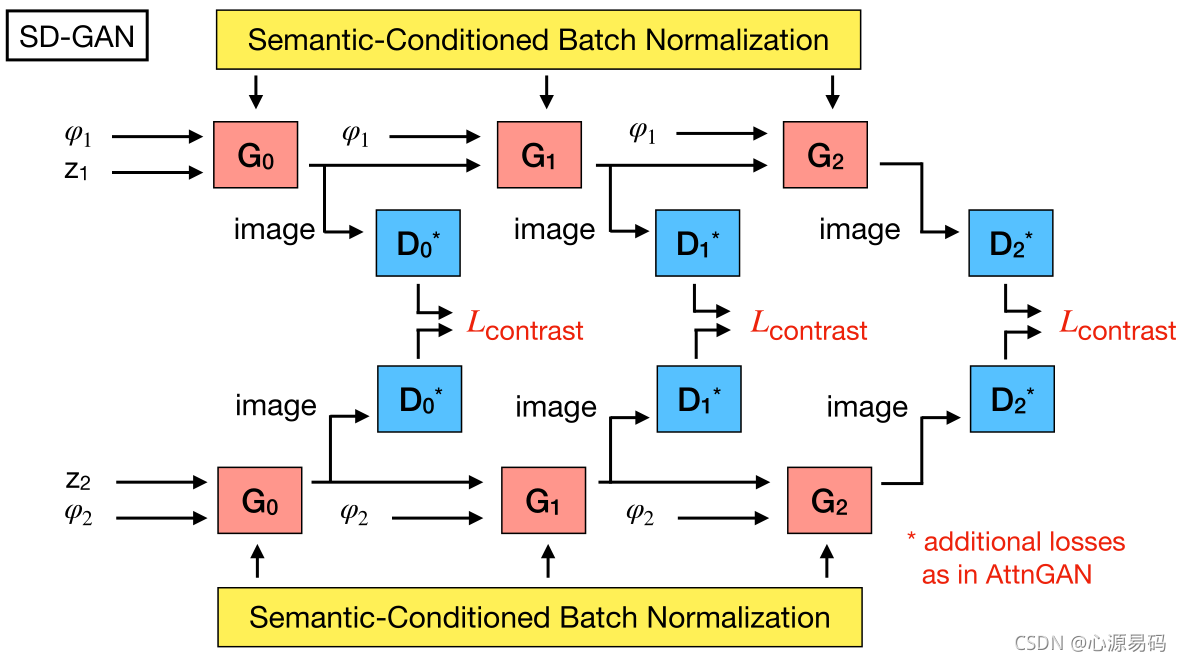

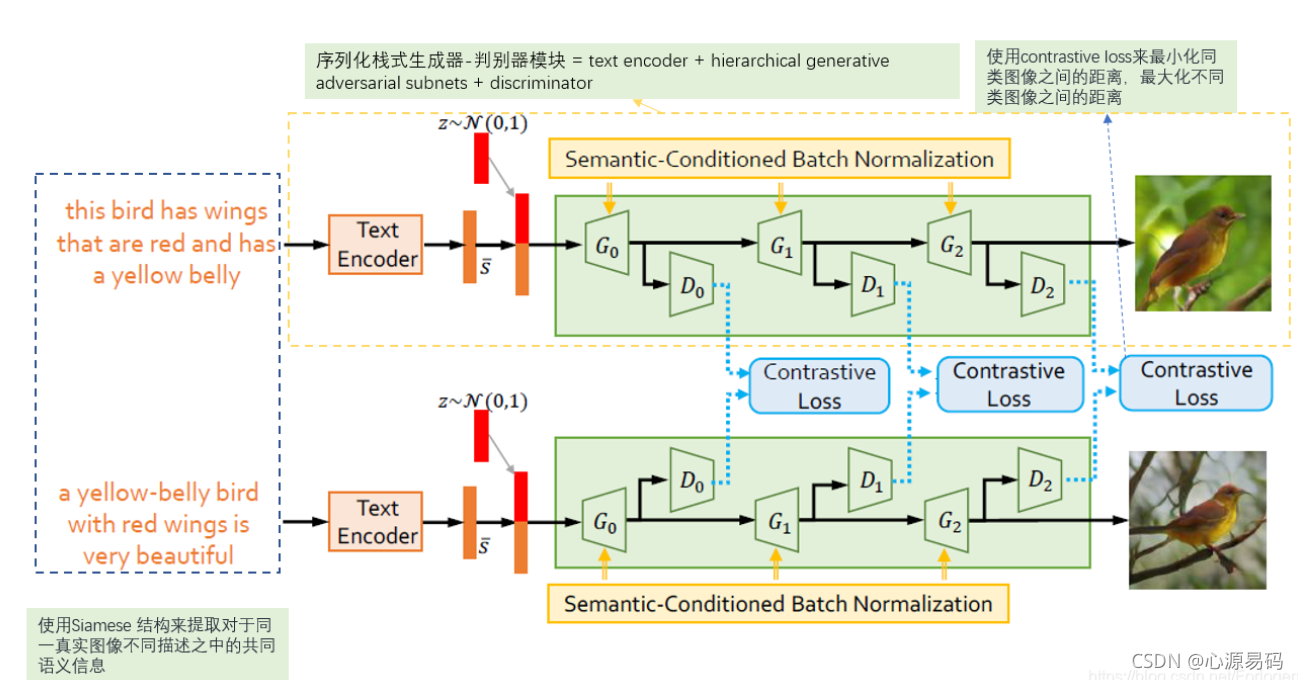

4.1、SD-GAN

SD-GAN的每个分支对不同的输入进行操作,采用对比损失来最小化由同一真实图像的不同描述生成图像的距离,同时最大化不同真实图像的生成图像距离。

简单的来说就是,设置两个并行的GAN,输入相同真实图像的不同文字描述,如果他们两个生成图像差不多则鼓励模型,如果生成的图像相差甚远则抑制。这样既可以提取出语义的一致性部分,又可以保留描述的多样性和细节部分。

举个例子:

4.2、其他

SEGAN、Text-SeGAN:在文章中有介绍,其增加一个与语义相近的真实图像距离处理、增加语义逐渐变难。

4.3、创新

提出了新的思路,而且SDGAN可以对描述文本中小的变化做出相应的改变。

5、循环(cycle)网络的引入

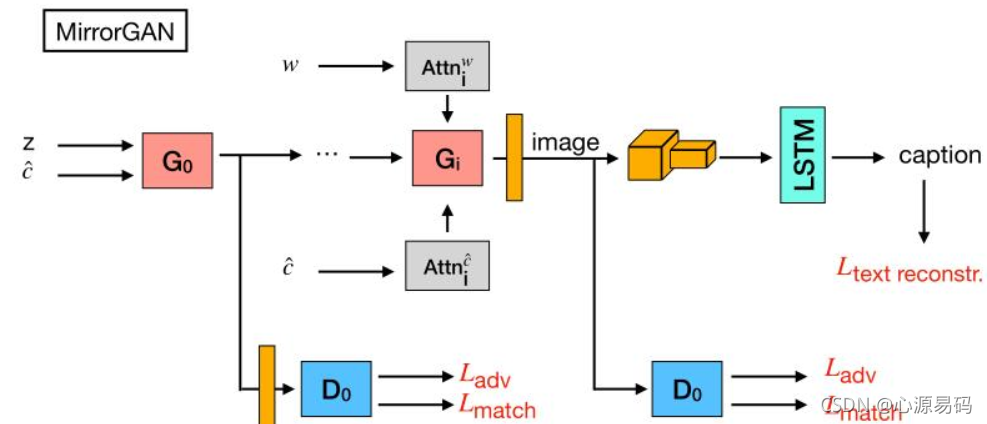

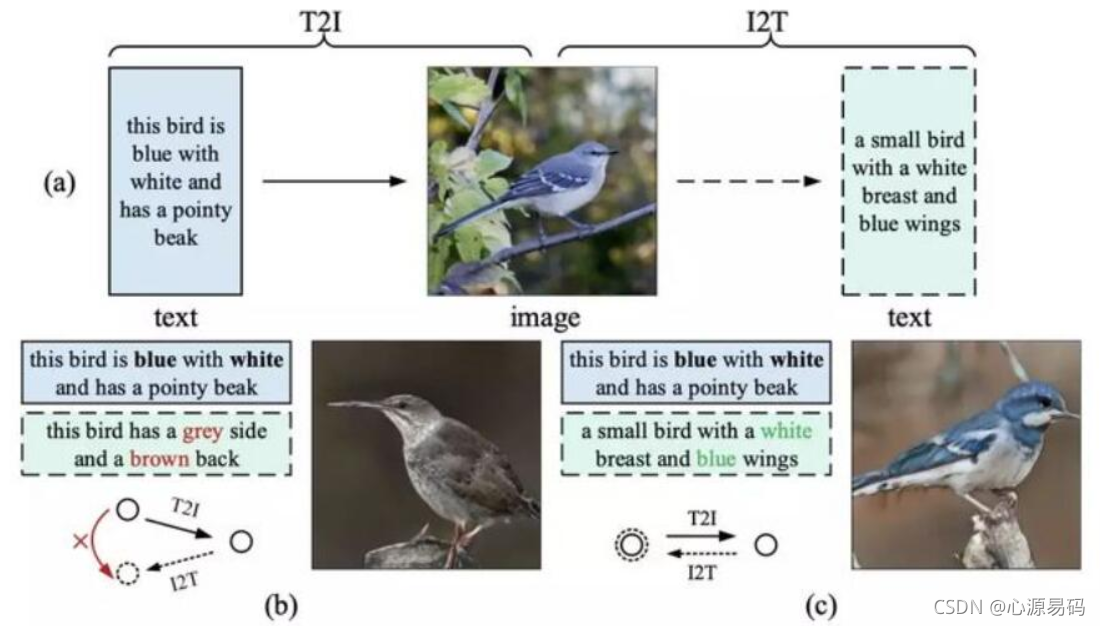

5.1、MirrorGAN

MirrorGAN:才有了循环的架构,使T2I–>I2T–>T2I–>I2T…加入了语义文本再生和对齐模块,以从生成的图像重新生成文本描述,使其在语义上与给定的文本描述对齐。达到文本和图像的语义一致性判别。

简单来说,MirrorGAN先从文本生成图像,然后以生成的图像重新再生成文本,使两次的文本尽可能的靠近。

如果一个模型具有语义一致性,那么从输入文本就应该与文本生成图像再生成的文本一致。

举个例子:

5.2 创新

解决文本和视觉之间语义一致性,COCO 数据集上成绩最佳,生成的高质量图像具有与输入文本描述一致的语义。

6、记忆(memory)网络的引入

6.1、DM-GAN

DM-GAN,添加一个记忆机制,来处理 badly-generated initial images,将初始图像和单词特征作为输入,比较文本和图像特征计算每个单词的重要性,引入一个 memory writing gate 来动态的选择和产生图像相关的单词

6.2、创新

1)提出一个新颖的 GNA model 组合了 dynamic memory component 来产生高质量的图像,即使初始图像很差;

2). 提出一个 memory writing gate 来根据初始图像,选择相关的单词;

3). 提出 response gate 来自适应的融合来自图像和记忆中的信息;

4). 实验结果顶尖;

7、无条件模型的引入

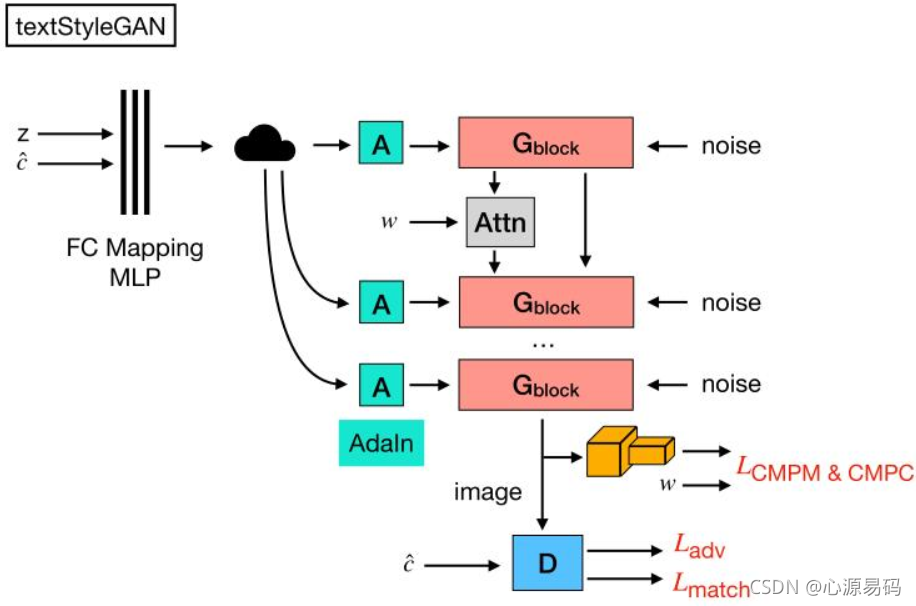

7.1、StyleGAN

z:噪声 c:文本特征 w:中间级潜在特征

基于风格驱动,每次加入noise控制风格和潜在语义,即可以生成更加多样化的图像。

7.2、创新

提高了图像的多样性:对高级属性和随机变化(的多样性)方面的分离、中间潜在空间的线性研究增进了我们对GAN的理解和可控性生成。

四、度量

1、度量指标

度量指标目前常用的有8种,如下表,IS、FID、SceneFID是对图像质量的一个判断,R-prec、VS、SOA、Captioning是对图像和文本的相关性的一个判断。目前来说用户调研仍然是最可靠的指标,但是用户调研耗时耗力。

| 度量指标 | 图像质量 | 图像多样性 | 图像保真性 | 文本相关性 | 对象符合性 | 数量对齐性 | 稳健性 | 可解释性 | 自动化 |

|---|---|---|---|---|---|---|---|---|---|

| IS | √ | √ | |||||||

| FID | √ | √ | √ | ||||||

| SceneFID | √ | √ | |||||||

| R-prec | √ | √ | |||||||

| VS | √ | √ | |||||||

| SOA | √ | √ | √ | ||||||

| Captioning | (√) | √ | |||||||

| User Studies | √ | √ | √ | √ | √ | √ | √ | √ | √ |

2、度量指标当前的问题

a:过拟合:度量得分高于真实图像

b: 生成多个对象的复杂场景有时出现得分很高,但是图像看上去很抽象

c: 各个度量的指标得分不一致,一个图像可能在一个指标上得高分,但在另一指标上得分低

d: 度量模型各有优劣,最好的仍然是做用户调研。

五、未来的研究

1、模型架构

当前的T2I方法已经成功地将最先进的无条件图像生成模型应用于T2I。因此,在无条件图像生成领域取得进展的基础上,研究更好的条件图像生成适应性可能比为T2I设计特殊架构更有效。

2、数据集

大型、高质量的数据集是深度学习方法成功的基础。

a:当前可用的描述多个对象的复杂场景数据集的一个缺点是图像分辨率低。到目前为止,我们仍然缺乏能够可以训练合成具有多个交互对象的复杂场景的真实照片图像。

b:未来的工作可能考虑允许为图像中的各个区域提供文本描述。

c:此外,目前的数据集仅限于英语。为了提高T2I模型的实用性,未来的工作可以考虑收集其他语言的描述,并分析在目标图像如何描述方面是否存在差异。

d:…

3、评价标准

评估生成图像的质量、多样性和语义对齐是一个困难的问题,也是一个悬而未决的问题。虽然有时会执行用户研究,但设置可能会有很大的变化,而且可能会很耗时和昂贵。因此,一个有希望的未来研究方向是为T2I社区标准化用户评估研究。

4、联合实际应用

图像合成的研究往往受到实际应用的推动。

a:图像处理方向:由于文本允许传递丰富的信息,未来的模型可能需要从多个可能不同的文本描述中积累和编译整体表示,类似于人类如何从高级信息和细粒度细节中绘制场景的心理图片。

b:语音和视频方向:语音图像合成(speech-to-image synthesis:S2I)S2I将在未来受到更多的关注,因为它的自然界面可以支持许多新的有趣和交互式应用程序。S2I社区可以受益于T2I社区,因为S2I可以通过用语音编码器替换文本编码器来实现,反之亦然。另外,从文本描述生成视频似乎是一个显而易见的未来研究方向。

- 点赞

- 收藏

- 关注作者

评论(0)