【每日一读】On Interpretation of Network Embedding via Taxonomy Induct

@TOC

简介

Hello!

非常感谢您阅读海轰的文章,倘若文中有错误的地方,欢迎您指出~

ଘ(੭ˊᵕˋ)੭

昵称:海轰

标签:程序猿|C++选手|学生

简介:因C语言结识编程,随后转入计算机专业,获得过国家奖学金,有幸在竞赛中拿过一些国奖、省奖…已保研

学习经验:扎实基础 + 多做笔记 + 多敲代码 + 多思考 + 学好英语!

唯有努力💪

【每日一读】每天浅读一篇论文,了解专业前沿知识,培养阅读习惯(阅读记录 仅供参考)

论文简介

原文链接:https://dl.acm.org/doi/10.1145/3219819.3220001

会议:KDD '18: Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining (CCF A类)

年度:2018年7月19日(发表日期)

ABSTRACT

网络嵌入已越来越多地用于许多网络分析应用程序以生成低维向量表示,因此许多现成的模型可用于解决各种数据挖掘任务。然而,与许多其他机器学习方法类似,网络嵌入结果仍然很难被用户理解。嵌入空间中的每个维度通常没有任何特定含义,因此很难理解嵌入实例在重构空间中的分布情况。此外,异构内容信息可能会被纳入网络嵌入中,因此很难指定哪个信息源有效地生成嵌入结果。

在本文中,我们研究了网络嵌入的解释,旨在了解实例如何在嵌入空间中分布,并探索导致嵌入结果的因素。 我们采用事后解释方案,以便我们的方法可以应用于不同类型的嵌入方法。具体来说,网络嵌入的解释以分类的形式呈现。为构建分类法开发了有效的目标和相应的算法。我们还设计了几个指标来评估解释结果。来自不同领域的真实世界数据集的实验表明,通过与最先进的替代方案进行比较,我们的方法对嵌入结果产生了有效和有意义的解释。

1 INTRODUCTION

在使用现成的机器学习模型进行高级分析任务(如分类 [22、52]、聚类 [12、57]、链接预测 [55] 和建议 [4, 23]。网络嵌入将节点投影到一个低维空间,其中每个节点都由一个向量表示。网络嵌入保留了原始网络的某些结构和内容信息。就预定义的邻近度度量而言,彼此相似的节点被映射到嵌入空间中的相邻区域。

与许多传统的机器学习技术类似,网络嵌入也存在缺乏可解释性的问题。通常嵌入空间中的每个维度都没有任何特定的含义。此外,尽管网络嵌入可以生成有效的特征表示,但由于所应用的网络嵌入模型的模糊性,我们缺乏对嵌入如何在新空间中分布的整体理解。可解释性在许多应用场景中起着至关重要的作用。一方面,作为异构信息源,如链接[46、52]、属性[25、58]、标签[26、29、56]和局部结构[11、22、52]被纳入计算中的网络嵌入算法节点之间的相似性,解释方法可以提供线索,说明哪些信息对产生结果很重要,以及它是否符合应用程序 [47]。另一方面,模型的“黑匣子”性质可能会阻碍用户信任生成的分析结果 [37]。例如,许多推荐系统将用户和产品映射到嵌入空间中,然后通过一些匹配算法向用户推荐产品。如果可以指定潜在原因,用户可能会更好地信任推荐结果[8]。因此,我们建议研究在网络嵌入中启用解释的重要问题。

由于问题的独特属性和网络数据的特征,理解网络嵌入是一项非常重要的任务

- 首先,我们不能直接应用为预测模型设计的现有解释方法 [5, 20, 47]。这些方法需要实例的类标签,但是嵌入结果中无法获得这些标签。

- 其次,许多现实世界的网络体积庞大,包含多种信息并且往往是嘈杂的。这些数据特征需要解释模式有效地利用各种信息源并有效地处理它们。

- 第三,虽然可视化技术可以应用于理解网络嵌入结果 [21, 41, 50],但对于数据科学背景有限的用户来说,从可视化中手动发现复杂模式并不直观。有些信息甚至不能仅仅通过可视化来呈现。

为了应对上述挑战,在本文中,我们提出了一种新的解释框架来理解网络嵌入。该方法是事后的,即我们专注于解释给定的网络嵌入结果,使其适用于不同类型的网络嵌入方法。与许多为单个实例提供局部解释的现有框架不同 [3, 47],我们的方法侧重于捕获嵌入结果的全局特征。

我们对网络嵌入的解释以分类的形式呈现。我们首先提取分类的主干以了解实例在嵌入空间中的分布情况,然后利用网络同质性的特性对分类中的不同概念进行描述。提出了适当的数据结构和算法以提高该方法的效率。由此产生的解释以及可视化工具可以为最终用户提供更丰富的信息。本文的主要贡献如下:

- 我们设计了一个与模型无关的解释框架,以通过分类归纳来理解网络嵌入结果。

- 我们在分类归纳的每个步骤中提出了明确的目标,并针对这些目标开发了有效的算法。

- 我们设计了用于评估解释准确性的新指标。在现实世界的网络上进行实验以证明所提出方法的有效性。

2 PROBLEM FORMULATION

2.1 Notations

我们使用粗体大写字母(例如 A)来表示矩阵,使用粗体小写字母(例如 z)作为向量,使用书法字母(例如 T)作为集合,使用普通字符(例如 i、K)作为标量。集合 T 的大小表示为 |T |。矩阵 A 的第 i 行、第 j 列和 (i, j) 项分别表示为 Ai,:, A:, j 和 Ai, j 。令 N = {V, E, X} 为输入网络,其中 V 表示节点集,E 表示边集,X ∈ RN ×M 表示属性矩阵。具体来说,网络有N个节点,每个节点关联M个属性。节点属性的一些示例包括社交网络中用户的传记信息,以及共同购买网络中的产品评论。网络嵌入的输出是表示矩阵 Z ∈ RN ×D ,其中 Zi,: ∈ RD 表示第 i 个节点的嵌入实例。在本文中,我们假设网络中只有一种类型的节点和关系,但这项工作可以扩展到具有各种类型节点和关系的异构网络。

2.2 Objectives of Network Embedding

为了为设计合适的解释方法提供指导,我们首先阐述了不同网络嵌入方法的共性。

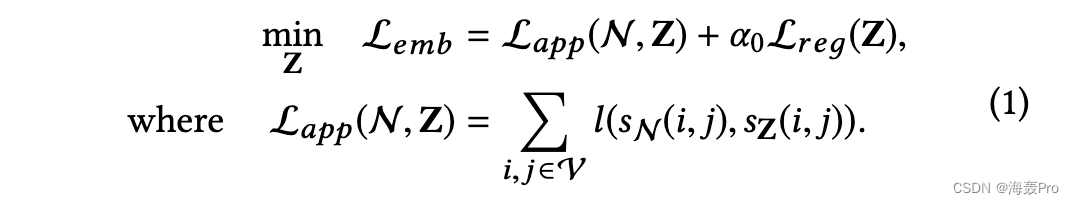

具体来说,绝大多数现有的网络嵌入方法可以简化为解决以下优化问题:

这里 Lemb 、 Lapp 和 Lr eä 分别表示整体损失函数、近似损失函数和正则化项。α0 是一个平衡参数。 sN (i, j) 和 sZ(i, j) 分别表示原始网络和嵌入空间中节点 i 和 j 之间的相似性度量。 l 是元素级损失函数,用于测量 sN (i, j) 和 sZ(i, j) 之间的差异。 sZ(i, j) 的示例包括逻辑误差 [52]、平方误差 [55] 和内积 [56]。 sN (i, j) 可以基于邻域 [11, 52]、节点属性 [25] 和标签 [29, 56] 来测量。例如,在 [52] 中,考虑一阶邻近度的目标函数为 − Í(i, j)∈ E wi, j log p(i, j),其中 wi, j 是边缘权重,p(i , j) 是节点 i 和 j 之间的概率。这里sN(i,j)和sZ(i,j)对应wi,j和p(i,j),l是KL-散度。

因此,原始网络中节点之间的相似性被编码为嵌入实例之间的接近度。从上面的分析中,我们对理解网络嵌入结果的两个方面感兴趣:嵌入实例如何在潜在空间中分布(即哪些节点在潜在空间中相互相邻或分离),以及可能导致的因素是什么嵌入分布?

2.3 Taxonomy Induction as Interpretation

在设计解释模式时,我们考虑了几个元素

- 首先,由于不同的方法采用不同的嵌入表示学习策略,我们利用事后策略 [37] 并尝试从获得的嵌入结果中提取解释信息。

- 其次,由于连接节点之间存在自相关 [32],我们专注于解释整体嵌入结果,而不是为每个单独的节点提供局部解释。

- 第三,由于在现实世界的网络中自然观察到社区结构,它促使我们解释基于社区的嵌入结果。

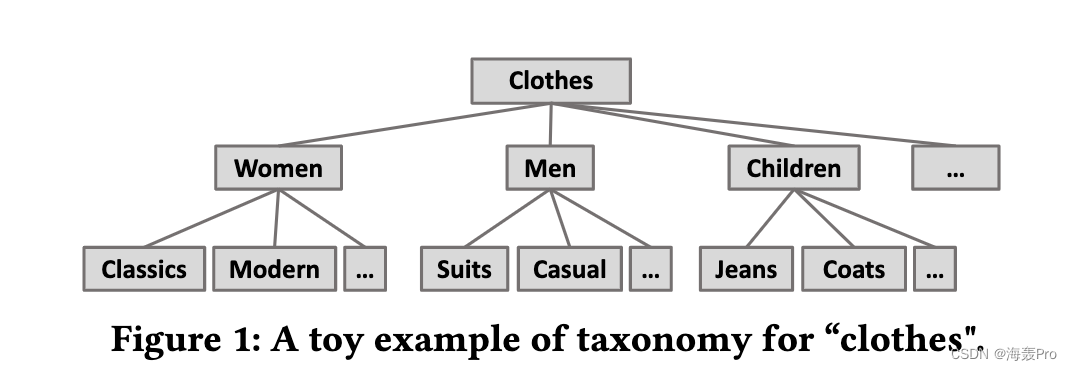

考虑到上述因素,在本文中,我们解决了通过分类归纳来解释网络嵌入的问题。分类法是一种结构化的知识组织,有助于信息搜索。

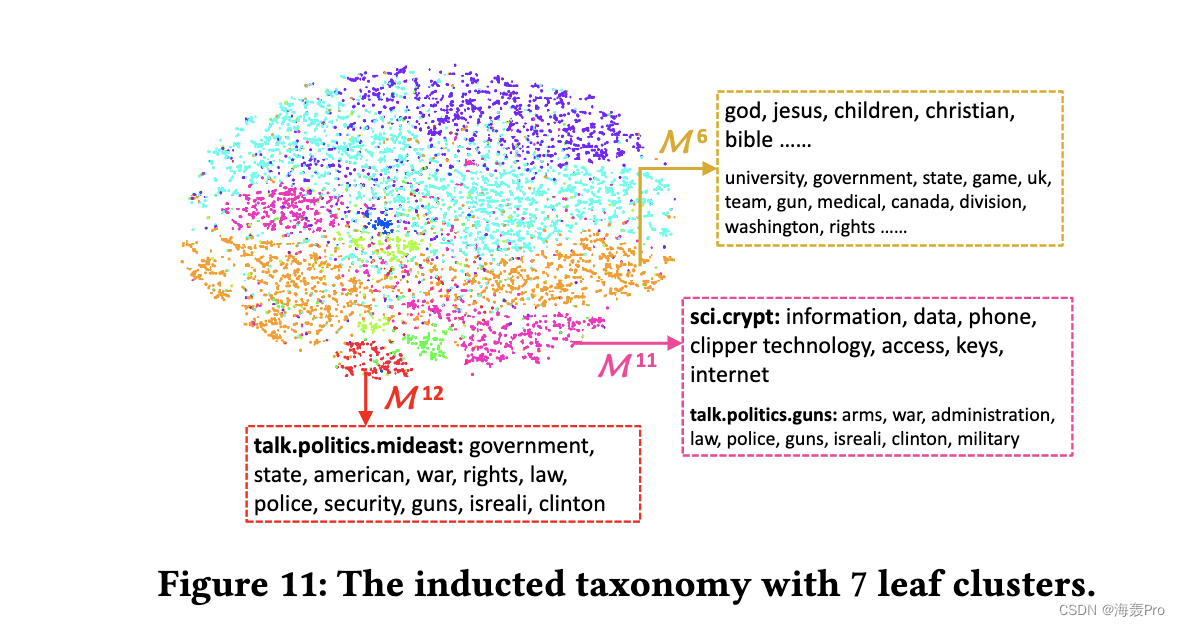

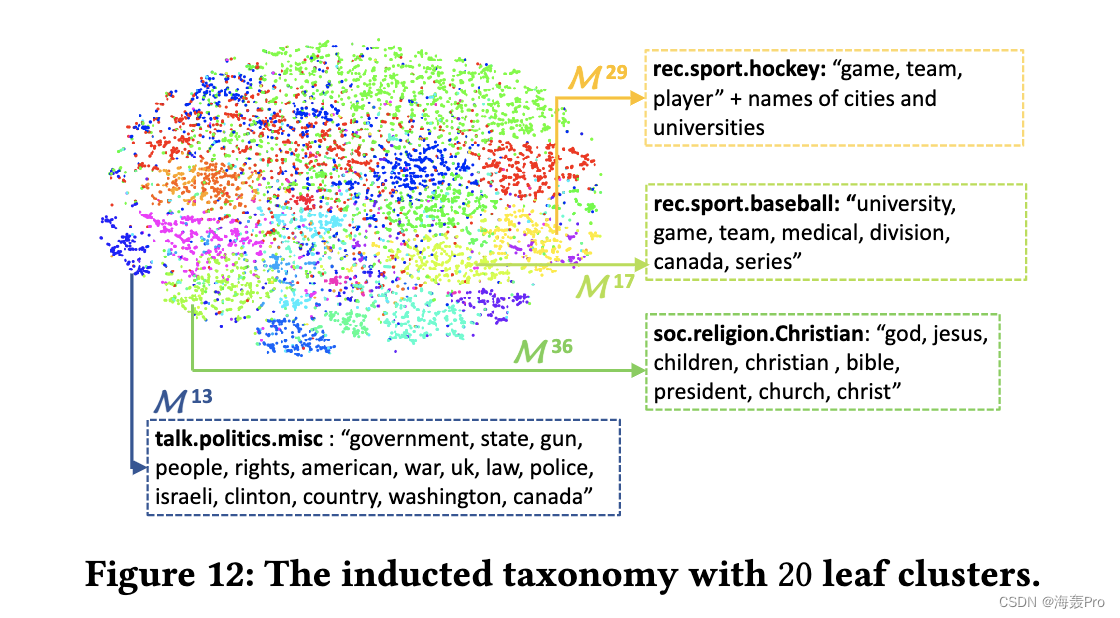

图 1 显示了一个分类示例,其中不同的类以层次结构组织,粗粒度的类逐渐分解为细化的类。

根据现有的分类构建工作 [10, 40, 44],我们将网络分析中的术语映射到分类归纳。我们将分类法中的“域”定义为手头的整个数据,包括网络 N 及其嵌入 Z。网络中的属性 X 和边 E 被视为“术语”,因为它们描述了节点的属性。分类的主干通常是“概念”的层次结构,它们对应于隐含在 Z 中的集群。所有节点的嵌入向量以迭代的方式划分为更小的集群。层次结构中的“上位词”关系由父集群和子集群之间的有向链接建模。通过这种方式,我们将嵌入中隐藏的隐含关系和模式提炼到显式的知识组织中。

分类归纳解决了第 2.2 节中提出的问题的两个方面。分类中的集群层次结构可以揭示嵌入实例如何在潜在空间中分布,同时总结每个集群的特征可以发现导致这种分布的因素。在本文中,我们特别将前一个方面称为全局视图解释,将后一个方面称为局部视图解释。

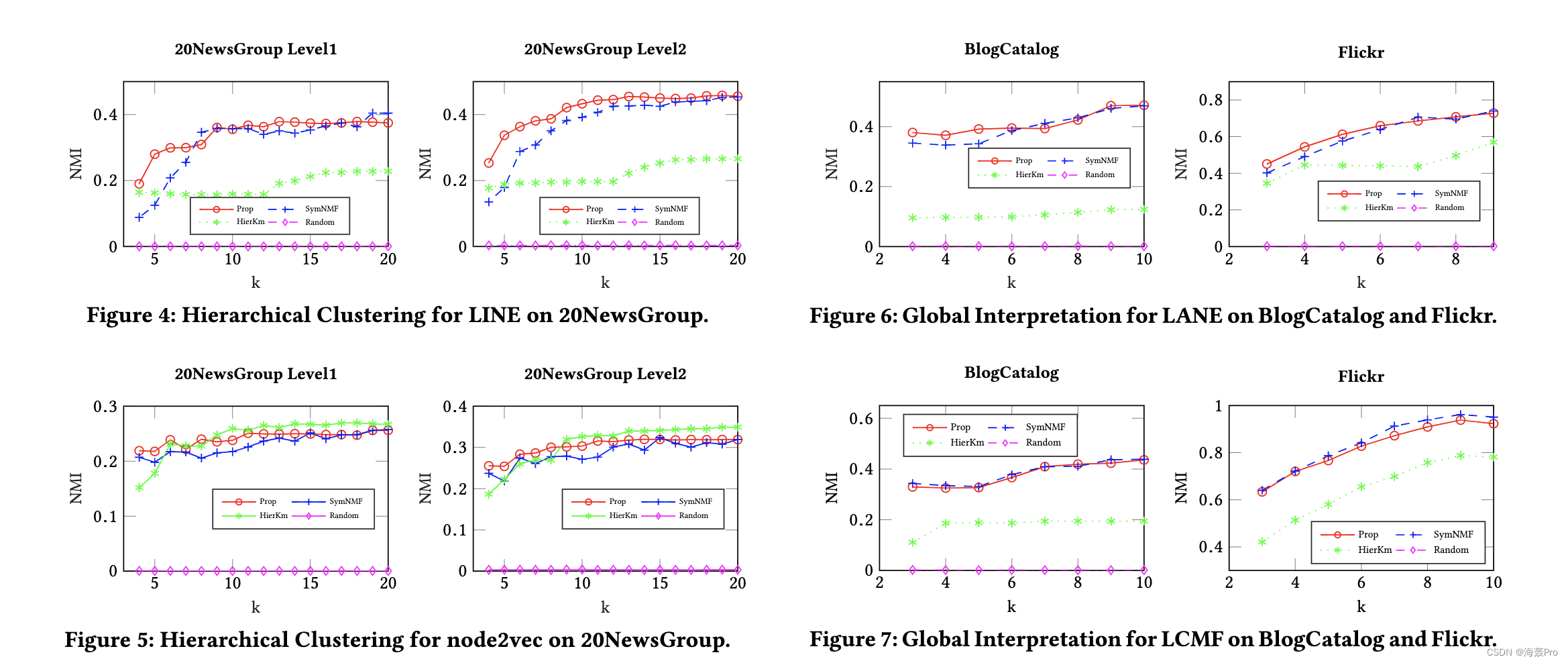

3 GLOBAL-VIEW INTERPRETATION

本节的目标是基于嵌入实例提取分类的主干。具体来说,主干被表示为嵌入空间中的集群层次结构。通过这种方式,我们可以更深入地了解节点在嵌入空间中的分布情况,并逐步揭示嵌入空间中节点之间的结构模式。

3.1 Embedding-based Graph Construction and Clustering

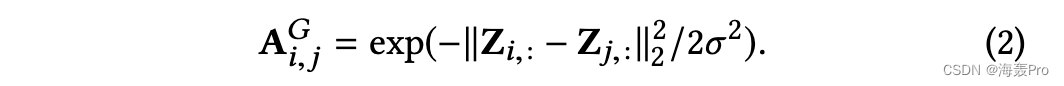

给定嵌入结果 Z,我们首先构建一个图 G,其亲和矩阵表示为 AG,以存储嵌入空间中的节点间相似性。每对节点之间的边权重定义为:

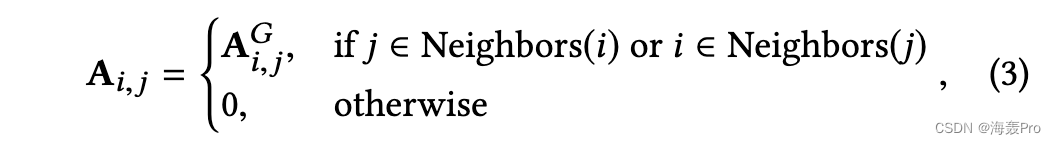

由于当节点数量很大时计算和存储所有节点对的权重可能会非常昂贵,因此我们只维护一个稀疏亲和矩阵,定义如下:

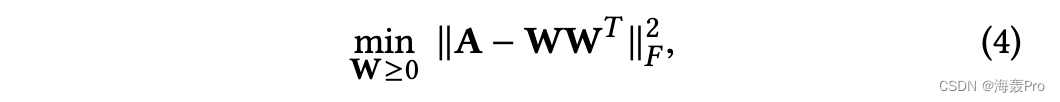

其中邻居的数量是|Neighbors(·)| = b ⌈log2 N ⌉ 根据[54],b为常数整数。得到的亲和矩阵 A 是对称的。通过解决以下问题得到embedding实例的簇结构:

其中 W ∈ RN ×C ,C 是簇数,∥ · ∥F 表示 Frobenius 范数。上述公式等效于在 Z 上执行核 K 均值聚类,正交约束 W = I 放松 [18]。 Wi,c 的值越大,表明节点 i 与集群 c 的关联性越强。

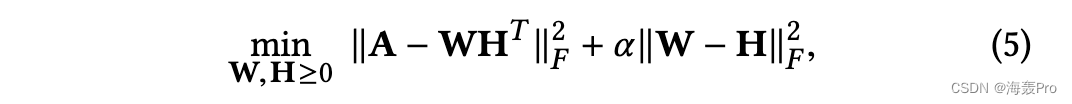

求解方程 4 是一个不平凡的问题,因为目标函数是一个关于 W 非凸的四阶函数,所以我们将问题重新表述如下:

其中 α > 0 控制近似误差和因子矩阵差异之间的权衡。传统的迭代优化方法,如坐标下降法[24, 36],可以通过交替更新 W 和 H 来解决问题。随着迭代的进行直到收敛,α的值逐渐增加以减小 W 和 H 之间的差异。

3.2 Hierarchy Establishment from Embedding-based Graph

我们不是在 G 上执行传统的平面聚类,而是利用分层策略递归地解析图。

原因有两个

- 首先,很难知道 G 中的最佳聚类数。通过采用层次聚类,我们避免了重新开始和穷举地尝试不同的 K 值,这通常很耗时。

- 其次,概念的多层次抽象自然存在于许多现实世界的网络中,例如电子商务网络中的产品目录和文档网络中的主题层次结构。此外,从业者可以根据自己的需要修剪得到的层次结构,这有助于解释用户和模型之间存在交互的地方。

我们采用前面提到的 NMF 算法以分层方式对 G 进行聚类,如算法 1 中总结的那样。初始化后(第 1~2 行),我们反复将大聚类分成较小的聚类。示例见图2。层次聚类过程的细节介绍如下:

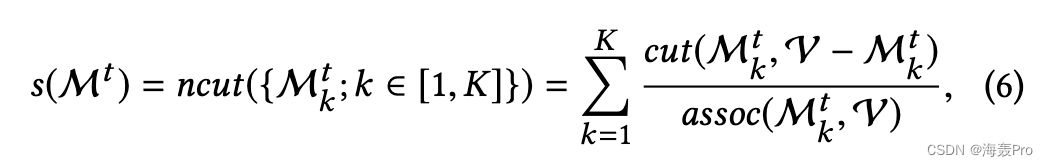

分区分数(第 4 行):在每一步 t,我们需要选择要分区的“最佳”集群。如果一个集群包含多个较小的集群组件,这些组件内部连接密集,内部连接松散,则它适用于进一步的分区。我们使用归一化切割 (ncut) [49] 作为分区分数 s(·):

其中 cut(M1, M2) = Íi ∈M1, j ∈M2 Ai, j 和 assoc(M, V) =Íi ∈M, j ∈V Ai, j 。这样,如果每个子簇 Mt k 与其他节点很好地隔离,则 cut(Mt k , V - Mt k ) 将很小。此外,如果 Mt k 内的节点连接良好,则 assoc(Mt k ,V) 很大,因为 assoc(Mt k , V) = assoc(Mt k , Mt k ) + cut(Mt k ,V − Mt k )。因此,划分分数最小的簇被分配了最高优先级以进一步分裂。

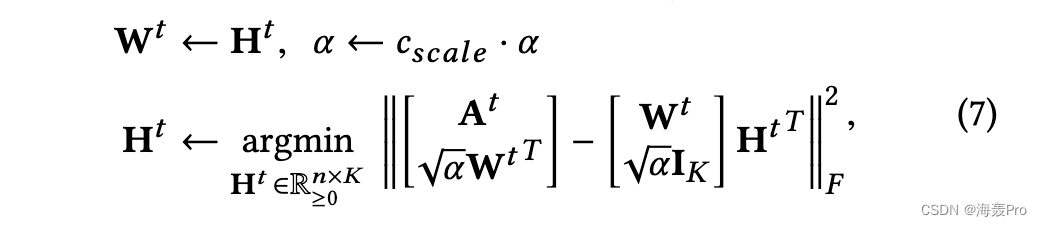

Rank-K NMF(第 7∼8, 14 行):设 At ∈ Rn×n 表示簇 Mt 的亲和矩阵,该矩阵在步骤 t 被选择进一步划分。 Mt 的大小为 n。我们将子簇的数量固定为K,因此每个分区步骤都转化为局部秩-K NMF 问题: minWt ,Ht ≥0 ∥At - Wt Ht T ∥2F + α ∥Wt - Ht ∥2F 。一般而言,在这项工作中,如果没有其他先验知识可用,我们设置 K = 2。在初始化 Ht 和 α 之后,NMF 问题以迭代方式解决,直到收敛 [31]:

其中 cscale e 略大于 1,因此 α 在整个迭代过程中不断增加,以迫使 Ht 和 Wt 逐渐彼此接近。这里 IK 是 K × K 单位矩阵。收敛后,我们将每个节点 i 分配给新的子集群ki = argmaxk Wi,k 。在分类树 T 中,新的 K 个子集群作为 Mt 的子集群附加。

异常值识别(第 9∼12、16 行):异常值会对聚类质量产生不利影响,因为它们很可能被分离为子簇,但通常不包含感兴趣的模式。如果子集群 Mt k 与其父集群相比其大小非常小(即 |Mt k | < γ |Mt | 和 0 < γ < 1)并且具有高分区分数(低优先级),我们将其视为异常值。我们最多持续排除异常值 I 轮,因此如果 Mt 的主要成分是异常值(即 i ≤ I 不成立),则不会对 Mt 进行分区。

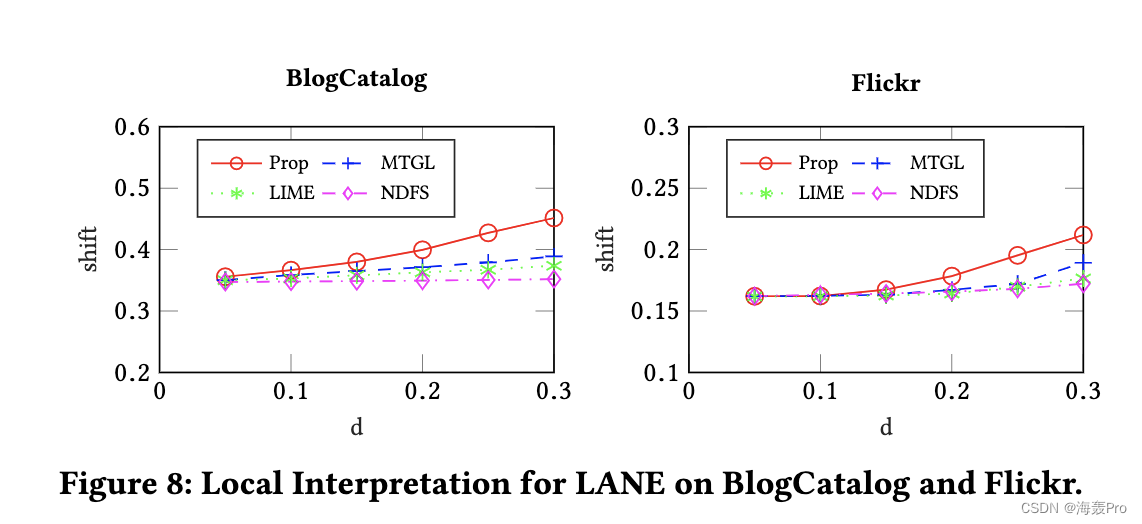

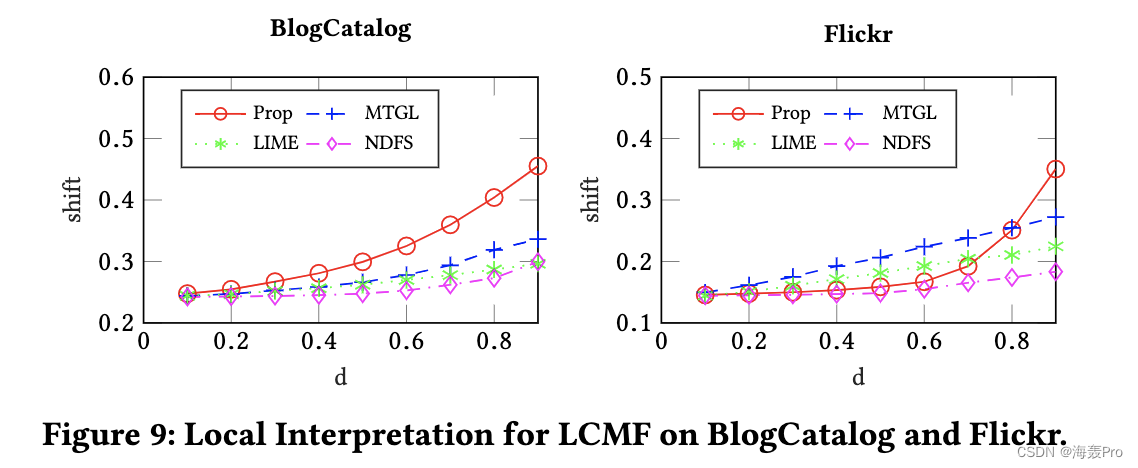

4 LOCAL-VIEW INTERPRETATION

在上一节中,我们讨论了如何通过层次聚类获得分类学的主干。在本节中,我们专注于分类中的每个集群,以总结其独特的特征或属性。

具体来说,我们利用节点属性来描述集群的属性。节点属性的典型例子包括社交网络中的用户档案信息、电子商务网络中的产品评论以及学术网络中学者的研究领域。使用节点属性来描述嵌入空间中集群的属性的原因是双重的。首先,许多网络嵌入算法已经结合属性信息来学习信息嵌入表示[25、26、29、56、58]。在这种情况下,我们的目标是找到导致嵌入结果的重要内容。其次,根据网络同质性原理[42],具有相似属性的节点更有可能相互链接。因此,即使嵌入算法没有明确利用节点属性信息,我们仍然可以使用它来获得对所获得集群的明显理解。

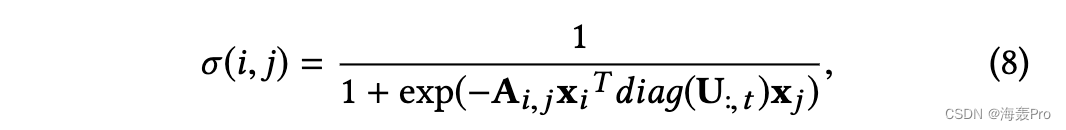

我们解决了将集群表征为多任务特征选择问题的问题。这里的“特征”是指节点属性。然后,每个集群的特征在于集群中大多数节点共享的重要属性。由全局视图解释识别的集群结构提供了支持以监督方式实施特征选择的判别信息。具体而言,令 Y ∈ RN ×C 表示类标签矩阵,其中如果节点 n 属于集群 Mt,则 Yn,t = 1,否则 Yn,t = 0。这里 C 是任务数。如果我们要描述分类法中的所有簇,则 C 等于树 T 中内部节点和叶节点的总数。令 U ∈ RM ×C 表示属性权重矩阵,其中 Um 表示属性 m 在集群 Mt 中的重要性。对于某个簇 Mt 内的一对节点 i,j,嵌入空间中节点相似度与所选特征空间中节点相似度的一致性可以量化为:

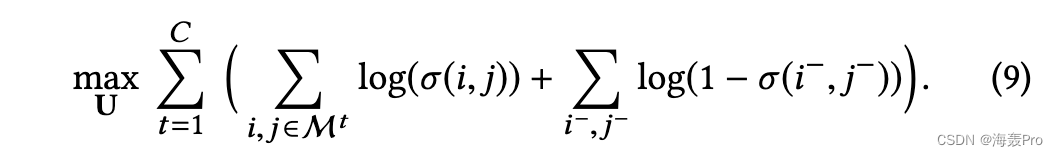

其中 diaä(U:,t ) 将列向量 U:,t 转换为对角矩阵形式。 xi T diaä(U:,t )xj 是由 U:,t 加权的 i 和 j 的属性之间的相似度,而 Ai, j 是图 G 中实例 i 和 j 之间的边缘强度。那么目标函数关于U 给出如下:

样本 i- 和 j- 是来自其他集群的负样本。通过优化上述目标函数,我们获得了为每个集群 Mt 选择重要属性子集的 U,使得所选特征空间中的节点接近度与嵌入空间中的接近度一致。

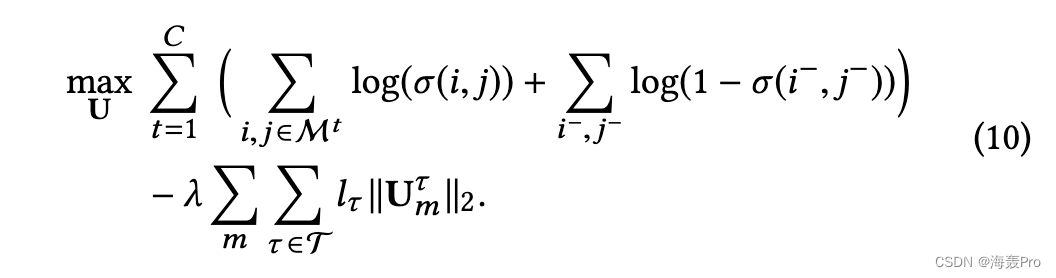

为了利用分类法中包含的层次结构,需要一些约束来规范 U:,t 。 LetP = (t0, t1, t2, …, th ) 表示分类树 T 中从根到叶的路径,其中 ti 表示树节点,ti−1 是 ti 的父节点。如果 ti 和 tj 位于同一条路径 P 上,则期望两个簇 Mti 和 Mtj 具有一些共同特征。示例如图 3 所示。对于 M5,其重要属性是 x3,而 x3 也是其重要属性之一M2 和 M1 因为它们在相同的根到叶路径中。为了将基于树的结构的先验知识纳入分类学,我们将基于树的组套索正则化 [28] 引入目标函数。因此,局部视图解释的总体目标函数公式为:

对于正则化项,Uτm 是权重系数的向量{Um,t : t ∈ τ },其中 τ 指的是分类 T 中的树节点。如果簇 Mt 是 Mτ 的一部分,Heret ∈ τ 。这也意味着如果 t ∈ τ ,则 t ∈ parent(τ )。考虑到树结构,一种选择负样本 i- 和 j- 的方法,w.r.t. i, j ∈ Mt 是从与 Mt 不在同一路径中的簇中采样。

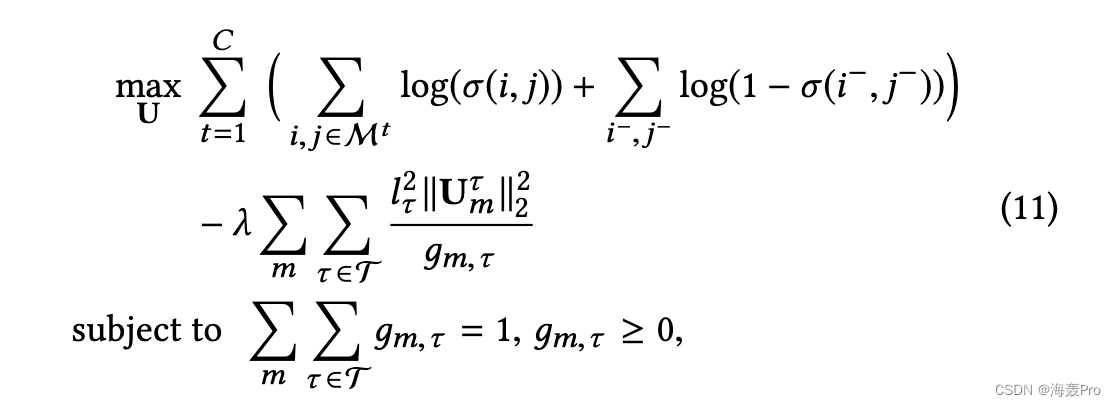

由于存在 L1/L2 范数正则化项,上述优化问题是不光滑的,因此难以优化。因此,我们使用之前为组套索 [2] 引入的替代公式:

其中引入了附加变量 {äm,τ}。设置 lτ 的方法在[28]中提出。然后通过交替优化 U 和 äm,τ 来解决上述问题,如算法 2 所示。在每次迭代中,我们首先将系数 äm,τ 保持为常数,并使用随机梯度下降更新每一列 U:,t。然后我们固定 U 并更新 äm,τ ,其中更新方程在算法 2 的第 6 行中给出。

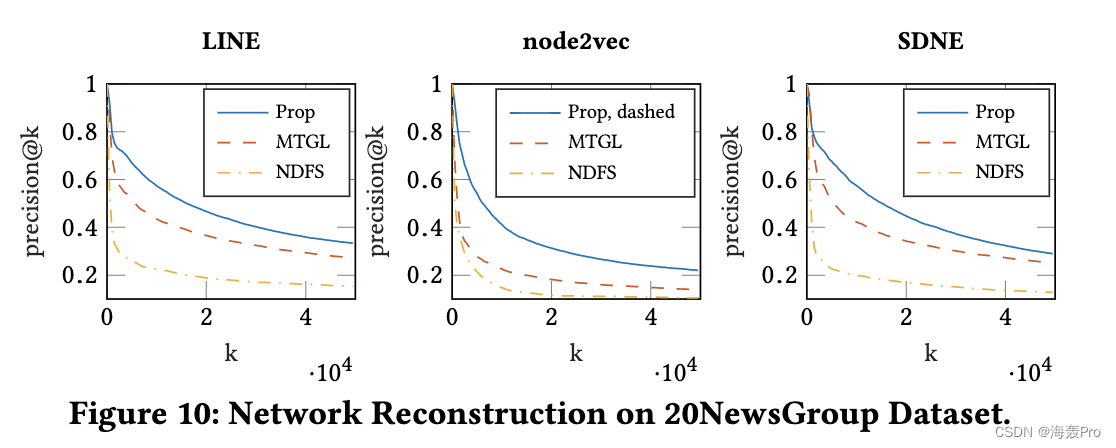

5 EXPERIMENTS

我们在现实世界的数据集上定量评估了所提出的解释框架的有效性。还实施了案例研究,以直观地显示解释结果。

6 RELATED WORK

网络嵌入最近因其在生成信息节点表示方面的有效性而受到越来越多的关注。根据保存的信息类型,网络嵌入方法可以分为几类[17]。首先,一些方法将拓扑结构编码为嵌入向量,例如各种接近顺序[29、46、48、52、55]、传递性[45]、社区结构[56]和节点的结构角色[22]。这里的一阶邻近度通常是指节点之间的直接联系,而高阶邻近度是指各个范围的节点邻域。其次,一些方法结合了网络的丰富边信息,例如节点和边的属性[25、34、58],以及节点的标签[26]。第三,一些现有的工作使用具有异构节点的网络对不同类型的对象进行建模,并联合学习嵌入向量[12、19、51]。网络嵌入已被证明在解决链路预测 [55]、节点分类 [22、52] 和网络对齐 [14] 等问题方面是可行的。

尽管性能优越且应用广泛,但许多流行的 ML 模型(例如深度模型)对最终用户来说仍然主要是黑盒 [13,39,47]。现有的机器学习解释方法侧重于解释分类和预测模型。这些方法主要集中在:1)解释模型建立后的工作机制或学到的概念[13、27、43]; 2) 提取个体预测的重要特征或规则[3, 15, 38, 47]。具体来说,对于前一类,一些方法为每个类选择有代表性的样本来构建不同类的概念 [27, 33],而一些方法利用模型压缩从复杂模型中提取或重构人类可理解的知识 [9, 13] .可视化技术可以与解释方法一起使用,以促进对数据的描述和对网络中意义构建模式的探索。主要思想是将数据投影到极低维(2D 或 3D)的空间中。一些具有代表性的技术包括主成分分析 [1]、非线性方法,如 Isomap [53]、Laplacian Eigenmaps [6]、t-SNE [41] 和 LargeVis [50]。

7 CONCLUSION AND FUTURE WORK

在本文中,我们提出了一种新的事后解释框架来理解网络嵌入。我们将问题表述为嵌入结果的分类归纳。我们首先从嵌入构建一个图 G,将嵌入实例之间的关系编码为图边权重。通过在图 G 上执行层次聚类,将分类的主干构造为树。分类中的聚类特征被识别为具有基于树的正则化的多任务回归问题。对真实世界数据集的定量评估和案例研究证明了所提出框架的有效性。

未来一些解释网络嵌入的工作如下。首先,可以开发更复杂的层次聚类方法来提取更准确的结构层次。其次,除了节点属性外,还可以进一步利用基于网络结构特征的解释。第三,将嵌入解释与现有的机器学习解释相结合也是一个有前途的方向。

结语

文章仅作为个人学习笔记记录,记录从0到1的一个过程

希望对您有一点点帮助,如有错误欢迎小伙伴指正

- 点赞

- 收藏

- 关注作者

评论(0)