Flink伪分布式环境搭建及应用,Standlong(开发测试)

【摘要】 🍬博主介绍👨🎓 博主简介:大数据高级开发工程师、CSDN大数据领域新星创作者、阿里云专家博主✨主攻领域:【大数据】【java】【python】【面试分析】 一、 架构图Flink程序需要提交程序给 JobClientJobClient 将作业提交给 JobManangerJobManager负责协调资源分配和作业执行. 资源分配完成后, 任务将提交给对应的TaskManagerTas...

🍬博主介绍

👨🎓 博主简介:大数据高级开发工程师、CSDN大数据领域新星创作者、阿里云专家博主

✨主攻领域:【大数据】【java】【python】【面试分析】

一、 架构图

-

- Flink程序需要提交程序给 JobClient

-

- JobClient 将作业提交给 JobMananger

-

- JobManager负责协调资源分配和作业执行. 资源分配完成后, 任务将提交给对应的TaskManager

-

- TaskManager 启动一个线程开始执行. TaskManager会向JobManager报告状态更改. 例如开始执行, 正在进行或已完成.

-

- 作业完成后, 结果将发送回客户端. (JobClient)

Standlong 模式Flink的各个角色都是独立进程.

二、环境准备

- jdk1.8 及以上 [配置 JAVA_HOME环境变量]

- SSH免密码登录 [集群内节点之间免密码登录]

三、下载安装包

https://archive.apache.org/dist/flink/flink-1.14.0/flink-1.14.0-bin-scala_2.12.tgz

四、 服务器规划

| 角色 | Master | Slave |

|---|---|---|

| 服务器 | node1 | node1 |

五、 安装步骤

1.创建统一工作目录

mkdir -p /export/server # 软件安装路径

mkdir -p /export/software # 数据存储路径

mkdir -p /export/data # 安装包存放路径

2. 下载 flink 安装包

https://archive.apache.org/dist/flink/flink-1.14.0/flink-1.14.0-bin-scala_2.12.tgz

3. 上传Flink压缩包到指定目录

/export/software

4. 解压缩flink到 /export/server 目录

cd /export/software/

tar -zxf flink-1.14.0-bin-scala_2.12.tgz -C /export/server/

cd /export/server/

ll | grep flink

5. 改名或创建软链接:方便后期升级

ln -s /export/server/flink-1.14.0/ /export/server/flink

cd /export/server/ && ll | grep flink

六、flink初体验(使用)

1. 启动Flink

cd /export/server/flink

./bin/start-cluster.sh

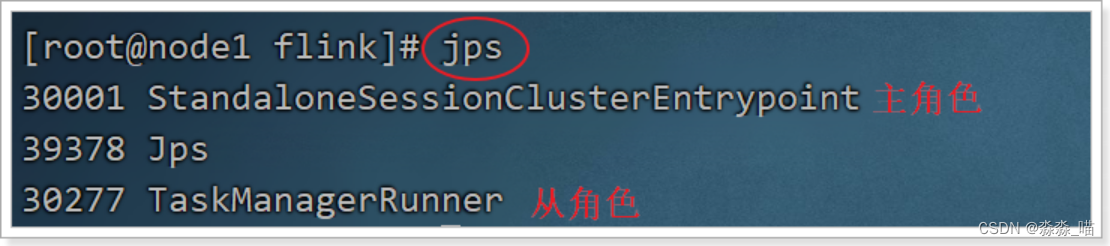

2. 通过jps查看进程信息

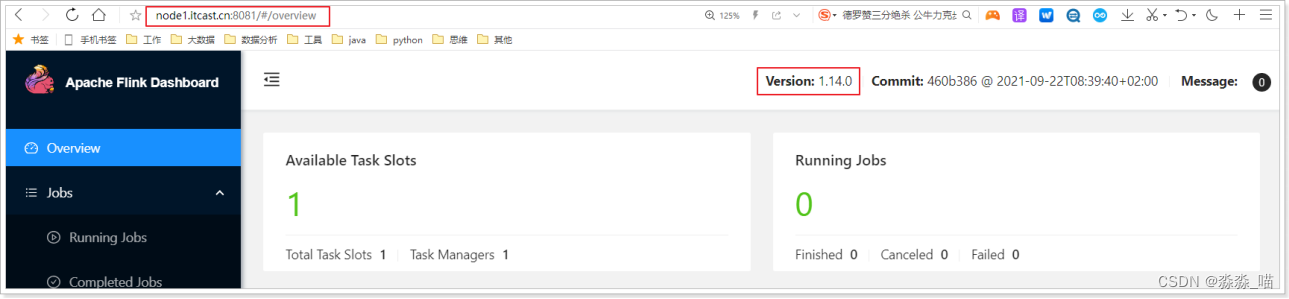

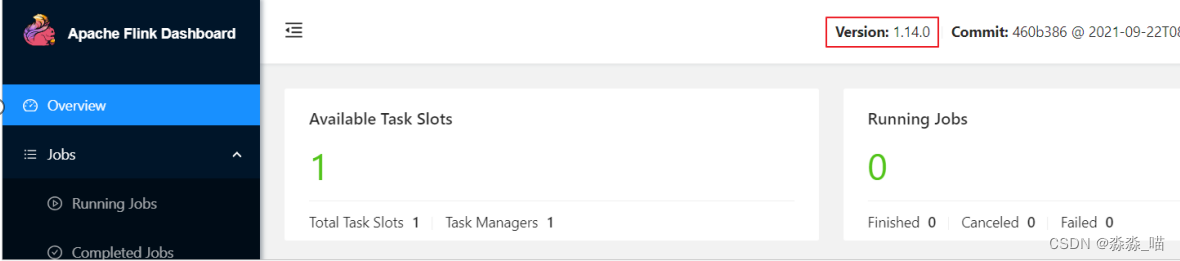

3. 访问web界面

4. 官网提供案例的位置

ll /export/server/flink/examples/

5. 运行官方案例

cd /export/server/flink

bin/flink run examples/batch/WordCount.jar

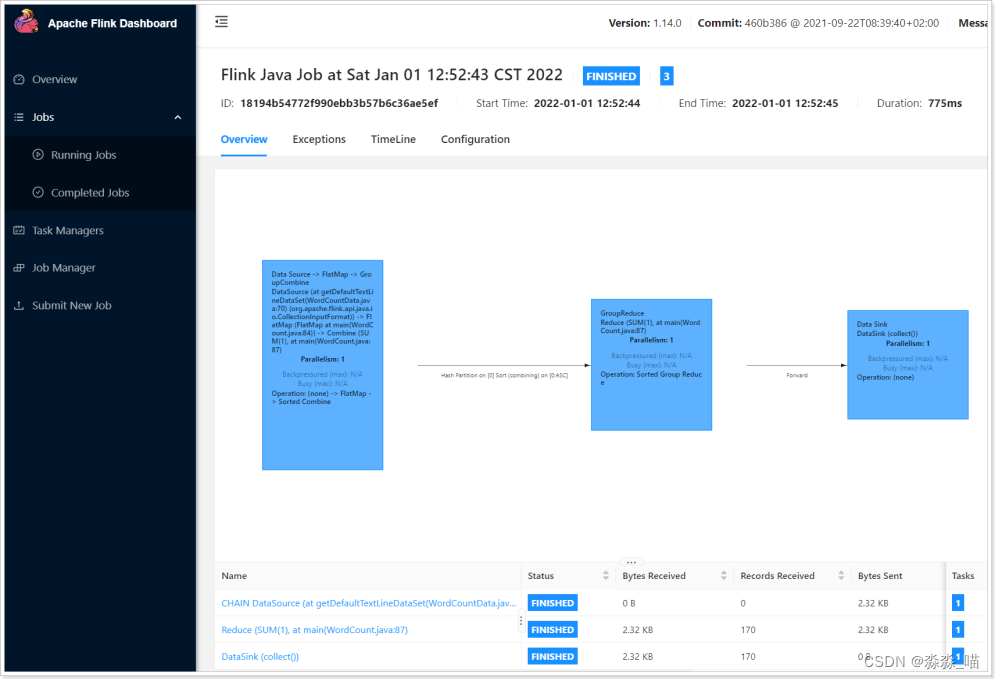

6. 在浏览器查看job详情

点击 job, 就可以查看详情

7. 查看job日志信息

ll /export/server/flink/log

**** client****.log 是客户端日志 **** standalonesession****.log 是主节点日志 **** taskexecutor****.log 是从节点日志

1.3.6.2.13.关闭flink

cd /export/server/flink

bin/stop-cluster.sh

jps

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)