Hadoop入门(五):集群配置

集群配置

目标

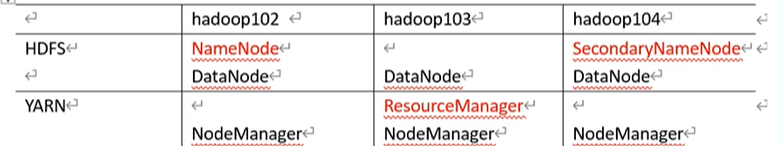

建立三个hadoop之间的连接,前面是配置使得他们独立,现在把相关的配置到一起:

相关说明:

- NameNode 和 SecondaryNameNode 不要安装在同一台服务器(它们两个都需要耗内存,分开减少集群的压力

- ResourceManager 也很消耗内存,不要和 NameNode、SecondaryNameNode 配置在同一台机器上。

配置说明

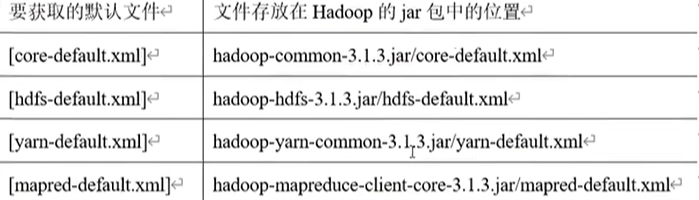

默认配置:

自定义配置文件:

core-site.xml 、hdfs-site.xml 、yarn-site.xml 、mapred-site.xml 四个配置文件存放在

$HADOOP_HOME/etc/hadoop 这个路径上,用户可以根据项目需求重新进行修改配置。

配置集群

核心配置文件

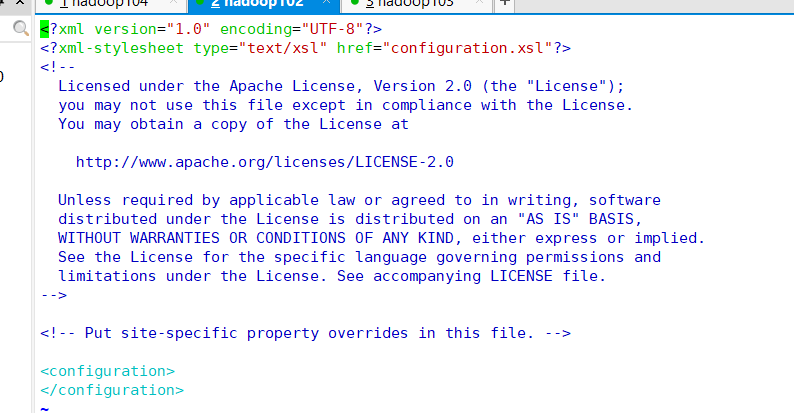

先配置hadoop102,cd到目录下:

cd $HADOOP_HOME/etc/hadoop

- 1

编写文件:

vim core-site.xml

- 1

可以看如下:

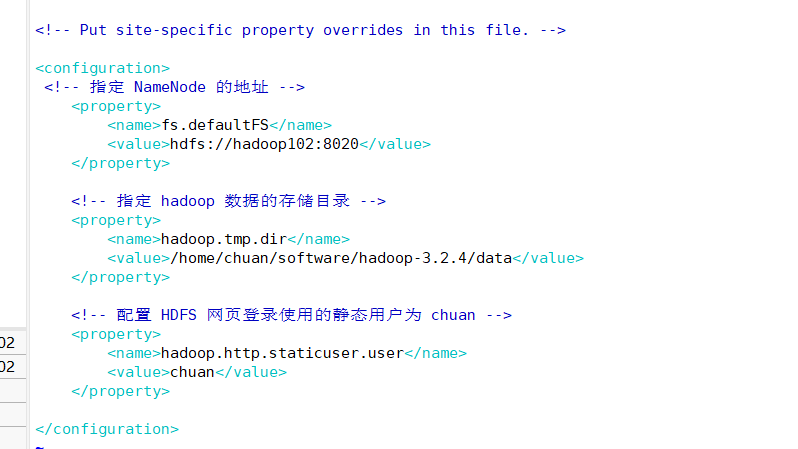

添加内容:

<!-- 指定 NameNode 的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop102:8020</value>

</property>

<!-- 指定 hadoop 数据的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/chuan/software/hadoop-3.2.4/data</value>

</property>

<!-- 配置 HDFS 网页登录使用的静态用户为 chuan -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>chuan</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

如下:

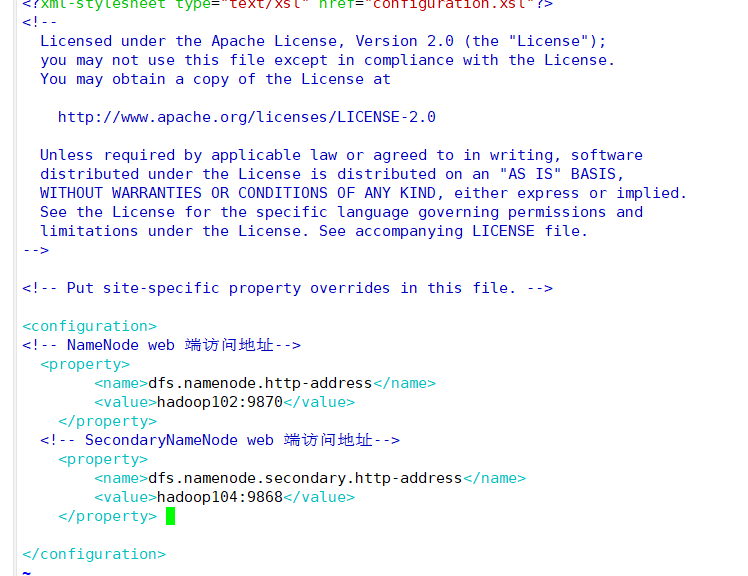

HDFS配置

vim hdfs-site.xml

- 1

核心配置文件中NameNode地址hdfs://hadoop102:8020相当于是hadoop内部通讯地址,

现在NameNode是HDFS需要用户在web界面上访问,不需要操作命令行,即也需要对外暴露一个接口hadoop102:9870

添加内容:

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop102:9870</value>

</property>

<!-- SecondaryNameNode web 端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:9868</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

如下:

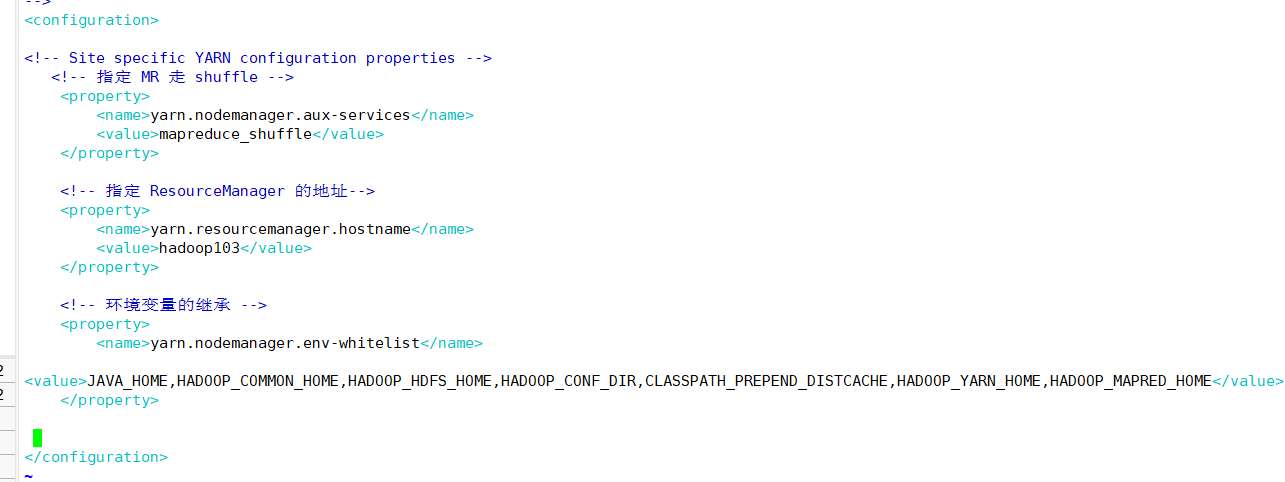

YARN配置

vim yarn-site.xml

- 1

添加内容:

<!-- 指定 MR 走 shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

如下:

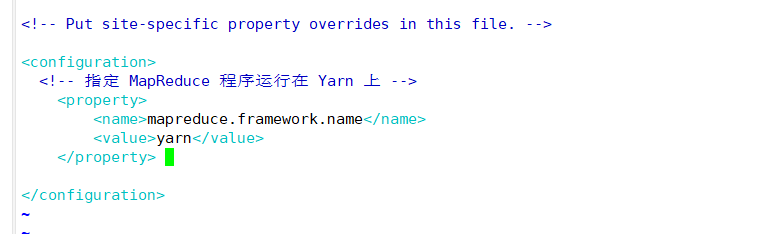

MapReduce 配置

vim mapred-site.xml

- 1

添加内容:

<!-- 指定 MapReduce 程序运行在 Yarn 上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

如下:

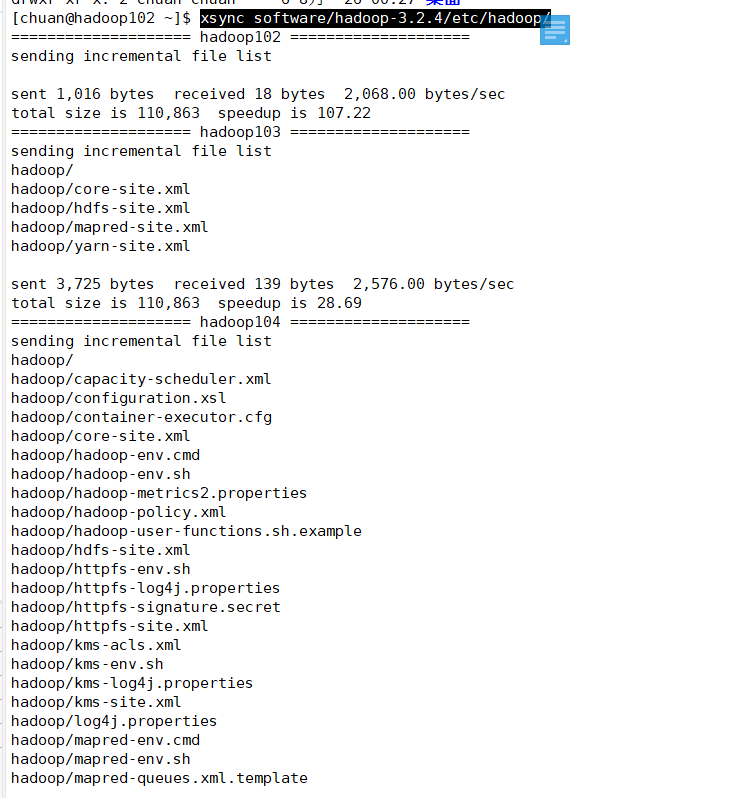

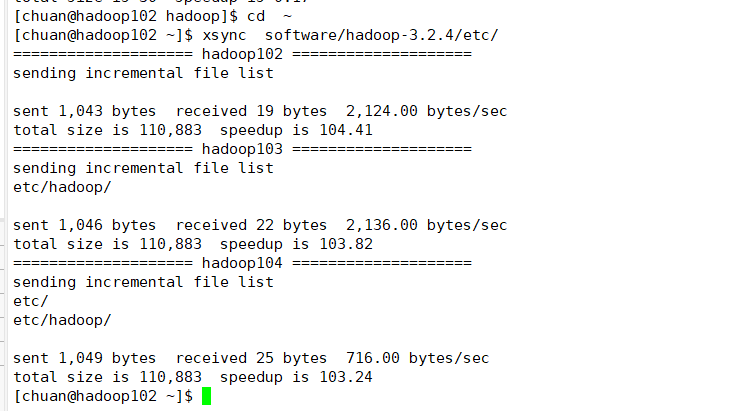

分发配置文件

xsync software/hadoop-3.2.4/etc/hadoop/

- 1

如下:

可以去hadoop103和hadoop104上检查一下是否成功:

cat software/hadoop-3.2.4/etc/hadoop/core-site.xml

- 1

如下:

现在未知,集群的配置就完成了。

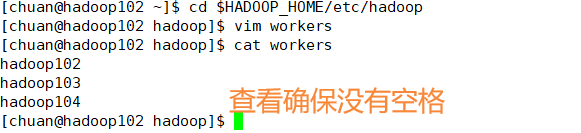

配置workers

在启动集群前需要配置workers

进入目录:

cd $HADOOP_HOME/etc/hadoop

- 1

编写workers:

vim workers

- 1

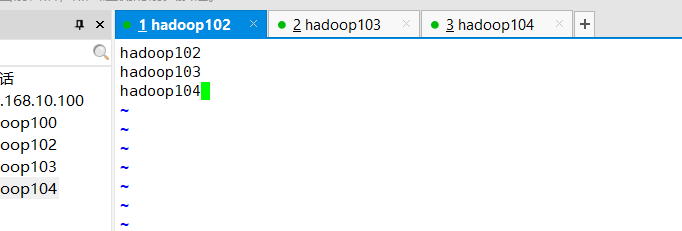

如下:

删除,内容修改为:

hadoop102

hadoop103

hadoop104

- 1

- 2

- 3

如下:

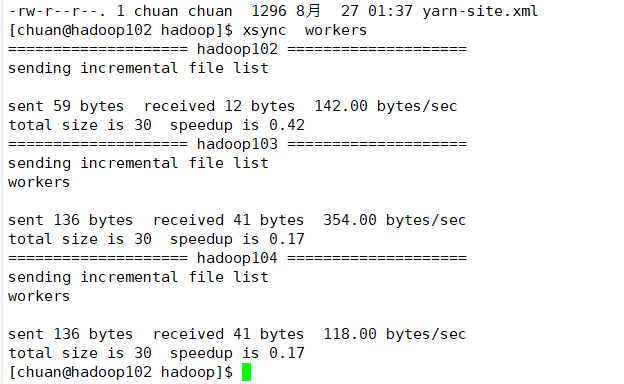

分发

xsync workers

- 1

如下:

回到根目录

cd ~

- 1

同步所有节点配置文件

xsync software/hadoop-3.2.4/etc/

- 1

如下:

启动集群

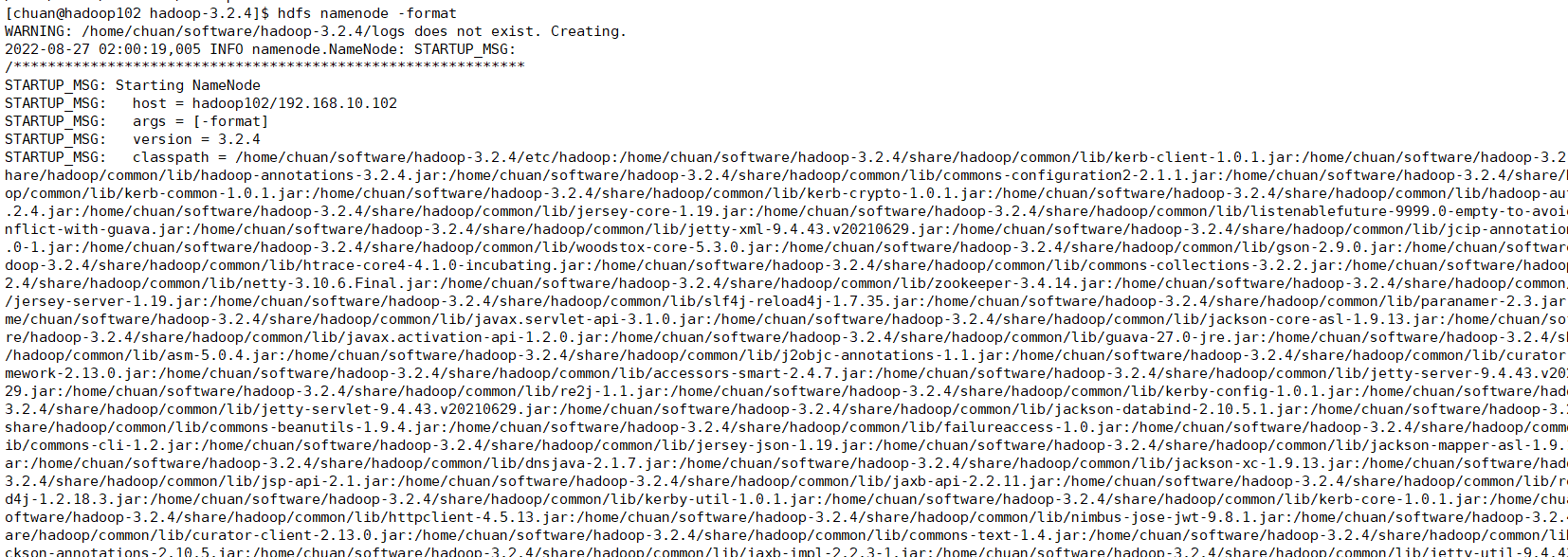

初始化

hdfs namenode -format

- 1

如下:

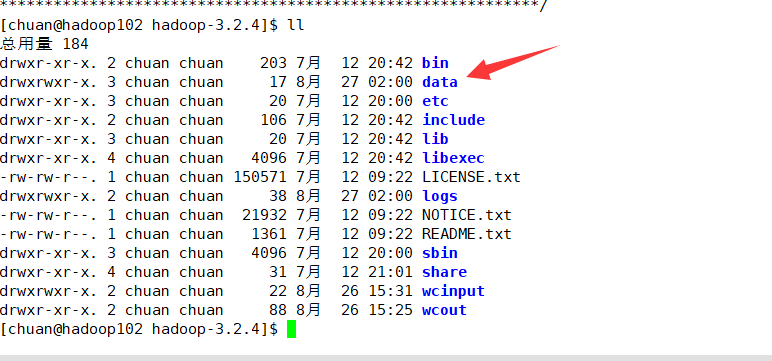

可见多了一个data文件夹和logs文件夹:

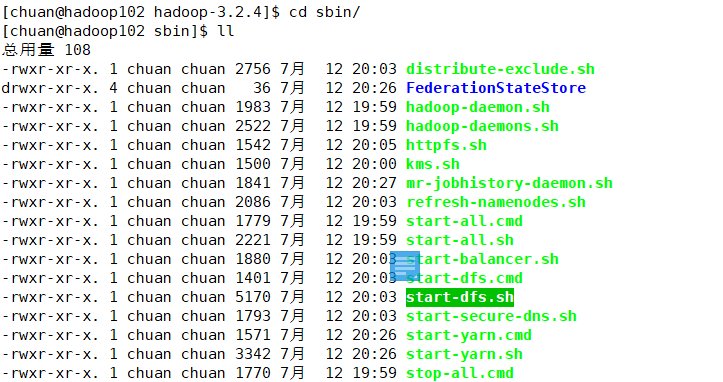

启动集群

进入目录:

cd sbin/

- 1

如下:

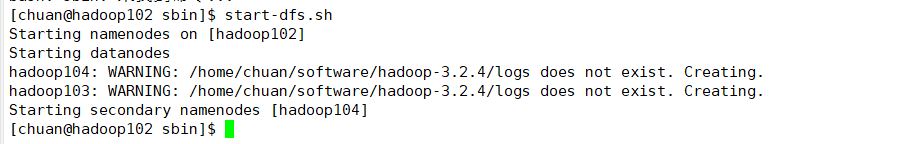

启动:

start-dfs.sh

- 1

如下:

启动完毕~

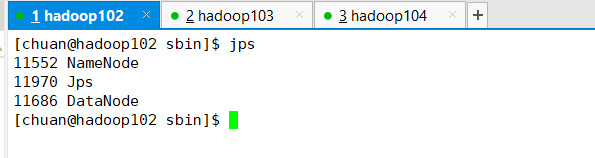

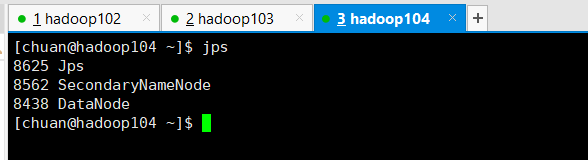

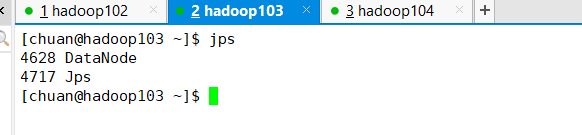

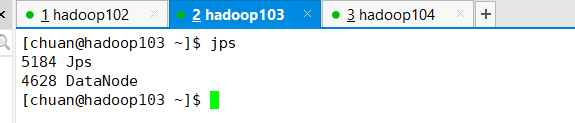

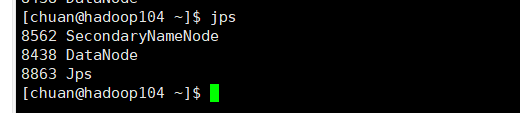

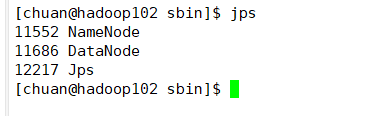

用jps查看102,103,104

结果与前面的目标一直:

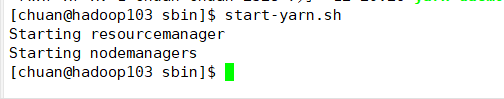

ResourceManager节点启动 YARN

也就是Hadoop103上面启动:

start-yarn.sh

- 1

如下:

用jps查看102,103,104

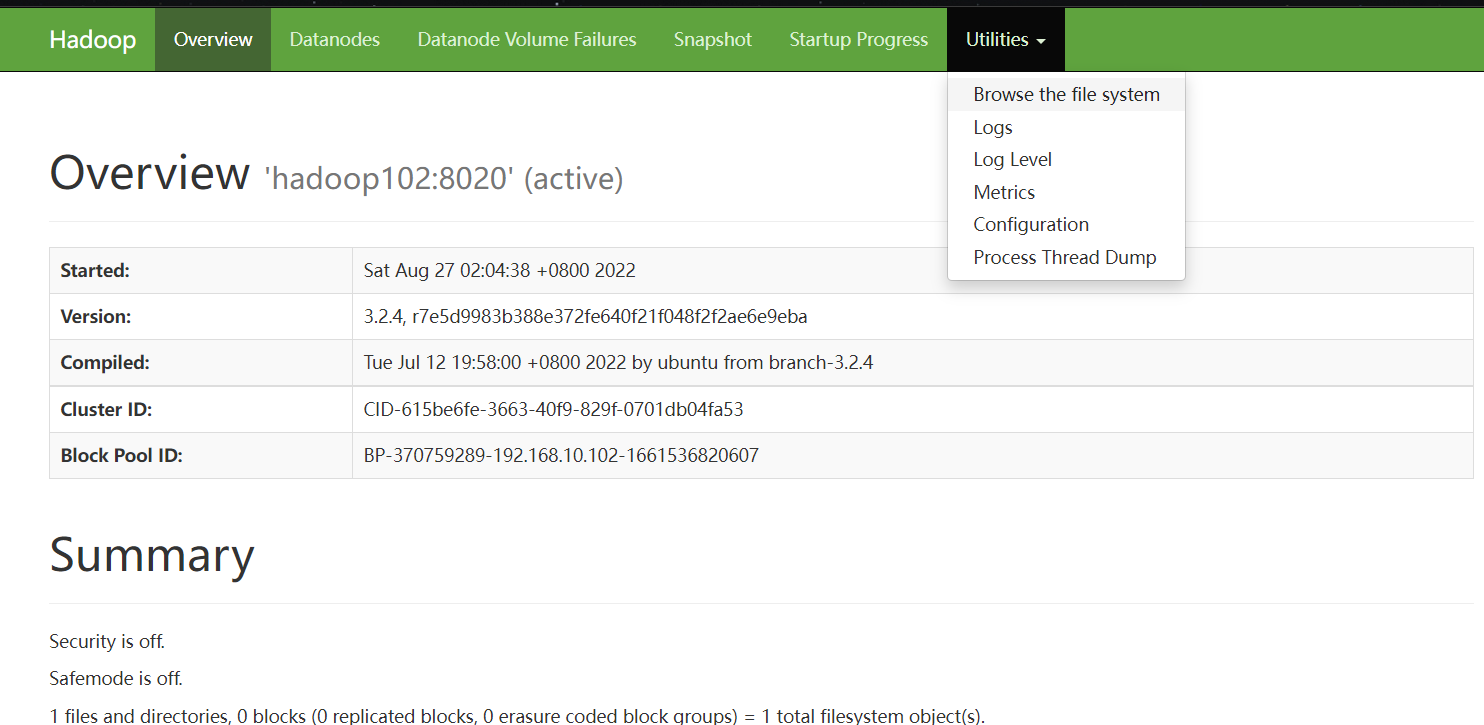

Web 查看 HDFS 的 NameNode

浏览器输入如下查看 HDFS 上存储的数据信息:

http://hadoop102:9870

- 1

如下:

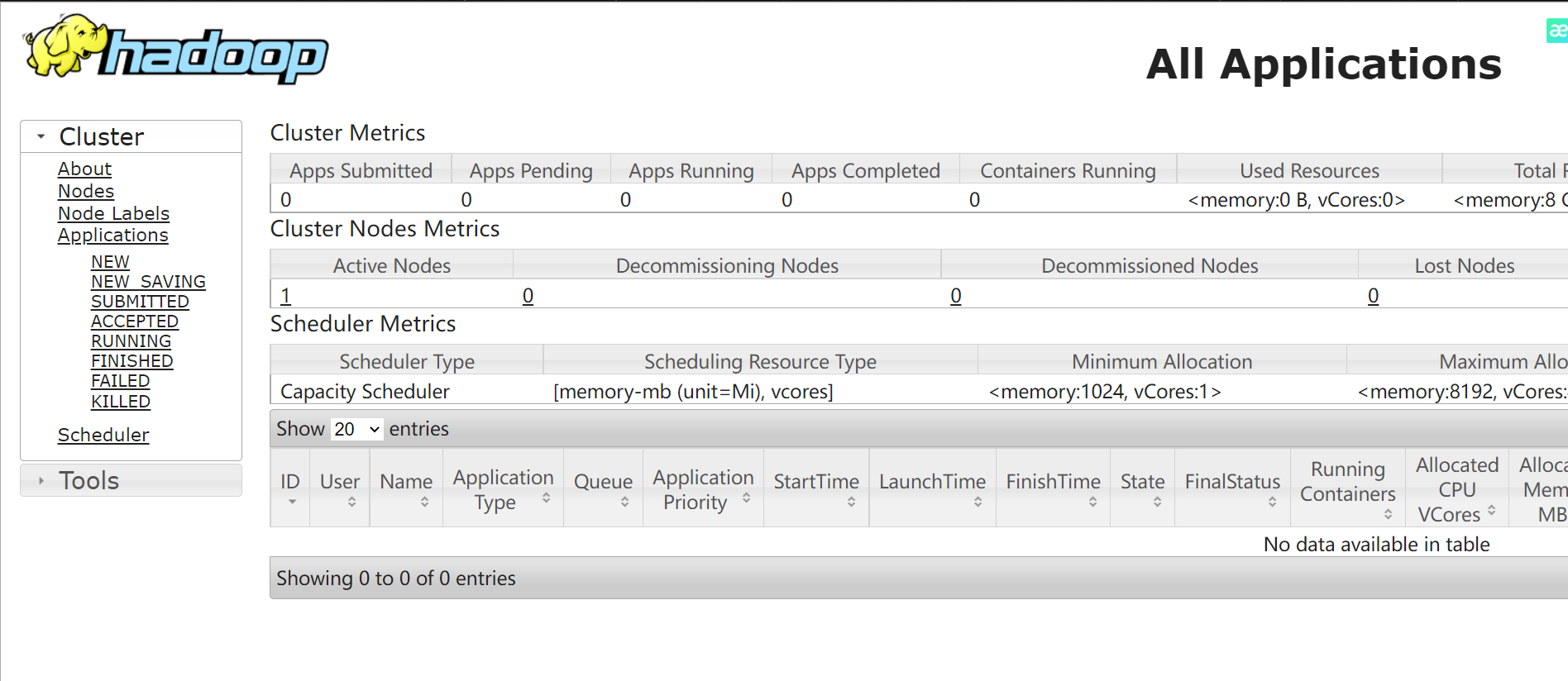

Web 端查看 YARN 的 ResourceManager

http://hadoop103:8088可以查看,如下:

如果你打不开,肯定是配置问题了,我遇到已经解决,请查看:yarn启动后用jps查看没有resourcemanager

文章来源: chuanchuan.blog.csdn.net,作者:川川菜鸟,版权归原作者所有,如需转载,请联系作者。

原文链接:chuanchuan.blog.csdn.net/article/details/126552728

- 点赞

- 收藏

- 关注作者

评论(0)