pytorch学习笔记(三):反向传播

【摘要】

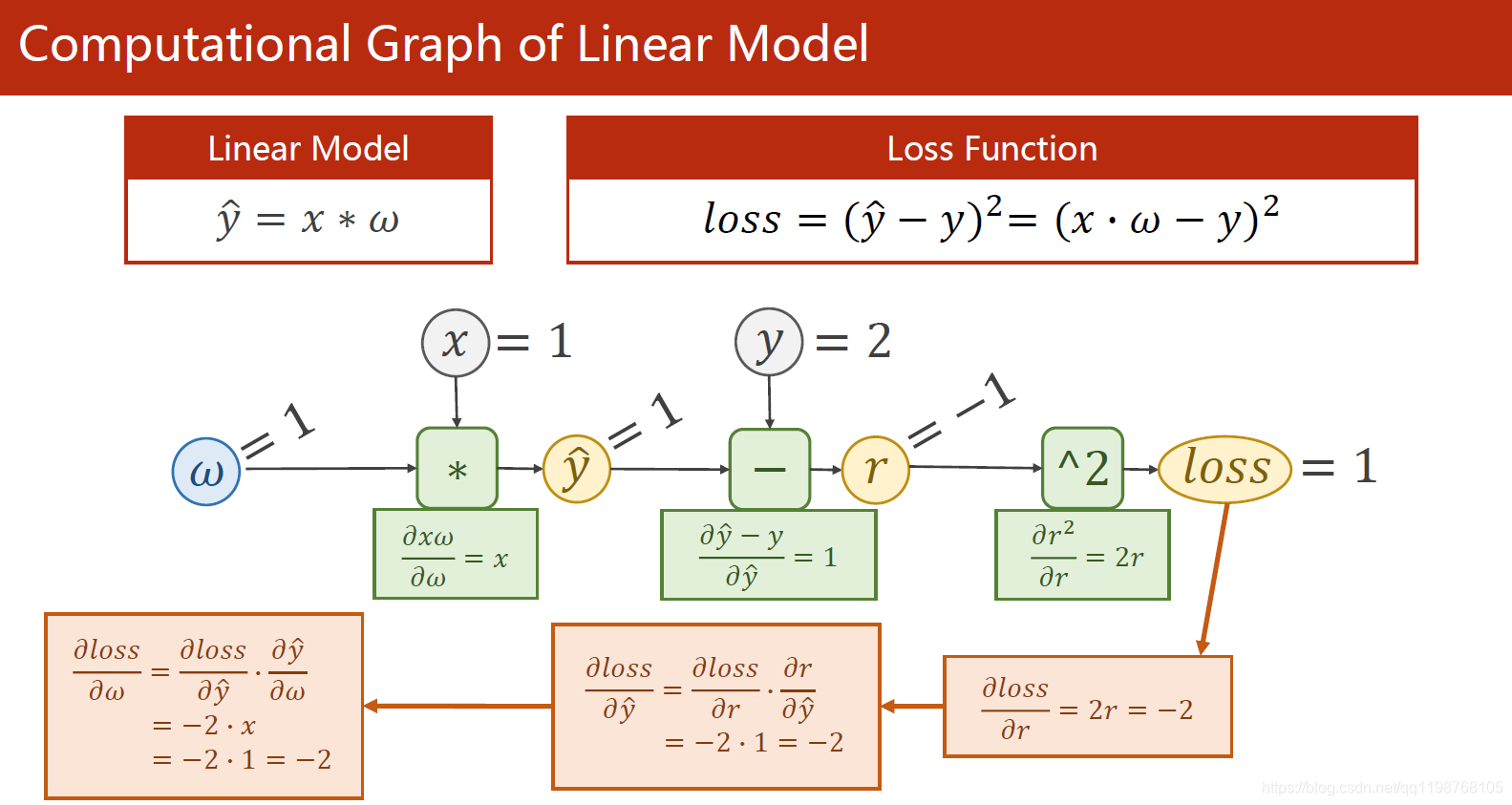

关于前馈和反相传播的原理,下面这张实例非常清楚:

import torch

import matplotlib.pyplot as plt

x_data = [1.0,2.0,3.0]

y_data...

关于前馈和反相传播的原理,下面这张实例非常清楚:

import torch

import matplotlib.pyplot as plt

x_data = [1.0,2.0,3.0]

y_data = [2.0,4.0,6.0]

w = torch.Tensor([1.0])

w.requires_grad = True # 需要计算梯度

def forward(x):

return x * w

def loss(x, y):

y_pred = forward(x)

return (y_pred - y) ** 2

print("predict (before training)", 4, forward(4).item())

for epoch in range(100):

for x, y in zip(x_data, y_data):

l = loss(x, y)

l.backward()

print('\tgrad:', x, y, w.grad.item())

w.data = w.data - 0.01 * w.grad.data

w.grad.data.zero_() #每一步传完,梯度清零很重要

print("progress:", epoch, l.item())

print("predict (after training)", 4, forward(4).item())

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

细节提要:

Tensor张量可以视作数据结构:数据data + 梯度grad(grad也是张量)

核心代码:l.backward()反向传播,程序自动求出所有需要的梯度

w.grad.data.zero_()每步做完清零很重要,否则影响下一次求的梯度

文章来源: zstar.blog.csdn.net,作者:zstar-_,版权归原作者所有,如需转载,请联系作者。

原文链接:zstar.blog.csdn.net/article/details/116568191

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)