python爬虫探索原神世界二(角色同人篇)

一、前言

上一篇讲到用python爬虫打开了角色篇的大门,今天我们就来看一下,角色的同人图。

二、页面分析

首先,打开米游社

找到同人图里的精华部分,对页面进行检查分析

随着鼠标在图片页面的滑动,右侧会多出一些json数据。

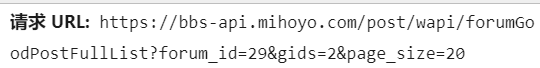

我们需要用到的数据,第一个便是请求URL,为了爬取的多一些,我们只用到?这里,即

https://bbs-api.mihoyo.com/post/wapi/forumGoodPostFullList?

之后我们需要看一下其它的参数变化规律。

last_id: 代表这个数据最后一张图片相对于整个页面图片的位置编号

page_size: 代表这个数据总共有多少个图片

知道了这些,就可以进行爬取了,对于json数据,转换之后格式不方便查看,建议大家导入pprint这个库,方便json数据的查看。我之前有一篇详细地分析过提取数据的每一步,有兴趣的小伙伴可以看一下哟。

三、完整代码

# -*- coding: UTF-8 -*-

"""

@Author :远方的星

@Time : 2021/3/8 19:25

@CSDN :https://blog.csdn.net/qq_44921056

@腾讯云 : https://cloud.tencent.com/developer/column/91164

"""

import requests

import os

import json

# 创建一个文件夹

path = 'D:/原神同人画'

if not os.path.exists(path):

os.mkdir(path)

# 构造一个请求头

header = {

'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 11_1_0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'

}

# 用户输入想要爬取的页数

page = input('请输入您想要爬取的页数:')

page = int(page) + 1

n = 0

# image_id 代表图片从第几张开始爬取,默认一次滑动,加载出来20张

image_id = 0

for m in range(1, page):

url = 'https://bbs-api.mihoyo.com/post/wapi/forumGoodPostFullList?'

param = {

'forum_id': '29',

'gids': '2',

'last_id': image_id,

'page_size': '20'

}

# 定义一个空列表,用于存放图片的URL

image_url = list()

# 将编码形式转换为utf-8

response = requests.get(url=url, headers=header, params=param)

response.encoding = 'utf-8'

response = response.text

# 把字符串转换成json数据

data_s = json.loads(response, strict=False)

a = data_s["data"]["posts"] # 提取data里的数据

for i in range(len(a)):

data = a[i].get("post").get("cover")

image_url.append(data)

for image_src in image_url:

# 提取图片内容

image_data = requests.get(url=image_src, headers=header).content

# 图片名

image_name = '{}'.format(n+1) + '.jpg'

# 图片保存路径

image_path = path + '/' + image_name

# 保存数据

with open(image_path, 'wb') as f:

f.write(image_data)

print(image_name, '==================>下载完毕!!!')

f.close()

n += 1

image_id += 20

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

四、结果展示

希望大家可以,点赞、关注、收藏,三连支持一下!

作者:远方的星

CSDN:https://blog.csdn.net/qq_44921056

腾讯云:https://cloud.tencent.com/developer/column/91164

本文仅用于交流学习,未经作者允许,禁止转载,更勿做其他用途,违者必究。

文章来源: luckystar.blog.csdn.net,作者:爱打瞌睡的CV君,版权归原作者所有,如需转载,请联系作者。

原文链接:luckystar.blog.csdn.net/article/details/114577739

- 点赞

- 收藏

- 关注作者

评论(0)