yolov5 pt 模型 导出 onnx

【摘要】

在训练好的yolov5 pt 模型 可以 通过 export.py 进行导出 onnx

导出流程

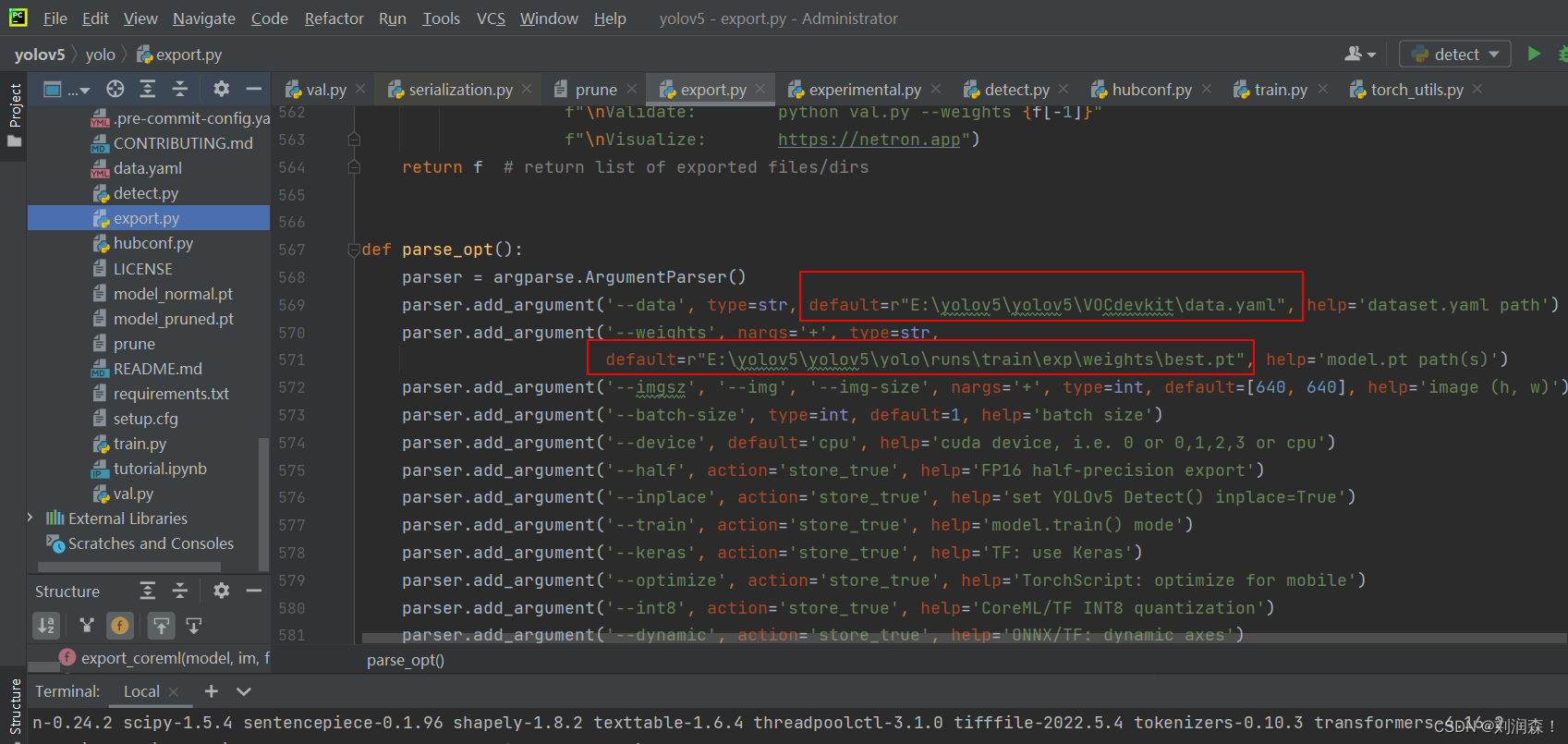

在 export.py 设置模型和数据源的yaml

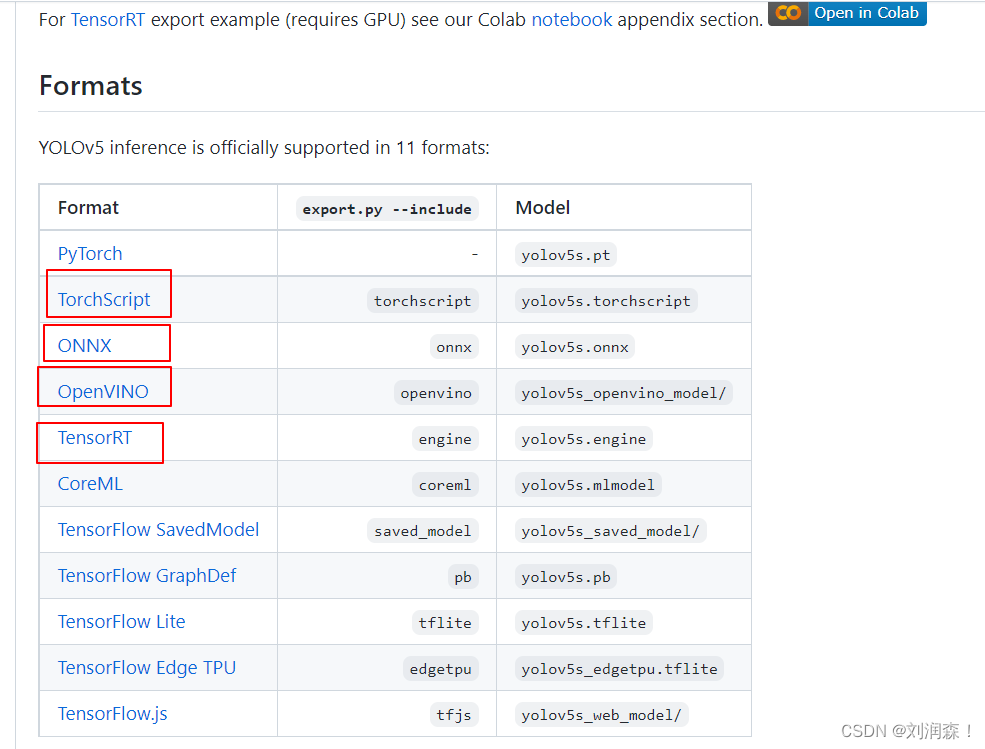

在官方的文档中 说明了可以导出的具体的类型。...

在训练好的yolov5 pt 模型 可以 通过 export.py 进行导出 onnx

导出流程

在 export.py 设置模型和数据源的yaml

在官方的文档中 说明了可以导出的具体的类型。

在 --include 添加导出的类型, 不同的 类型的 环境要求不一样,建议虚拟环境,比如onnx 和 openvino 的numpy 版本要求不一只,一个要求高配,一个要求低配

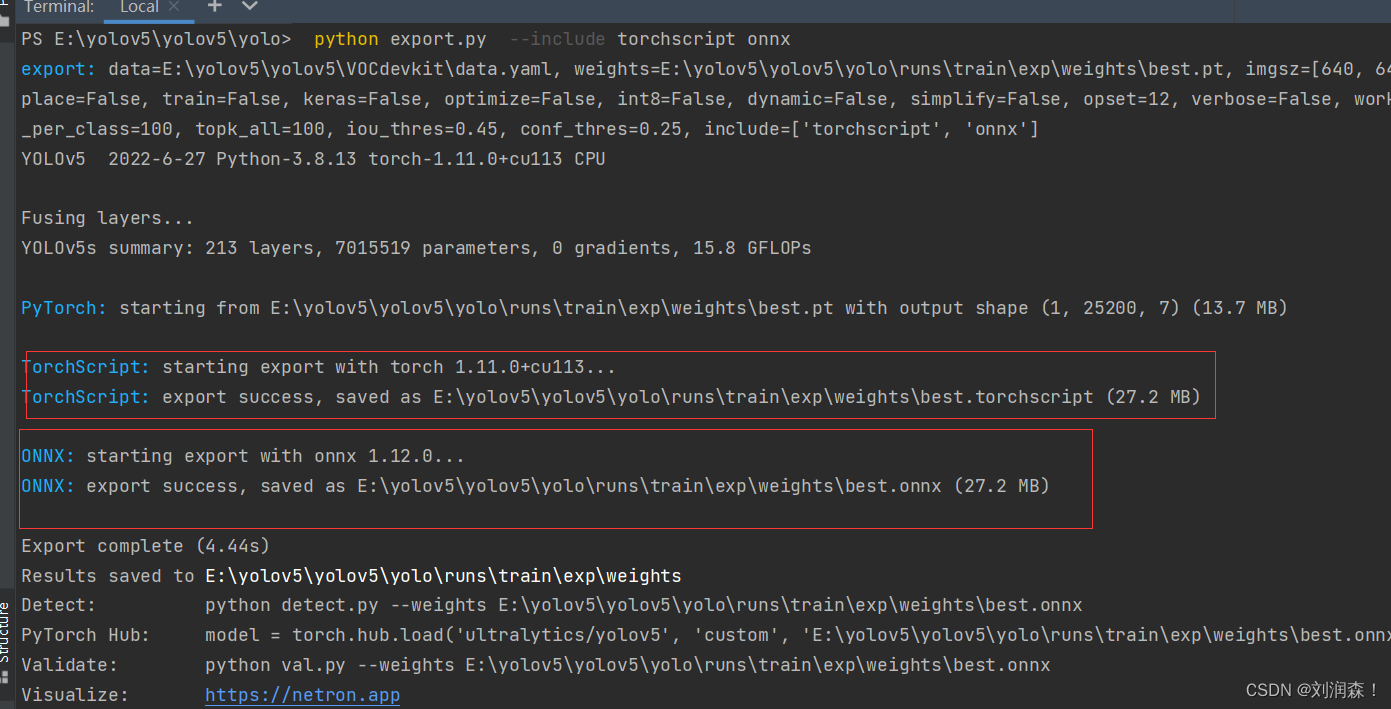

python export.py --include torchscript onnx

- 1

如何测试和验证推理

python detect.py --weights yolov5s.onnx --dnn # detect

python val.py --weights yolov5s.onnx --dnn # validate

- 1

- 2

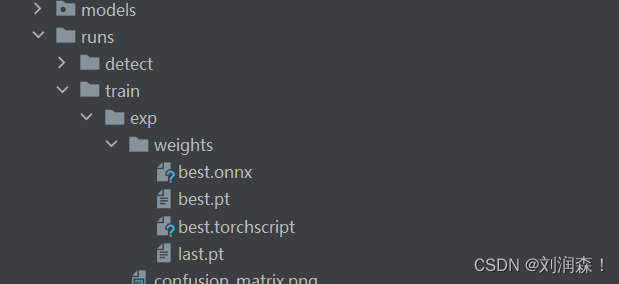

在模型导出的中

onnx 和 openvino 不需要GPU进行推理,但是tensorRT 需要 GPU 进行推理

文章来源: maoli.blog.csdn.net,作者:刘润森!,版权归原作者所有,如需转载,请联系作者。

原文链接:maoli.blog.csdn.net/article/details/125597564

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)