【LSSVM回归预测】基于matlab鲸鱼算法优化LSSVM回归预测【含Matlab源码 104期】

一、鲸鱼算法及LSSVM简介

1 鲸鱼优化算法(Whale Optimization Algorithm,WOA)简介

鲸鱼优化算法(WOA),该算法模拟了座头鲸的社会行为,并引入了气泡网狩猎策略。

1.1 灵感

鲸鱼被认为是世界上最大的哺乳动物。一头成年鲸可以长达 30 米,重 180 吨。这种巨型哺乳动物有 7 种不同的主要物种,如虎鲸,小须鲸,鳁鲸,座头鲸,露脊鲸,长须鲸和蓝鲸等。鲸通常被认为是食肉动物,它们从不睡觉,因为它们必须到海洋表面进行呼吸,但事实上,鲸鱼有一半的大脑都处于睡眠状态。

鲸鱼在大脑的某些区域有与人类相似的细胞,这些细胞被称为纺锤形细胞(spindle cells)。这些细胞负责人类的判断、情感和社会行为。换句话说,纺锤形细胞使我们人类有别于其他生物。鲸鱼的这些细胞数量是成年人的两倍,这是它们具有高度智慧和更富情感的主要原因。已经证明,鲸鱼可以像人类一样思考、学习、判断、交流,甚至变得情绪化,但显然,这都只是在一个很低的智能水平上。据观察,鲸鱼(主要是虎鲸)也能发展自己的方言。

另一个有趣的点是关于鲸鱼的社会行为,它们可独居也可群居,但我们观察到的大多数仍然是群居。它们中的一些物种(例如虎鲸)可以在整个生命周期中生活在一个家族中。最大的须鲸之一是座头鲸,一头成年座头鲸几乎和一辆校车一样大。它们最喜欢的猎物是磷虾和小鱼群。图1显示的就是这种哺乳动物。

图1 座头鲸的气泡网进食行为

关于座头鲸最有趣的事情是它们特殊的捕猎方法了。这种觅食行为被称为气泡网觅食法(bubble-net feeding method)。座头鲸喜欢在接近海面的地方捕食磷虾或小鱼。据观察,这种觅食是通过在圆形或类似数字“9”形路径上制造独特的气泡来完成的,如图 1 所示。在 2011 年之前,这一行为仅仅是基于海面观测的。然而,有研究者利用标签传感器研究了这种行为。他们捕获了9头座头鲸身上300个由标签得到的气泡网进食事件。他们发现了两种与气泡有关的策略,并将它们命名为上升螺旋(upward-spirals)和双螺旋(doubleloops)。在前一种策略中,座头鲸会潜到水下 12 米左右,然后开始在猎物周围制造一个螺旋形的泡泡,并游向水面;后一种策略包括三个不同的阶段:珊瑚循环,用尾叶拍打水面以及捕获循环。这里不展开详细描述。

但是气泡网捕食是只有座头鲸独有的一种特殊行为,而鲸鱼优化算法就是模拟了螺旋气泡网进食策略达到优化的目的。

1.2 数学建模和优化算法

1.2.1 包围捕食(Encircling prey)

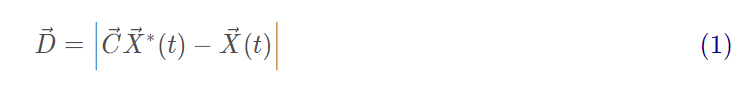

座头鲸可以识别猎物的位置并将其包围。由于最优设计在搜索空间中的位置不是先验已知的,WOA 算法假设当前的最佳候选解是目标猎物或接近最优解。在定义了最佳搜索代理之后,其他搜索代理将因此尝试向最佳搜索代理更新它们的位置。这种行为由下列方程表示:

图 2a 描述了等式(2)针对2D问题的基本原理,搜索代理的位置( X , Y )可以根据当前最优解的位置( X ∗ , Y ∗ )进行更新,通过调整向量 A ⃗ 和C的值,可以找到相对于当前位置下一时刻最优代理附近的不同地方。在 3D 空间中搜索代理可能的更新位置如图 2b。通过定义随机向量 r ,可以到达图 2 中所示关键点之间的搜索空间内任何位置,因此等式(2)允许任何搜索代理在当前最优解的邻域内更新其位置,从而模拟了鲸鱼的包围捕食。相似的概念也可以扩展到 n 维搜索空间。注意图2中的两幅图均是在a=1和C=1情况下的。

图2 2D和3D位置向量及其可能的下一个位置

1.2.2 气泡网攻击方式(Bubble-net attacking method)(利用阶段)

共设计了两种方法来对座头鲸的气泡网行为进行建模:

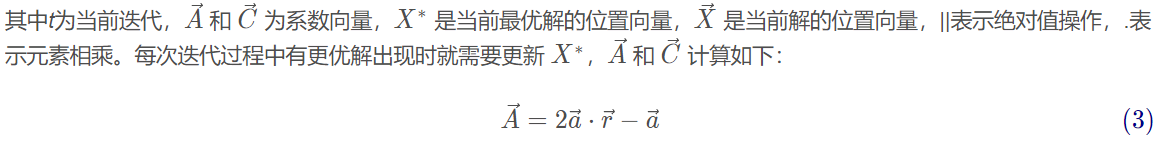

收缩包围机制:通过降低式(3)中 a 的值实现。注意 A的波动范围也通过 a降低,换句话说,A 是一个区间[-a,a]内的随机值,a 随着迭代进行从 2 降为 0。设置 A中的随机值在[-1,1]之间,搜索代理的新位置可以定义为代理原始位置与当前最优代理位置之间的任意位置。图 3a 显示了 2D 空间中当 0 ≤ A ≤ 1 0 时从 ( X , Y )靠近 ( X ∗ , Y ∗ ) 所有可能的位置。这种机制本质上就是包围捕食。

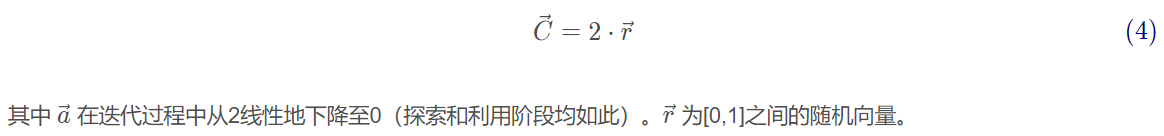

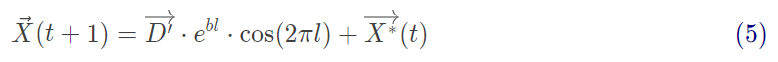

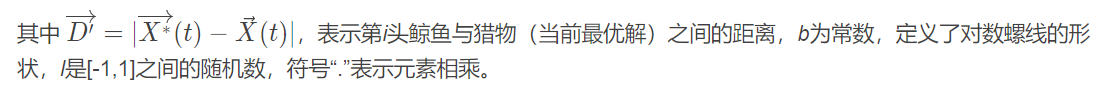

螺旋更新位置。如图 3b,该方法首先计算鲸鱼位置 ( X , Y ) 与猎物位置 ( X ∗ , Y ∗ ) 之间的距离,然后在鲸鱼与猎物位置之间创建一个螺旋等式,来模仿座头鲸的螺旋状移动:

(a)收缩包围机制

(b)螺旋更新位置

图3 WOA中实现的气泡网搜索机制

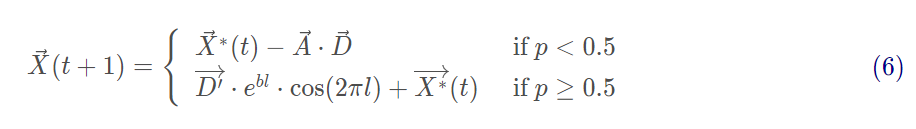

值得注意的是,座头鲸在一个不断缩小的圆圈内绕着猎物游动,同时沿着螺旋形路径游动。为了对这种同时发生的行为进行建模,假设有 50%的可能性在收缩包围机制和螺旋模型之间进行选择,以便在优化过程中更新鲸鱼的位置,数学模型如下:

其中 p pp 为[0,1]之间的随机数。

1.2.3搜索猎物(Search for prey)(exploration phase)

除了泡泡网方法,座头鲸还会随机寻找猎物,同样基于可变 A向量,事实上,座头鲸会根据彼此的位置进行随机搜索,因此使用随机值大于1或小于-1的 A ⃗ 来迫使搜索代理远离参考鲸鱼。与利用阶段相反,这里将根据随机选择的搜索代理来更新搜索代理在探索阶段的位置,而不是根据目前为止最优的搜索代理。该机制和 ∣ A ⃗ ∣ > 1 强调了探索,并允许WOA算法执行全局搜索。数学模型如下:

其中 X → r a n d 为从当前种群中选择的随机位置向量(表示一头随机鲸鱼)。

特定解附近满足 A ⃗ > 1的一些可能解如图 4 所示。

图4 WOA中的探索机制(X*是一个随机选择的搜索代理)

WOA算法首先随机初始化一组解,在每次迭代中,搜索代理根据随机选择的搜索代理或到目前为止获得的最优解更新它们的位置。将 a aa 参数由 2 随迭代次数降为 0,从而由探索逐步到利用。当 ∣ A ⃗ ∣ > 1 时选择随机搜索代理,∣ A ⃗ ∣ < 1 时选择最优解更新搜索代理位置。根据 p pp 的值,WOA可以在螺旋运动和圆环运动之间进行切换。最后,通过满足终止准则来终止WOA算法。WOA算法的伪代码如图5所示。

图5 WOA算法伪代码

1.3 代码分析

只要明白了原理的基本流程,其实代码就没有说明困难了,咱们主要介绍一下如何实现上述分析的几个重要原理,所要优化的问题的是三十个数的平方和最小

(1)参数初始化。初始时主要设置代理数量和最大迭代次数即可,其他算法相关的参数因为和当前迭代次数相关,需要在迭代中设置。

SearchAgents_no=30; % 搜索代理数量

Max_iteration=500; % 最大迭代次数

``

**(2) 种群初始化**。随机初始化所有代理各个维度上的位置值,需要保证在取值范围内。

```c

Positions=rand(SearchAgents_no,dim).*(ub-lb)+lb;

- 1

- 2

- 3

- 4

- 5

- 6

- 7

(3)种群评估。评估种群中每个代理的目标值,如有某个代理由于当前最优解,则将其设为最优解。

for i=1:size(Positions,1)

% 计算每个代理的目标值

fitness=fobj(Positions(i,:));

% 更新最优解

if fitness<Leader_score % 如果是最大化问题,这里就是">"

Leader_score=fitness;

Leader_pos=Positions(i,:);

end

end

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

(4)设置和迭代次数相关的算法参数。

a=2-t*((2)/Max_iter); % 等式(3)中a随迭代次数从2线性下降至0

%a2从-1线性下降至-2,计算l时会用到

a2=-1+t*((-1)/Max_iter);

- 1

- 2

- 3

(5)对每个代理的每一维度进行位置更新。

% Update the Position of search agents

for i=1:size(Positions,1)

r1=rand(); % r1为[0,1]之间的随机数

r2=rand(); % r2为[0,1]之间的随机数

A=2*a*r1-a; % 等式(3)

C=2*r2; % 等式(4)

b=1; % 等式(5)中的常数b

l=(a2-1)*rand+1; % 等式(5)中的随机数l

p = rand(); % 等式(6)中的概率p

for j=1:size(Positions,2)

if p<0.5

if abs(A)>=1

rand_leader_index = floor(SearchAgents_no*rand()+1);

X_rand = Positions(rand_leader_index, :);

D_X_rand=abs(C*X_rand(j)-Positions(i,j)); % 等式(7)

Positions(i,j)=X_rand(j)-A*D_X_rand; % 等式(8)

elseif abs(A)<1

D_Leader=abs(C*Leader_pos(j)-Positions(i,j)); % 等式(1)

Positions(i,j)=Leader_pos(j)-A*D_Leader; % 等式(2)

end

elseif p>=0.5

distance2Leader=abs(Leader_pos(j)-Positions(i,j));

% 等式(5)

Positions(i,j)=distance2Leader*exp(b.*l).*cos(l.*2*pi)+Leader_pos(j);

end

end

end

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

2 LSSVM简介

2.1 最小二乘支持向量机LSSVM基本原理

最小二乘支持向量机是支持向量机的一种改进,它是将传统支持向量机中的不等式约束改为等式约束, 且将误差平方和(SumSquaresError)损失函数作为训练集的经验损失,这样就把解二次规划问题转化为求解线性方程组问题, 提高求解问题的速度和收敛精度。

常用的核函数种类:

2.2 LSSVM工具箱的使用方法

2.1 最小二乘支持向量机Matlab工具箱下载链接https://www.esat.kuleuven.be/sista/lssvmlab/(毫无疑问下载最新版本)

2.2 将LS-SVM文件添加到matlan使用路径中,便可直接使用。

具体使用步骤:

(1)导入训练数据:load 读取mat文件和ASCII文件;xlsread读取.xls文件;csvread读取.csv文件。

(2)数据预处理:效果是加快训练速度。

方法有:归一化处理(把每组数据都变为 - 1~ +1之间的数, 所涉及到的函数有premnmx, post mnmx, tramnmx)

标准化处理(把每组数据都化为均值为 0, 方差为 1的一组数据, 所涉及到的函数有 prestd,poatstd, trastd)

主成分分析 (进行正交处理, 减少输入数据的维数, 所涉及到的函数有 prepca, trapca)

(3)LS-SVM lab用于函数回归主要用到 3个函数, trainlssvm函数用来训练建立模型, simlssvm函数用于预估模型, plotlssvm函数是 LS-SVM lab工具箱的专用绘图函数。

(4) 参数说明:

A =csvread(′traindata. csv′);

Ptrain0=A(:, [ 1:13] );Ttrain0=A(:, [ 14:16);

[ Ptrain, meanptrain, stdptrain] = prestd(Ptrain0′);

[ Ttrain, meant , stdt] = prestd(T train0′);

Prestd()是数据归一化函数, 其中 meanptrain是未归一化数据之前的向量平均值 stdptrain是未归一化数据之前的向量标准差。

gam =10;sig2=0. 5;type=′function estimation′;

LS-SVM 要求调的参数就两个。 gam 和 sig2是最小二乘支持向量机的参数, 其中 gam 是正则化参数, 决定了适应误差的最小化和平滑程度, sig2是 RBF 函数的参数。 在工具箱中有一个函数 gridsearch可以在一定的范围内用来寻找最优的参数范围。 type有两种类型, 一种是 classfication, 用于分类, 一种是 function estimation, 用于函数回归。

[ alpha, b] =trainlssvm({Ptrain′, Ttrain′, type, gam, sig2,′RBF_kernel′, ′preprocess′});

alpha是支持向量, b是阈值. 。 preprocess是表明数据已经进行归一化, 也可以是′original ′, 表明数据没有进行归一化, 缺省时是′preprocess′。

plotlssvm ({P, T, type, gam, sig2, ′RBF _ kernel ′,′preprocess′}, {alpha, b})plotlssvm函数是 LS-SVM 工具箱特有的绘图函数, 和 plot函数原理相近。

simlssvm函数也是 LS-SVM 工具箱的重要函数, 其中的参数如上述所示, 原理类似于神经网络工具箱中的 sim 函数。

通过调用 trainlssvm函数和 si m lssvm 函数我们可以看到最小二乘支持向量机和神经网络的结构有很多共同之处。

与神经网络进行对比:

神经网络建立的模型要比 LS-SVM 好, 但是在预估上, LS-SVM 要优于神经网络,具有较好的泛化能力, 而且训练速度要比神经网络快。

二、部分源代码

%=====================================================================

%初始化

clc

close all

clear

format long

tic

%==============================================================

%%导入数据

data=xlsread('数值.xlsx','Sheet1','A2:E41');%训练

data1=xlsread('数值.xlsx','Sheet1','G2:J31');%测试

[row,col]=size(data);

train_x=data(:,1:col-1);

train_y=data(:,col);

test_x=data(:,1:col-1);

% test_y=data(:,col);

train_x=train_x';

train_y=train_y';

test_x=test_x';

% test_y=test_y';

%%数据归一化

[train_x,minx,maxx, train_yy,miny,maxy] =premnmx(train_x,train_y);

test_x=tramnmx(test_x,minx,maxx);

train_x=train_x';

train_yy=train_yy';

train_y=train_y';

test_x=test_x';

% test_y=test_y';

%% 参数初始化

eps = 10^(-6);

%%定义lssvm相关参数

type='f';

kernel = 'RBF_kernel';

proprecess='proprecess';

lb=[0.01 0.02];%参数c、g的变化的下限

ub=[1000 100];%参数c、g的变化的上限

dim=2;%维度,即一个优化参数

SearchAgents_no=20; % Number of search agents

Max_iter=50; % Maximum numbef of iterations

% initialize position vector and score for the leader

Leader_pos=zeros(1,dim);

Leader_score=inf; %change this to -inf for maximization problems

%Initialize the positions of search agents

% Positions=initialization(SearchAgents_no,dim,ub,lb);

Positions(:,1)=ceil(rand(SearchAgents_no,1).*(ub(1)-lb(1))+lb(1));

Positions(:,2)=ceil(rand(SearchAgents_no,1).*(ub(2)-lb(2))+lb(2));

Convergence_curve=zeros(1,Max_iter);

t=0;% Loop counter

% Main loop

woa1;

%% 结果分析

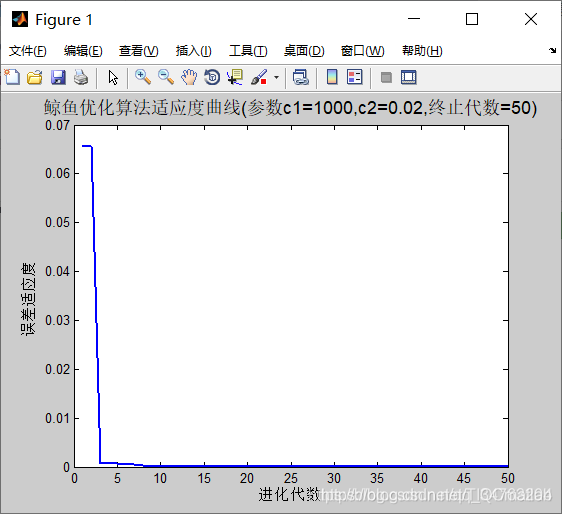

plot( Convergence_curve,'LineWidth',2);

title(['鲸鱼优化算法适应度曲线','(参数c1=',num2str(Leader_pos(1)),',c2=',num2str(Leader_pos(2)),',终止代数=',num2str(Max_iter),')'],'FontSize',13);

xlabel('进化代数');ylabel('误差适应度');

bestc = Leader_pos(1);

bestg = Leader_pos(2);

gam=bestc;

sig2=bestg;

model=initlssvm(train_x,train_yy,type,gam,sig2,kernel,proprecess);%原来是显示

model=trainlssvm(model);%原来是显示

%求出训练集和测试集的预测值

[train_predict_y,zt,model]=simlssvm(model,train_x);

[test_predict_y,zt,model]=simlssvm(model,test_x);

%预测数据反归一化

train_predict=postmnmx(train_predict_y,miny,maxy);%预测输出

test_predict=postmnmx(test_predict_y,miny,maxy);

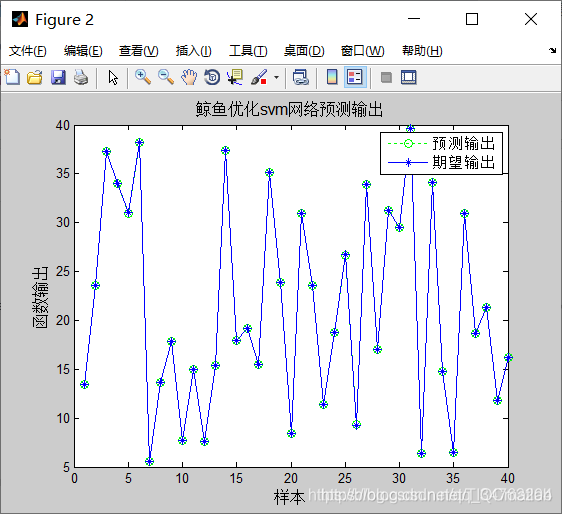

figure

plot(train_predict,':og')

hold on

plot(train_y,'- *')

legend('预测输出','期望输出')

title('鲸鱼优化svm网络预测输出','fontsize',12)

ylabel('函数输出','fontsize',12)

xlabel('样本','fontsize',12)

disp(['预测输出'])

YPred_best

toc %计算时间

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

三、运行结果

四、matlab版本及参考文献

1 matlab版本

2014a

2 参考文献

[1] 包子阳,余继周,杨杉.智能优化算法及其MATLAB实例(第2版)[M].电子工业出版社,2016.

[2]张岩,吴水根.MATLAB优化算法源代码[M].清华大学出版社,2017.

[3]周品.MATLAB 神经网络设计与应用[M].清华大学出版社,2013.

[4]陈明.MATLAB神经网络原理与实例精解[M].清华大学出版社,2013.

[5]方清城.MATLAB R2016a神经网络设计与应用28个案例分析[M].清华大学出版社,2018.

[6]群体智能优化算法之鲸鱼优化算法(Whale Optimization Algorithm,WOA)

文章来源: qq912100926.blog.csdn.net,作者:海神之光,版权归原作者所有,如需转载,请联系作者。

原文链接:qq912100926.blog.csdn.net/article/details/113028336

- 点赞

- 收藏

- 关注作者

评论(0)