【ELM分类】基于matlab遗传算法结合爬山算法优化ELM分类【含Matlab源码 1660期】

一、遗传算法优化支持向量机简介

1 支持向量机分类器

支持向量机算法的思想是,对给定的样本集,求一个超平面,将样本集按照的不同分开,同时要求该超平面能够将未见测试集正确地分成两类。

2 参数选取对分类器模型的影响

由于错误代价系数C与高斯核函数中的σ对样本的影响,进而会改变分类器的性质,所以C和σ是高斯径向基核SVM分类器中非常重要的参数。如何选择合理C和σ的值或它们的组合,对于支持向量机来说分类效果有着重要的作用。

优化SVM参数(C,σ)的算法主要有网格搜索法、双线性搜索法、拟牛顿法等。网格搜索法是把精度最高的一个参数组合作为支持向量机的最优参数,这是耗时相当长的过程且预测精确度十分低;双线性搜索法对线性最优参数的准确性依赖较大[16];拟牛顿法对实验者设定的初值要求很高,不适合广泛使用;此外,梯度下降算法虽然其可以有效地进行参数选择,但是这种方法求导困难、通用性差。

遗传算法在概率意义上对问题进行全局搜素求解,不会陷入局部最优解,在计算过程中的内在并行性,可以提高求解速度。所以本文使用遗传算法对错误代价系数C和高斯核函数的σ进行求解。通过编码将待求的C和σ模拟成一个种群,模仿自然界生物遗传的特性对这个种群进行选择、交叉以及变异操作,生成子代。并且在目标函数的指引下模仿自然环境对子代进行选择淘汰。如此反复生成子代,并对子代选择淘汰,C和σ的值在“优胜劣汰”中慢慢向着目标方向靠拢,最后可以找到最优解。

二、部分源代码

%% 清空环境变量 GA+elm

clc

clear

close all

format compact

%% 读取数据

traindata=xlsread('最终数据(1).xlsx','训练样本1','B3:E37');%3分类

testdata=xlsread('最终数据(1).xlsx','测试样本','B3:E11');

input_train=traindata(:,1:end-1)';

input_test=testdata(:,1:end-1)';

label_train=traindata(:,end)';

label_test=testdata(:,end)';

output_train=zeros(3,length(label_train));

output_test=zeros(3,length(label_test));

for i=1:length(label_train)

output_train(label_train(i),i)=1;

end

for i=1:length(label_test)

output_test(label_test(i),i)=1;

end

%归一化

[inputn_train,inputps]=mapminmax(input_train);

[inputn_test,inputtestps]=mapminmax('apply',input_test,inputps);

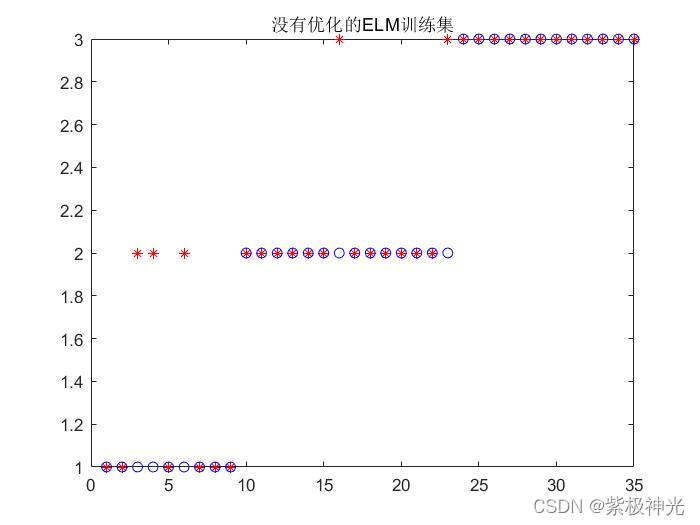

%% 没有优化的ELM

[IW,B,LW,TF,TYPE] = elmtrain(inputn_train,label_train,5,'sig',1);

title('没有优化的ELM训练集')

%% ELM仿真测试

Tn_sim = elmpredict(inputn_test,IW,B,LW,TF,TYPE);

test_accuracy=(sum(label_test==Tn_sim))/length(label_test)

figure

stem(label_test,'*')

hold on

plot(Tn_sim,'p')

title('没有优化的ELM测试集')

legend('期望输出','实际输出')

xlabel('样本数')

ylabel('类别标签')

%% 节点个数

inputnum=size(input_train,1);

hiddennum=5;

SG=5;

[bestchrom,trace]=gaforelm(SG,inputnum,hiddennum,inputn_train,label_train,inputn_test,label_test);%遗传算法

x=bestchrom;

% %% 优化后结果分析

% figure % 测试样本太少,加上使用爬山法之后,经常只需要一两次就能跳出循环 因此 适应度曲线经常都是一条直线,所以这个已经没什么意义来了

% [r c]=size(trace);

% plot(trace,'b--');

% title('适应度曲线图')

% xlabel('进化代数');ylabel('诊断正确率');

%% 把最优初始阀值权值赋予ELM重新训练与预测

if TYPE == 1

T1 = ind2vec(label_train);

end

w1=x(1:inputnum*hiddennum);

B1=x(inputnum*hiddennum+1:inputnum*hiddennum+hiddennum)';

%% train

W=reshape(w1,hiddennum,inputnum);

Q=size(inputn_train,2);

BiasMatrix = repmat(B1,1,Q);

tempH = W * inputn_train + BiasMatrix;

H = 1 ./ (1 + exp(-tempH));

LW = pinv(H') * T1';

TY=(H'*LW)';

temp_Y=zeros(1,size(TY,2));

for n=1:size(TY,2)

[max_Y,index]=max(TY(:,n));

temp_Y(n)=index;

end

Y_train=temp_Y;

train_accuracy=sum(Y_train==label_train)/length(label_train);

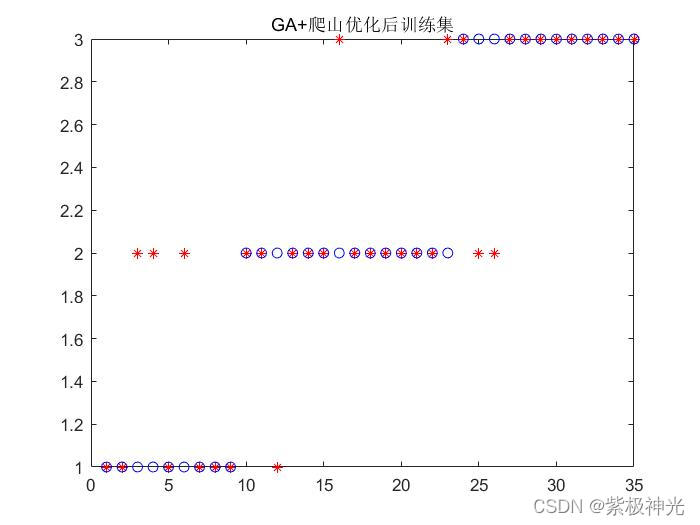

figure

plot(Y_train,'r*');hold on

plot(label_train,'bo');

title('GA+爬山优化后训练集')

%% test

T2=ind2vec(label_test);

Q=size(inputn_test,2);

BiasMatrix1 = repmat(B1,1,Q);

tempH1 = W * inputn_test + BiasMatrix1;

H1 = 1 ./ (1 + exp(-tempH1));

TY1=(H1'*LW)';

save IGA_ELM TY1

if TYPE == 1

temp_Y1=zeros(1,size(TY1,2));

for n=1:size(TY1,2)

[max_Y,index]=max(TY1(:,n));

temp_Y1(n)=index;

end

Y_train=temp_Y1;

end

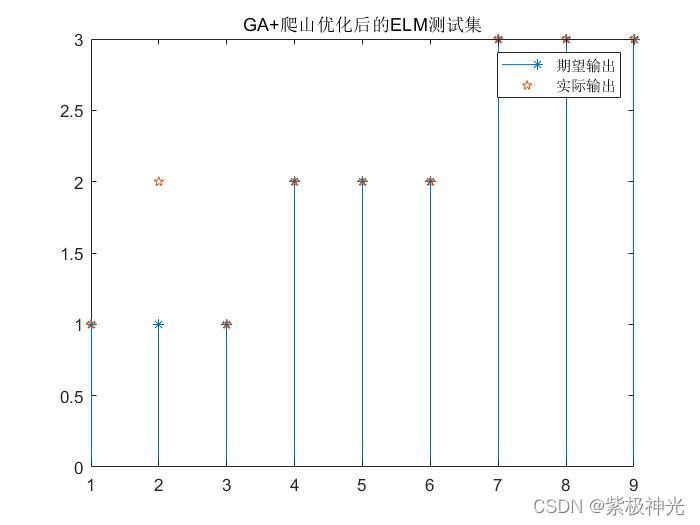

youhua_test_accuracy=sum(Y_train==label_test)/length(label_test)

figure

stem(label_test,'*')

hold on

plot(Y_train,'p')

title('GA+爬山优化后的ELM测试集')

legend('期望输出','实际输出')

%出售各类算法优化深度极限学习机代码392503054

load Y_elm

load IGA_elm

load label_test% 真实对应的标签

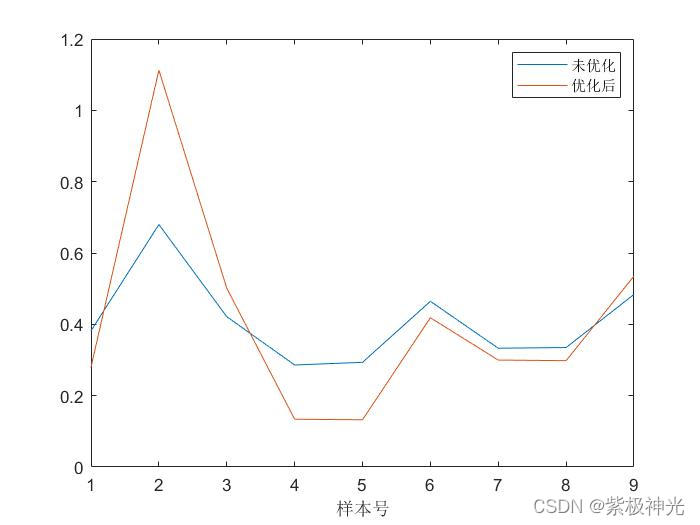

%% 画误差折线

% 未优化的误差

error1=[];

for i=1:9

error1=[error1 sum((Y(:,i)-output_test(:,i)).^2)];

end

% 优化后的误差

error2=[];

for i=1:9

error2=[error2 sum((TY1(:,i)-output_test(:,i)).^2)];

end

figure

plot(error1)

hold on

plot(error2)

legend('未优化','优化后')

xlabel('样本号')

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

- 115

- 116

- 117

- 118

- 119

- 120

- 121

- 122

三、运行结果

四、matlab版本及参考文献

1 matlab版本

2014a

2 参考文献

[1] 包子阳,余继周,杨杉.智能优化算法及其MATLAB实例(第2版)[M].电子工业出版社,2016.

[2]张岩,吴水根.MATLAB优化算法源代码[M].清华大学出版社,2017.

[3]周品.MATLAB 神经网络设计与应用[M].清华大学出版社,2013.

[4]陈明.MATLAB神经网络原理与实例精解[M].清华大学出版社,2013.

[5]方清城.MATLAB R2016a神经网络设计与应用28个案例分析[M].清华大学出版社,2018.

[6]张沫,郑慧峰,倪豪,王月兵,郭成成.基于遗传算法优化支持向量机的超声图像缺陷分类[J].计量学报. 2019,40(05)

文章来源: qq912100926.blog.csdn.net,作者:海神之光,版权归原作者所有,如需转载,请联系作者。

原文链接:qq912100926.blog.csdn.net/article/details/122352230

- 点赞

- 收藏

- 关注作者

评论(0)