网络爬虫的注意事项

中国大学mooc

网络爬虫

网络爬虫(又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

爬虫引发的问题

网络爬虫的尺寸:

- 小规模:数据量小,对爬取速度不敏感 (爬网页,玩,90%)

- 中规模:数据量较大,对爬取速度敏感 (爬网站,系列网站)

- 大规模:爬取搜索引擎,爬取速度很关键,定制。 (爬全网)

爬虫导致的问题:

-

网络爬虫可能对服务器造成“性能骚扰”

Web服务器默认接收人类访问

受限于编写水平和目的,网络爬虫将会为Web服务器带来巨大的资源开销 -

网络爬虫使用不当可能带来“法律风险”

服务器上的数据有产权归属

网络爬虫获取数据后牟利将带来法律风险 -

网络爬虫的“隐私泄露”

网络爬虫可能具备突破简单访问控制的能力,获得被保护数据

从而泄露个人隐私

总结:

- 性能骚扰

- 法律风险

- 隐私泄露

网络爬虫的限制

• 来源审查:判断User‐Agent进行限制(需要有一定的技术能力)

检查来访HTTP协议头的User‐Agent域,只响应浏览器或友好爬虫的访问

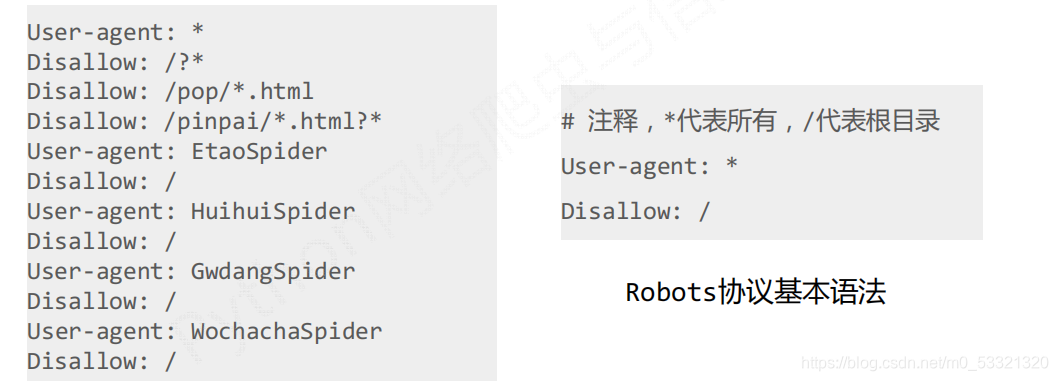

• 发布公告:Robots协议

告知所有爬虫网站的爬取策略,哪里可以爬,哪里不可以,要求爬虫遵守。

Robots协议

Robots Exclusion Standard,网络爬虫排除标准

- 1

作用:

网站告知网络爬虫哪些页面可以抓取,哪些不行

形式:

在网站根目录下的robots.txt文件

比如:京东的Robots协议

真实的Robots协议:

百度:http://www.baidu.com/robots.txt

新浪:http://news.sina.com.cn/robots.txt

QQ:http://www.qq.com/robots.txt

QQ新闻:http://news.qq.com/robots.txt

国家教育网:http://www.moe.edu.cn/robots.txt (无Robots协议)

实际操作中,该如何遵守Robots协议?

网络爬虫:

自动或人工识别robots.txt,再进行内容爬取

约束性:

Robots协议是建议但非约束性,网络爬虫可以不遵守,但存在法律风险

个人:

网络大舞台,有胆你就来。

爬虫写的好,牢饭吃到饱。

哈哈,开玩笑了,总之只要不对服务器很大的伤害,爬取网上的资料图自己用来学习,不用做商页,就没问题。个人见解

文章来源: blog.csdn.net,作者:周棋洛ყ ᥱ ᥉,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/m0_53321320/article/details/118423606

- 点赞

- 收藏

- 关注作者

评论(0)