Hadoop快速入门——第三章、MapReduce案例(字符统计)

Hadoop快速入门——第三章、MapReduce案例

目录

8、上传【jar】包以及【info.txt】文件至【/opt/soft/hadoop/share/hadoop/mapreduce】 下

环境要求:

1、分布式/伪分布式的hadoop环境【hadoop2.7.3】

2、win10本地Java环境【jdk8】

3、win10本地hadoop环境【2.7.3】

4、win10本地Maven环境【Maven3】

5、idea开发工具【IntelliJ IDEA 2020.1.3 x64】

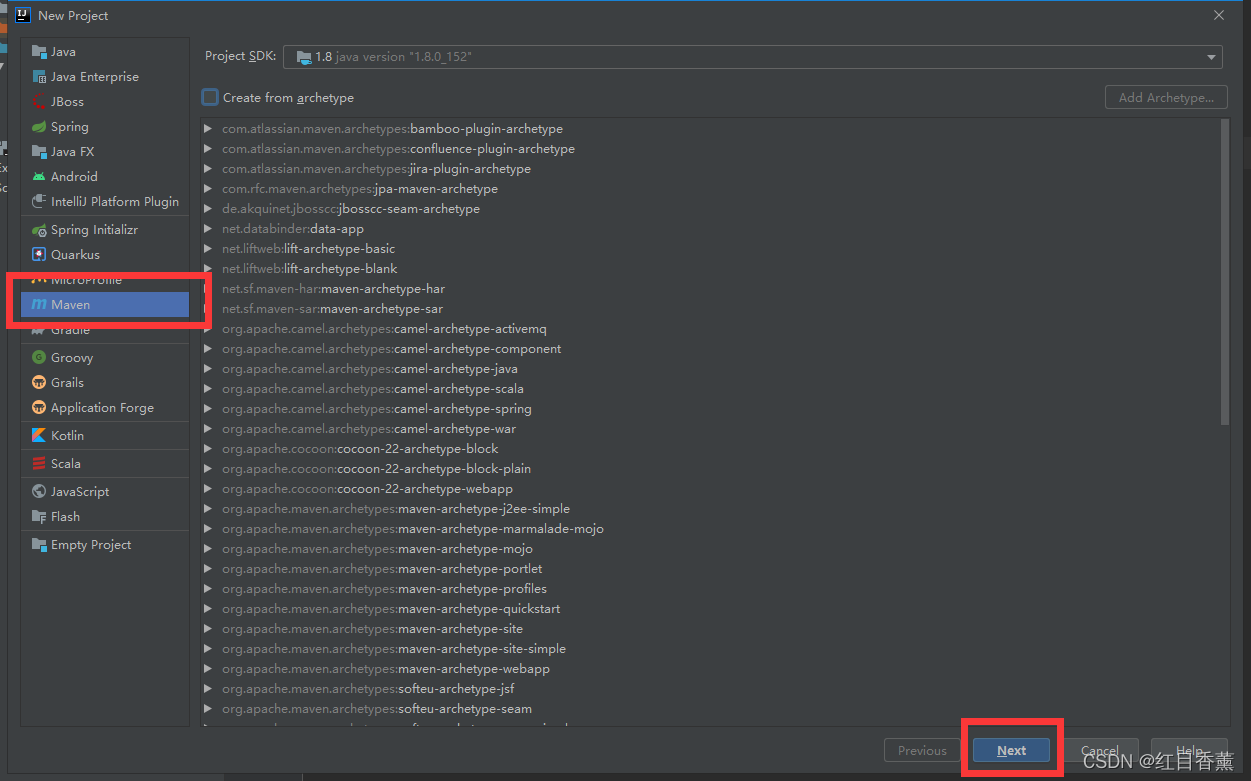

1、项目创建:

需要建立【maven】项目,建立过程中

项目名称无所谓:

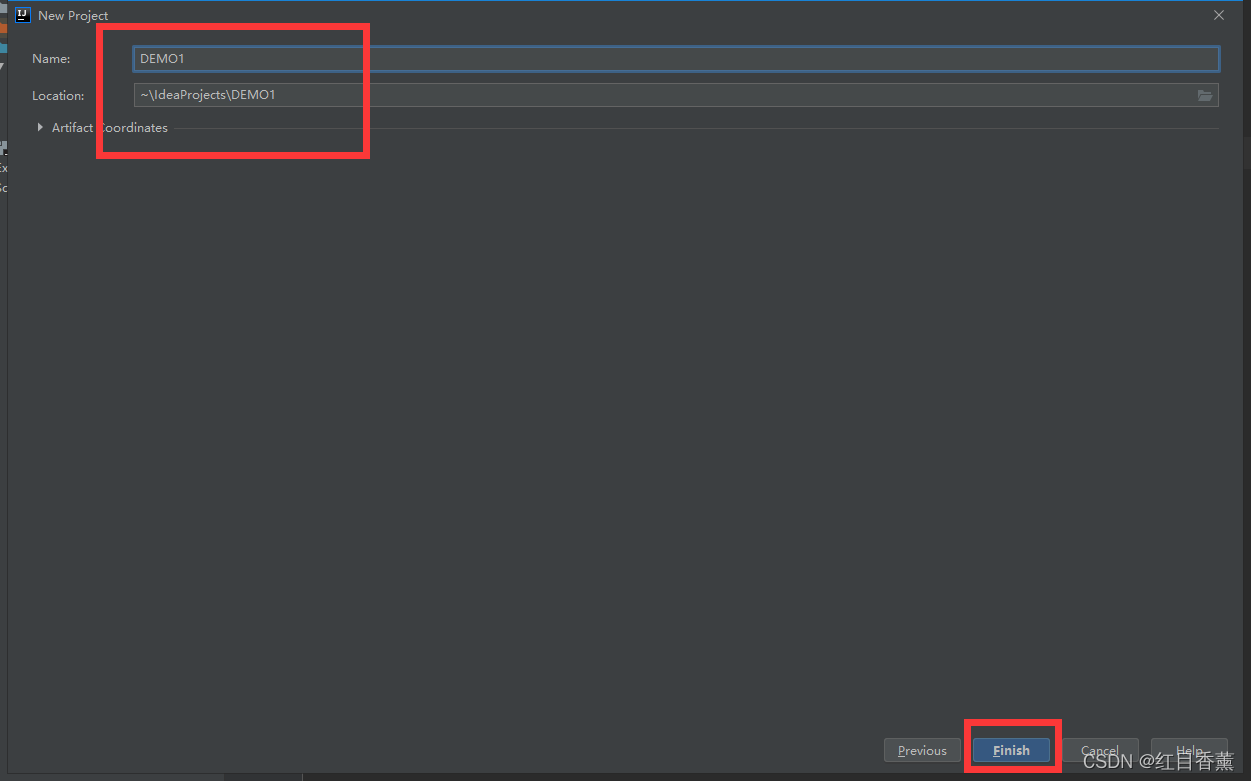

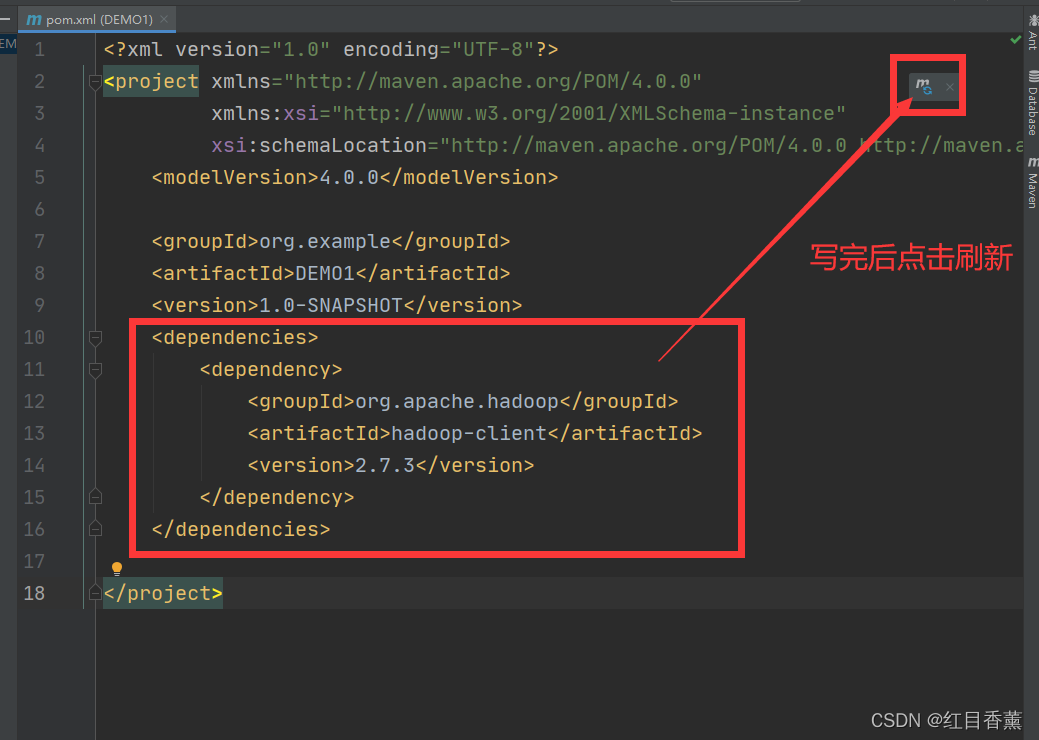

2、修改Maven

点击【file】->【Settings】后如下图操作,选择本地的Maven配置文件以及仓库地址。

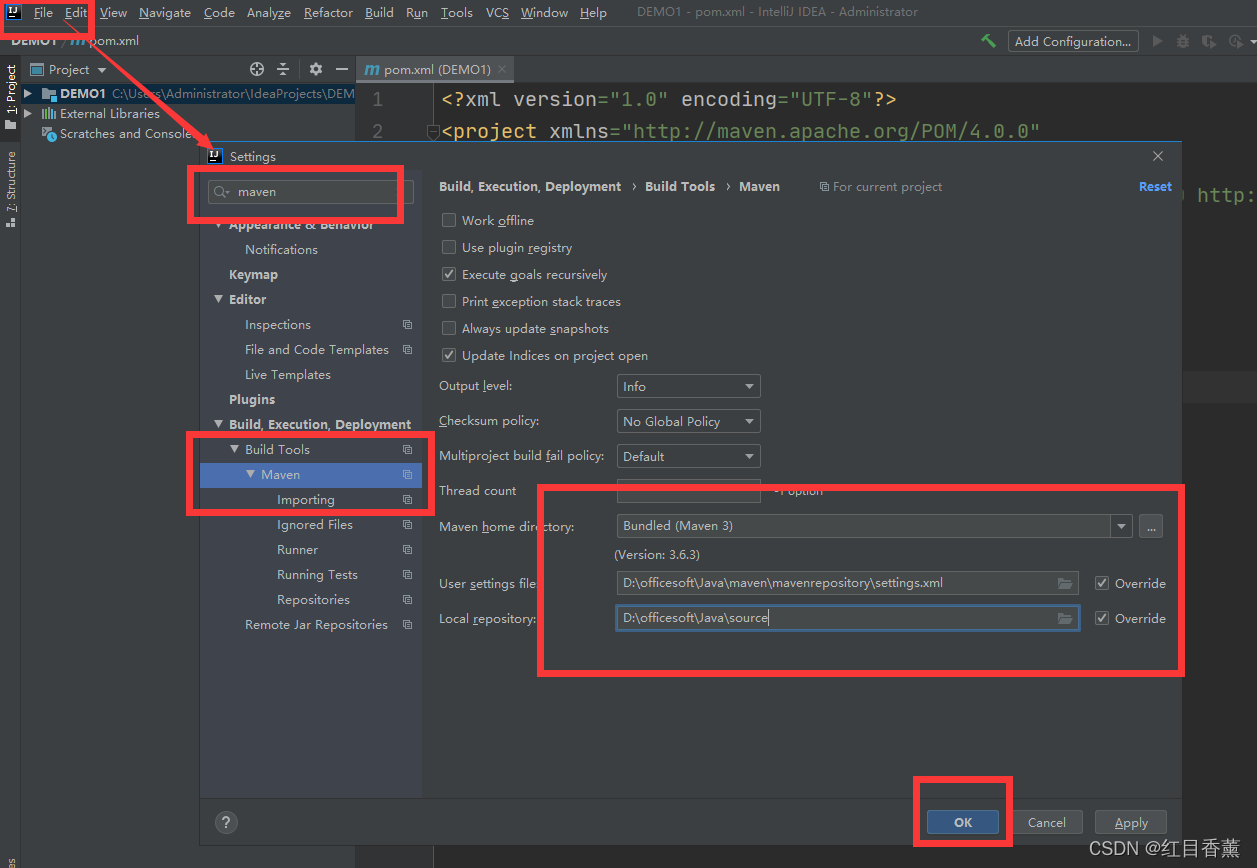

引入【hadoop-client】

3、编码

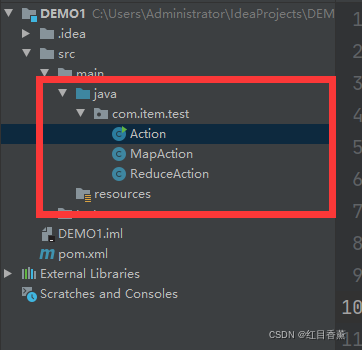

在【src的java】下创建【com.item.test】包,以及【MapAction】【ReduceAction】【Action】的类文件。

【MapAction】编码

【ReduceAction】编码

【Action】编码

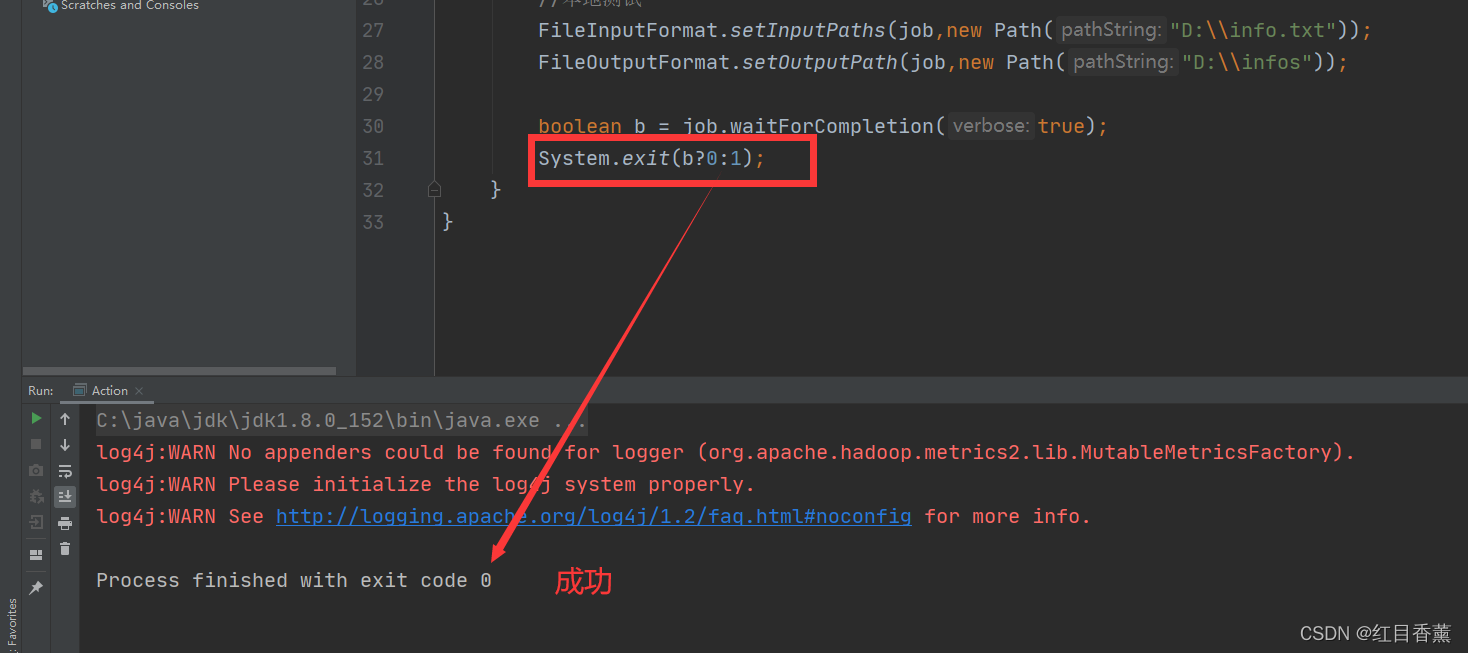

4、本地文件测试

本地测试文件【D:\\info.txt】:

测试成功:

5、修改【Action】文件(修改测试文件路径)

6、导出jar包

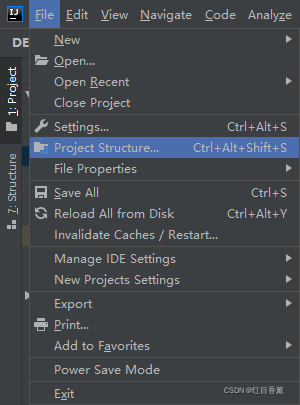

依次点击【file】【Project Structure】

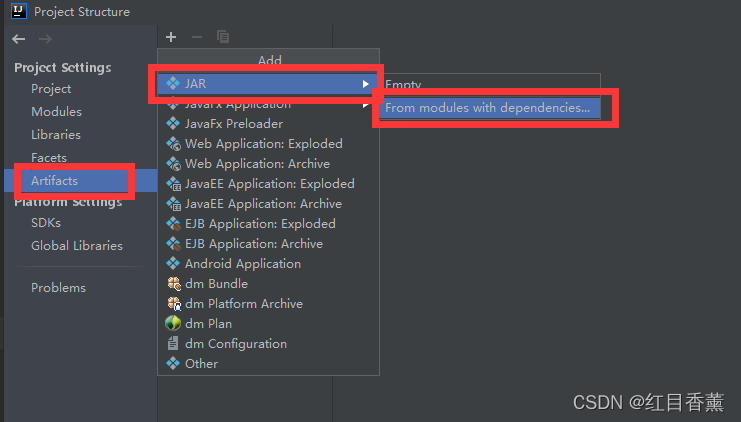

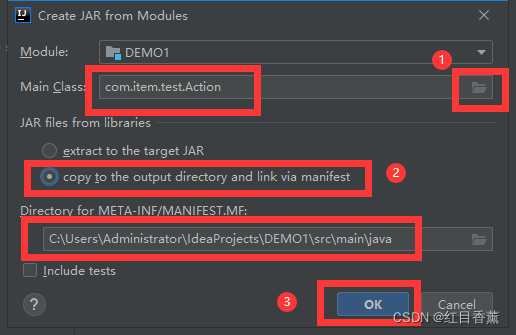

点击【Artfacts】【JAR】【From modules with dependencies...】

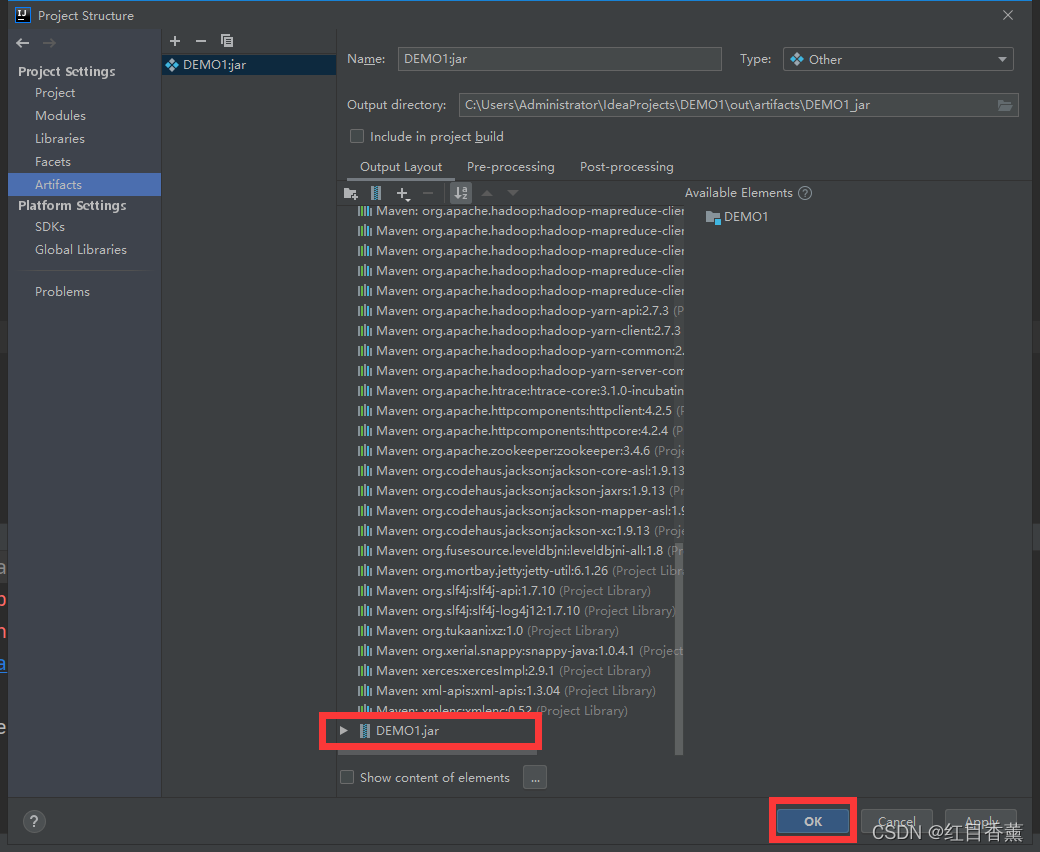

点击【OK】退出即可

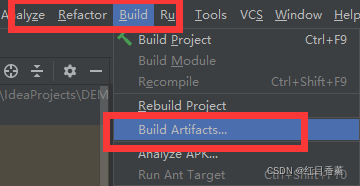

点击【Build】【Build Artfacts...】

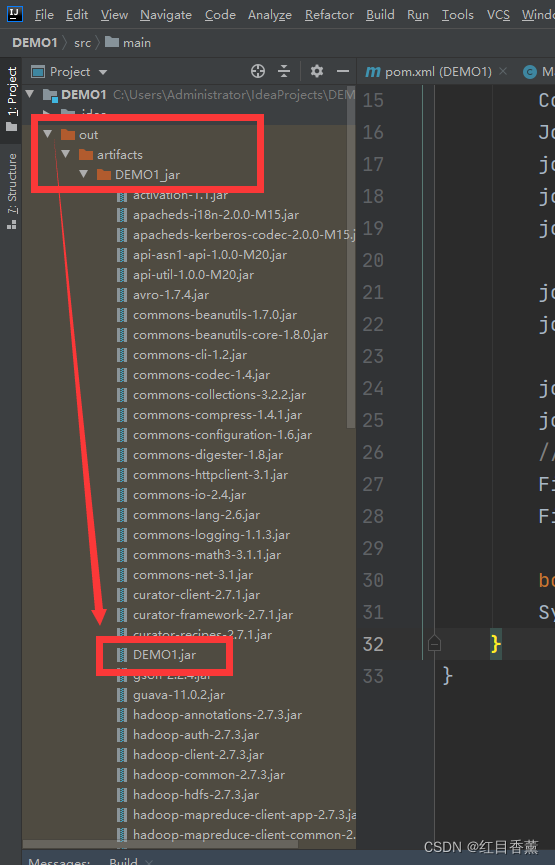

在项目层级中可以看到生成的【out】文件夹,打开后找到对应的【jar】包文件。

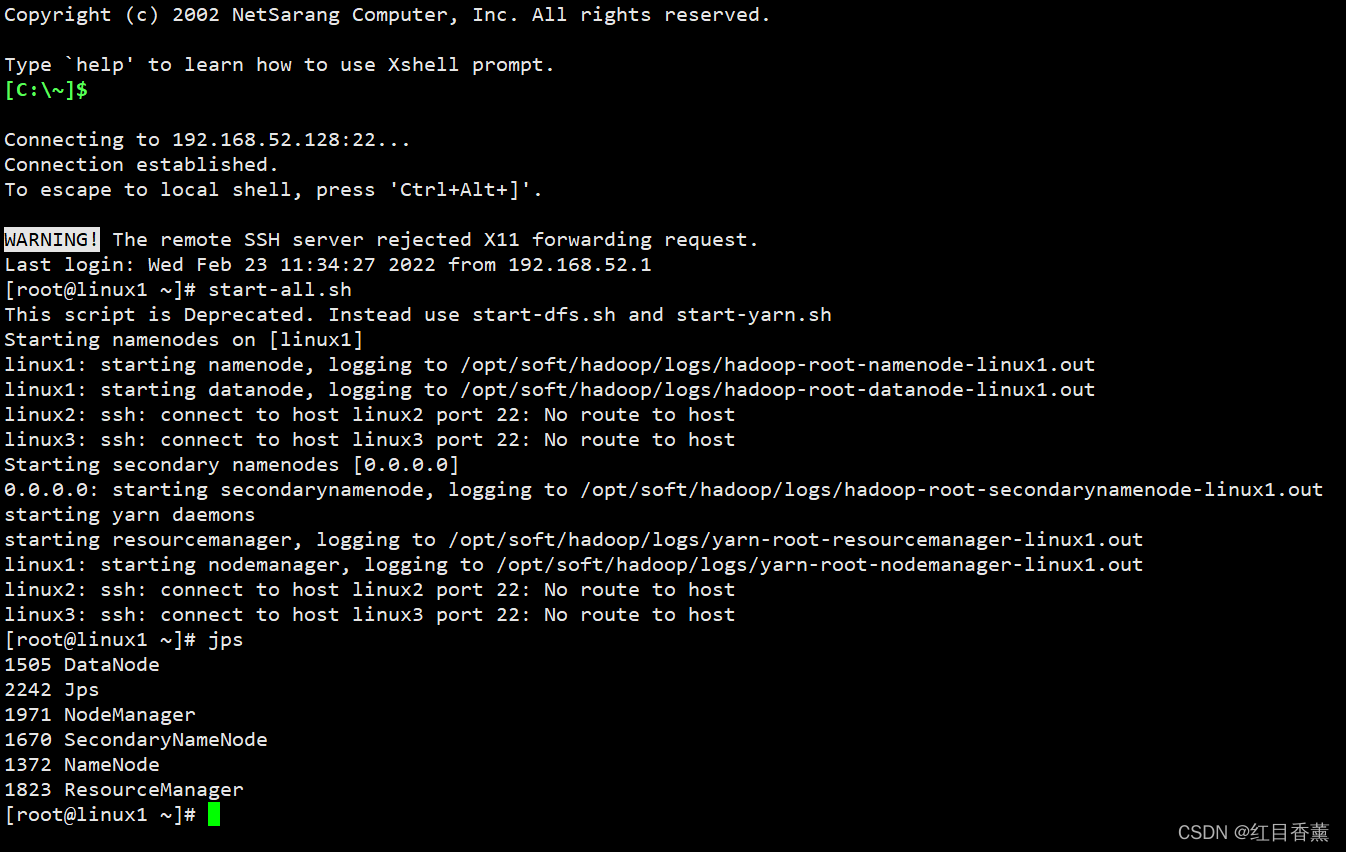

7、启动hadoop服务

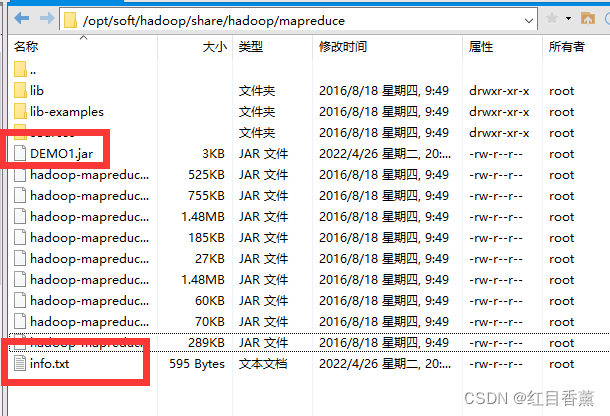

8、上传【jar】包以及【info.txt】文件至【/opt/soft/hadoop/share/hadoop/mapreduce】 下

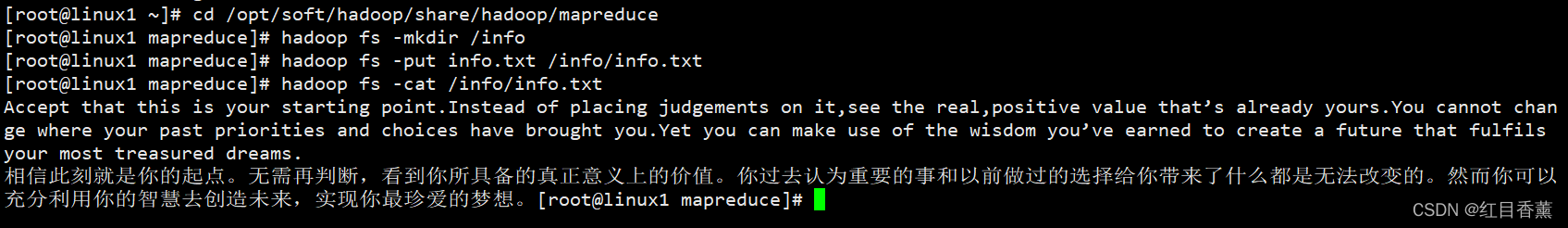

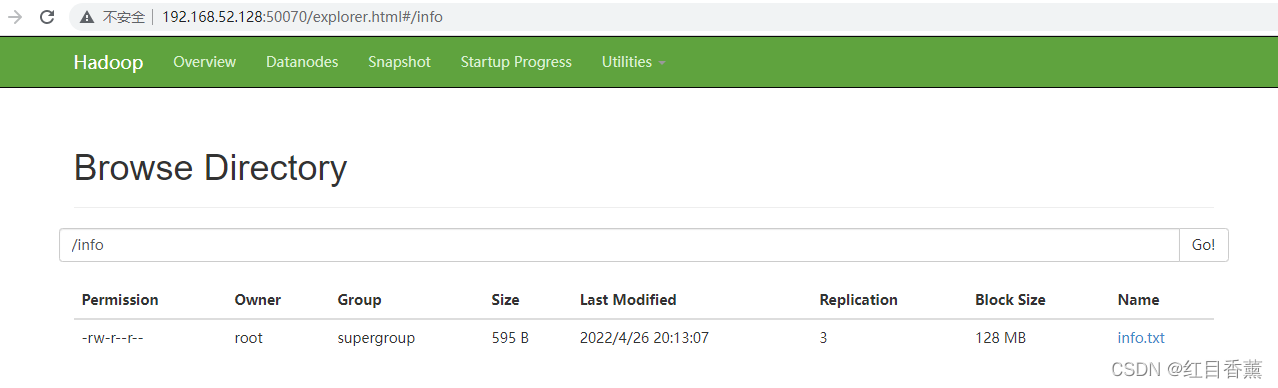

9、创建存储文件的文件夹

输入以下命令:

文件位置:

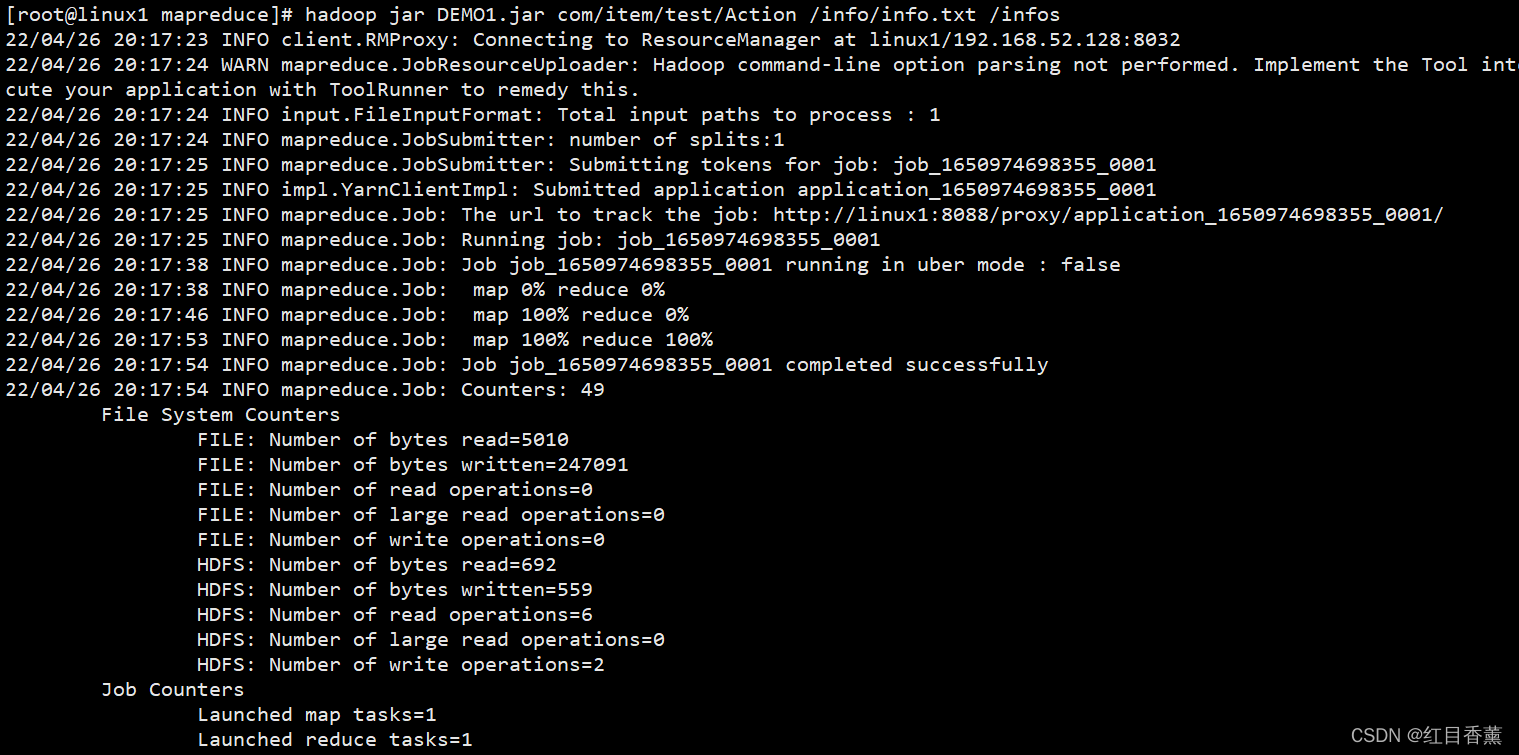

10、通过【jar】执行

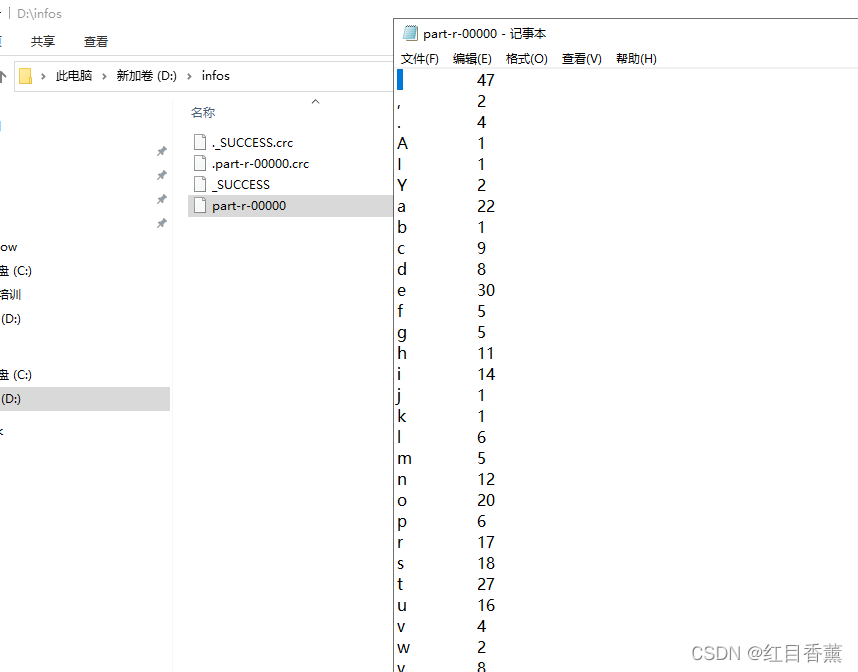

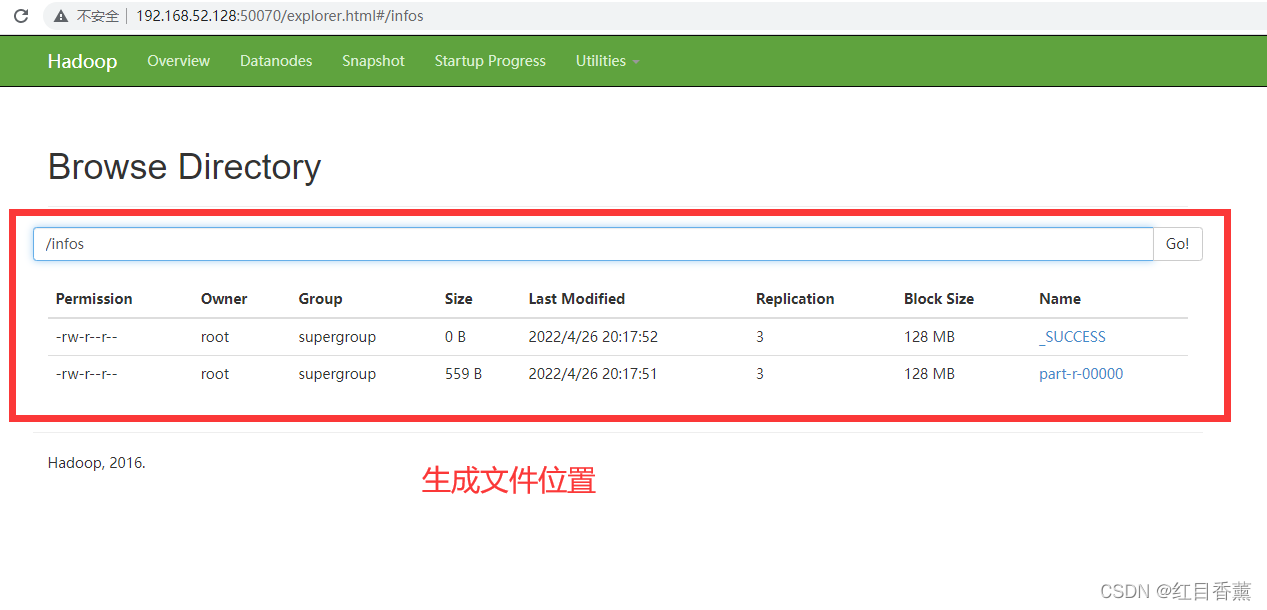

生成文件位置:

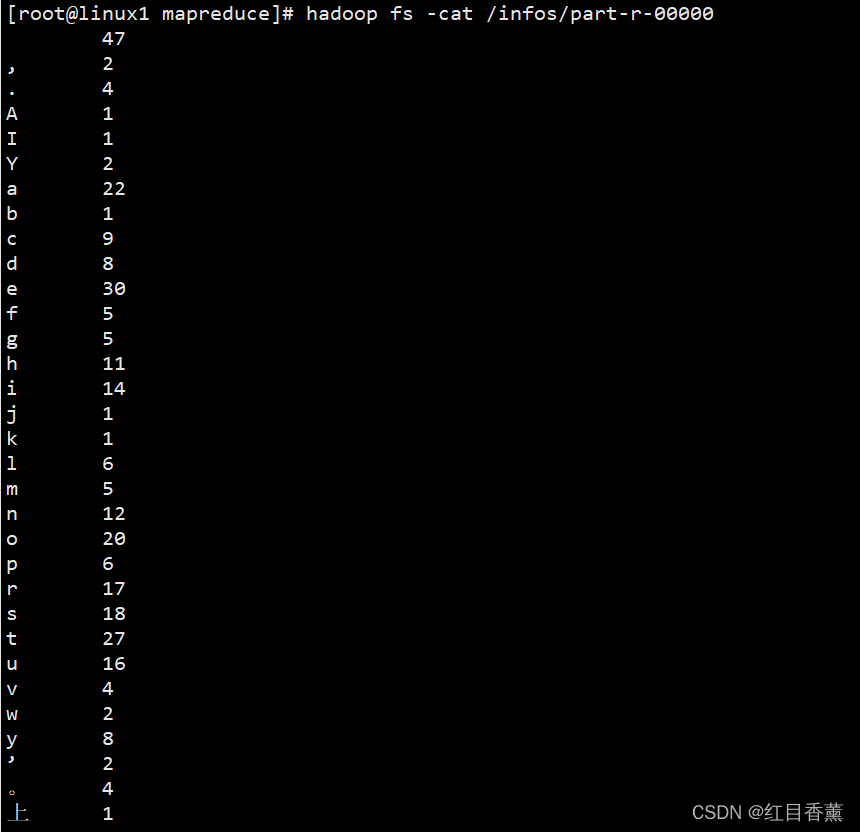

11、查看生成结果

12、总结

1、常用的【hdfs】命令一定要熟悉,用的很多。

2、在服务器中运行的时候不能使用【绝对地址D:\\类似的路径】

3、如果存在导出文件夹则会报错,故而生成的文件一定要放置在没有的文件夹内。

- 点赞

- 收藏

- 关注作者

评论(0)