ElasticSearch进阶篇之IK分词器和自定义词库实现

本文在前面文章的基础上我们继续来分享ElasticSearch中的内容,本文重点介绍IK分词器和自定义词库的实现。

本文在前面文章的基础上我们继续来分享ElasticSearch中的内容,本文重点介绍IK分词器和自定义词库的实现。

ElasticSearch分词器

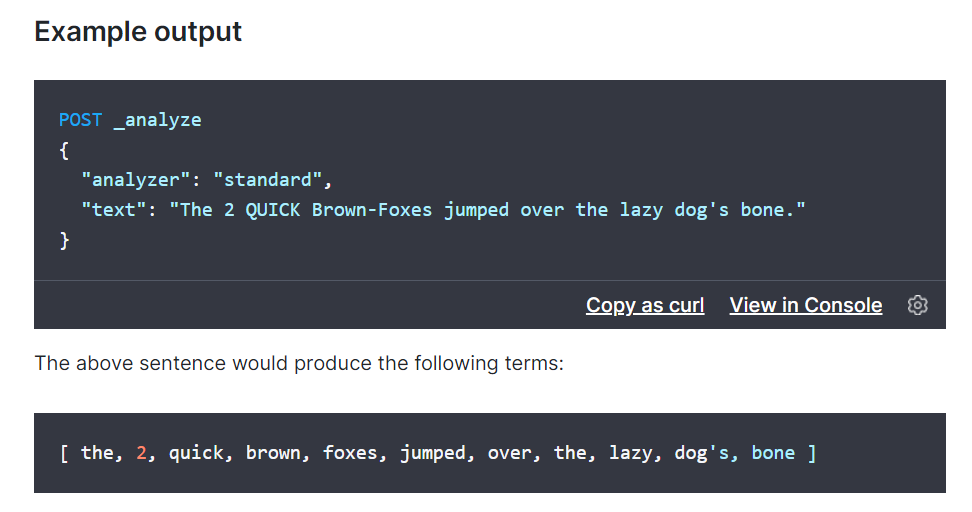

所谓的分词就是通过tokenizer(分词器)将一个字符串拆分为多个独立的tokens(词元-独立的单词),然后输出为tokens流的过程。

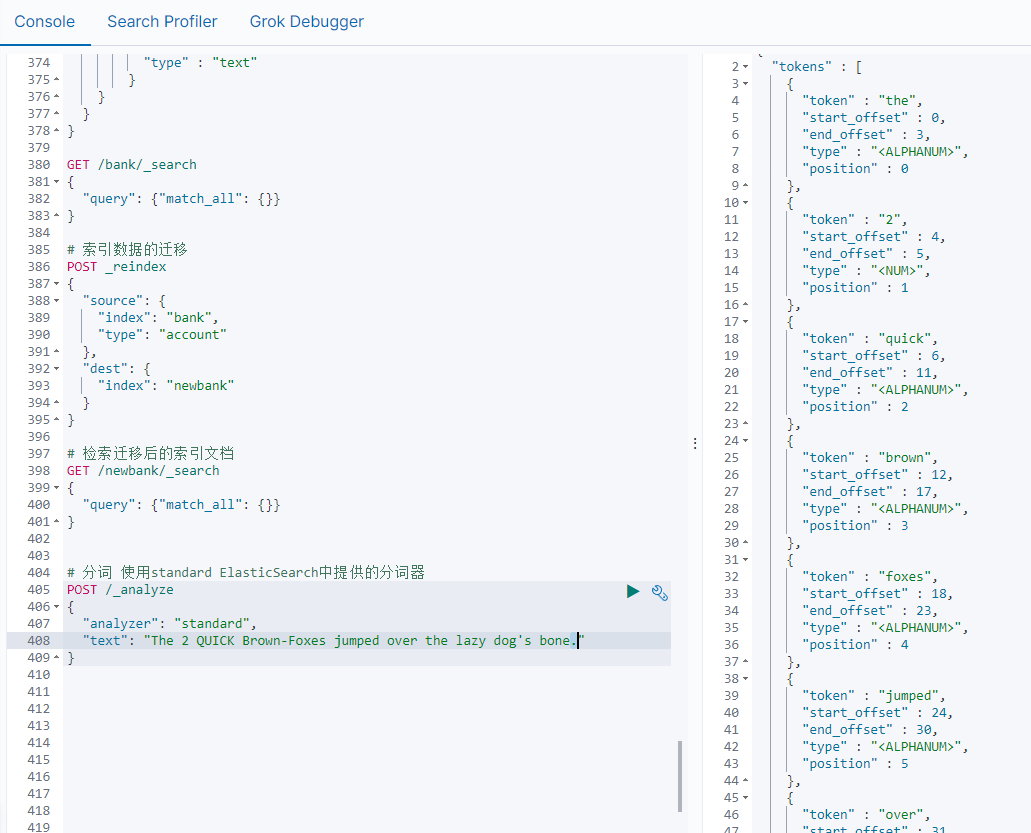

例如"my name is HanMeiMei"这样一个字符串就会被默认的分词器拆分为[my,name,is HanMeiMei].ElasticSearch中提供了很多默认的分词器,我们可以来演示看看效果

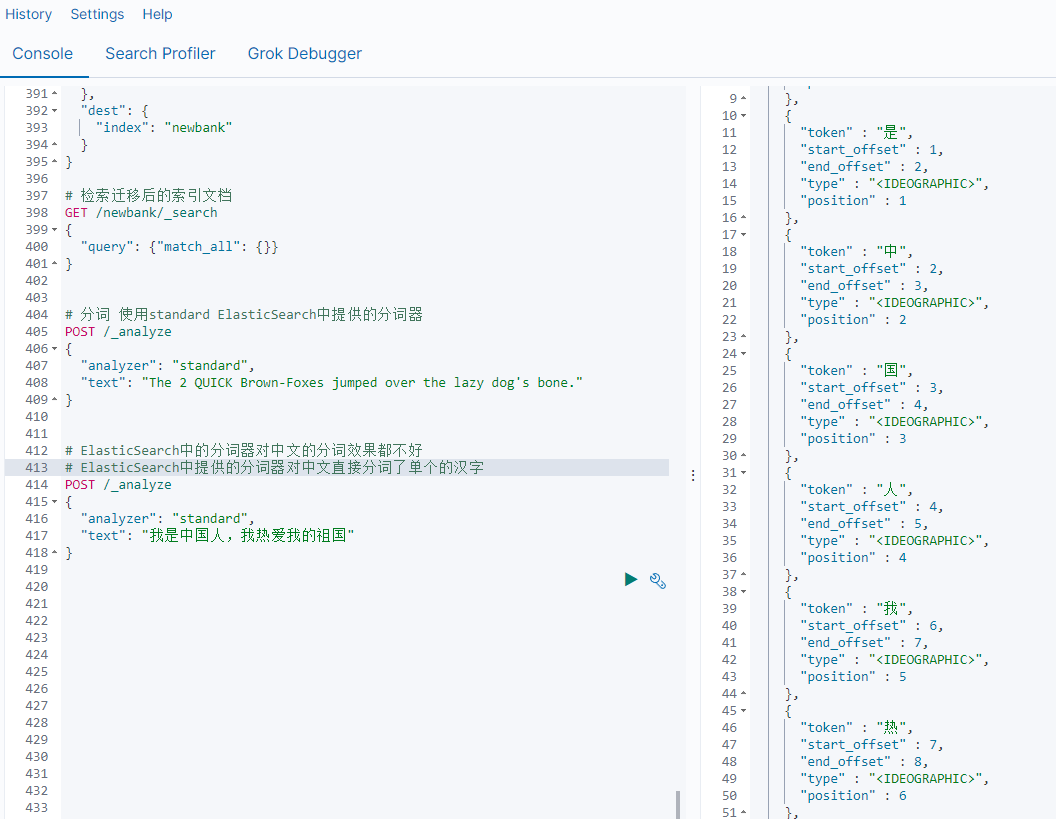

但是在ElasticSearch中提供的分词器对中文的分词效果都不好。

所以这时我们就需要安装特定的分词器 IK

1) 安装ik分词器

https://github.com/medcl/elasticsearch-analysis-ik 下载对应的版本,然后解压缩到plugins目录中

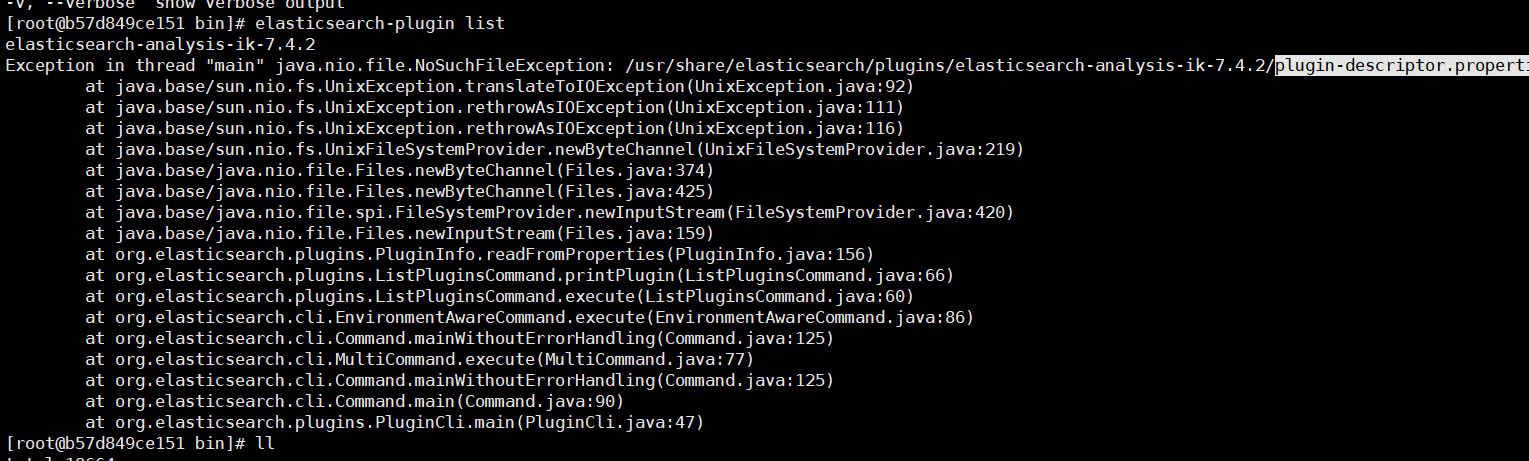

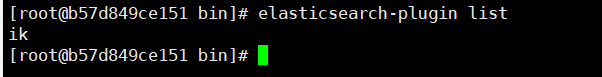

然后检查是否安装成功:进入容器 通过如下命令来检测

检查下载的文件是否完整,如果不完整就重新下载。

插件安装OK后我们重新启动ElasticSearch服务

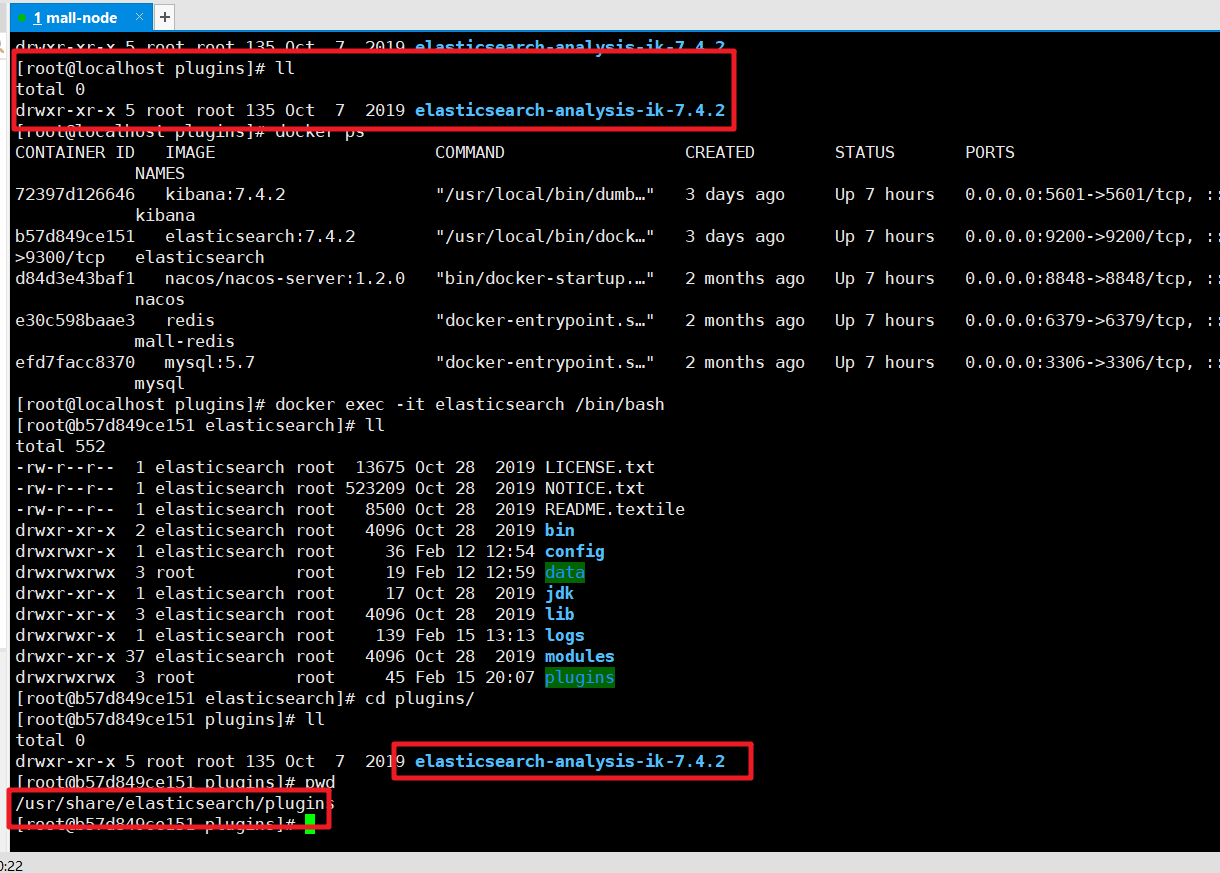

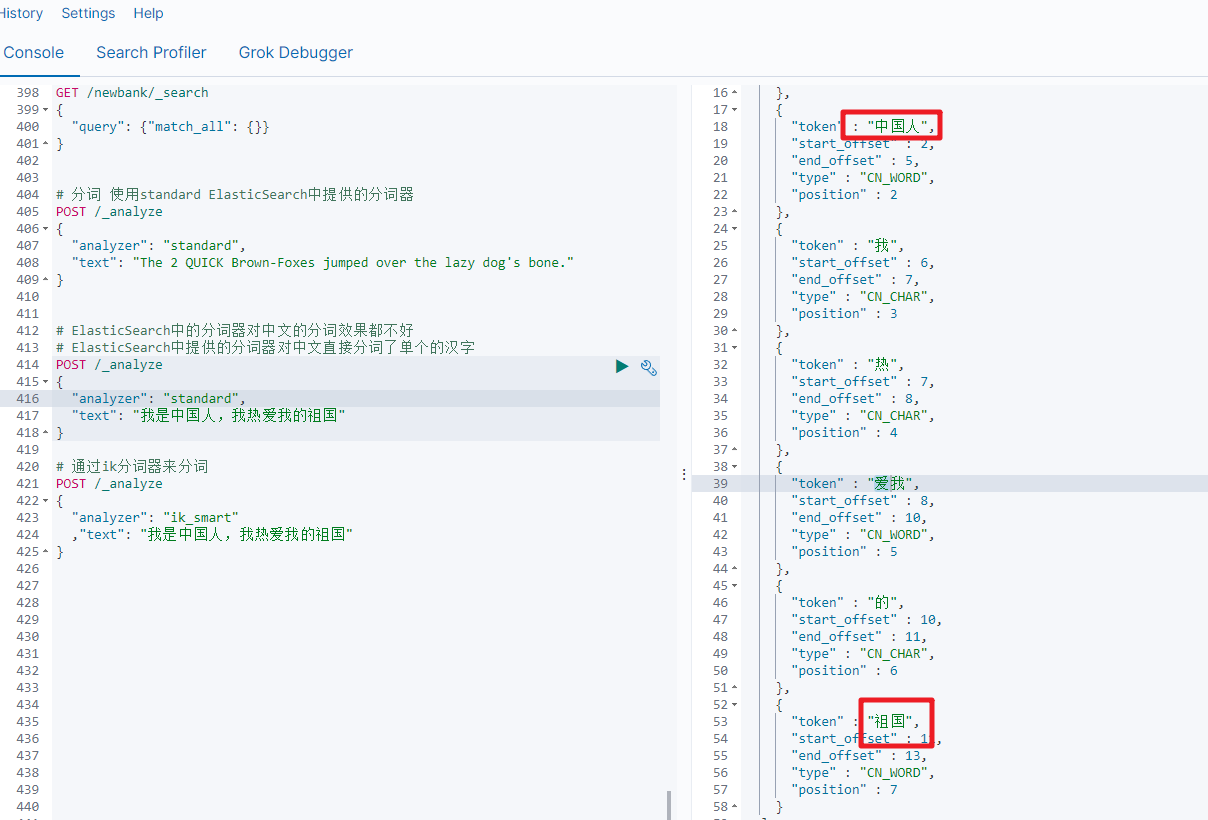

2) ik分词演示

ik_smart分词

# 通过ik分词器来分词

POST /_analyze

{

"analyzer": "ik_smart"

,"text": "我是中国人,我热爱我的祖国"

}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

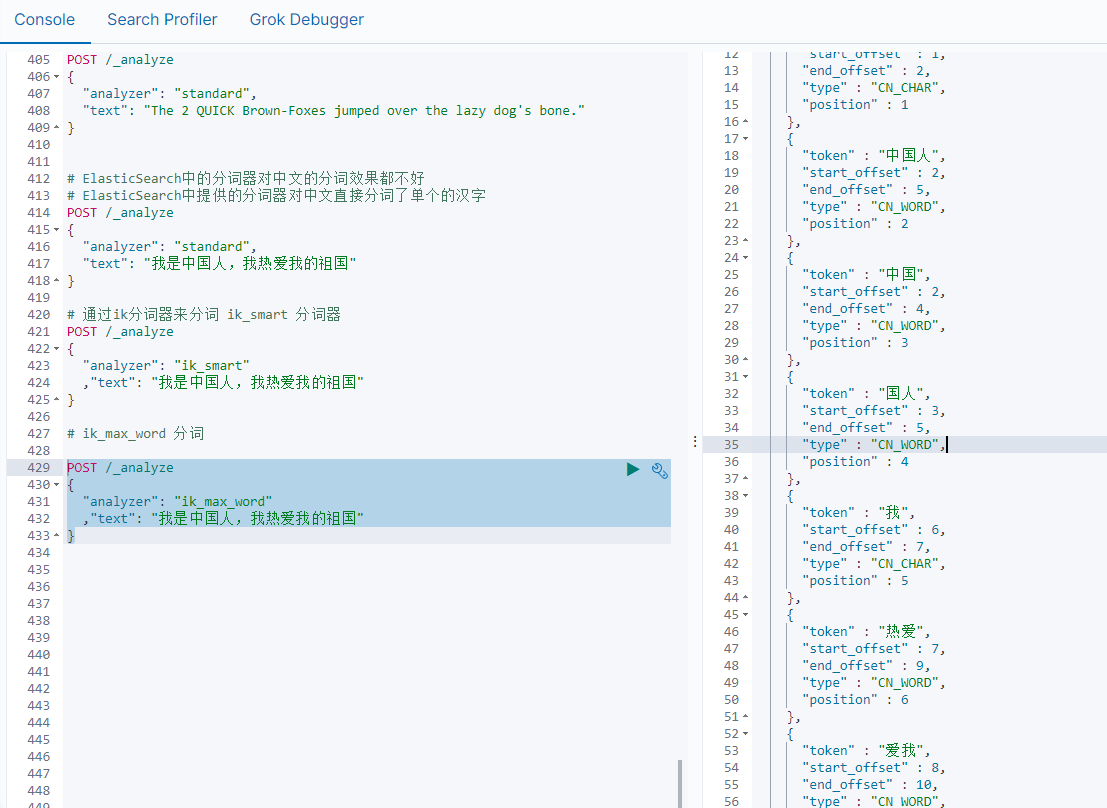

ik_max_word

POST /_analyze

{

"analyzer": "ik_max_word"

,"text": "我是中国人,我热爱我的祖国"

}

- 1

- 2

- 3

- 4

- 5

通过ik分词器的使用我们发现:如果使用ElasticSearch中默认提供的分词器是不支持中文分词的,也就是我们在定义一个索引的使用不能使用默认的mapping,而是要手动的来建立对应的mapping,在mapping我们需要选择对应的分词器。

3) 自定义词库

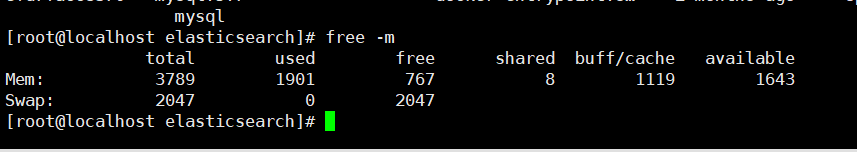

3.1 虚拟机扩容

安装的软件越来越多,虚拟机的空间有限,这时我们可以关闭虚拟机后扩容

ElasticSearch中原来分配的空间比较小,虚拟机空间增大后我们可以调整ElasticSearch的空间。

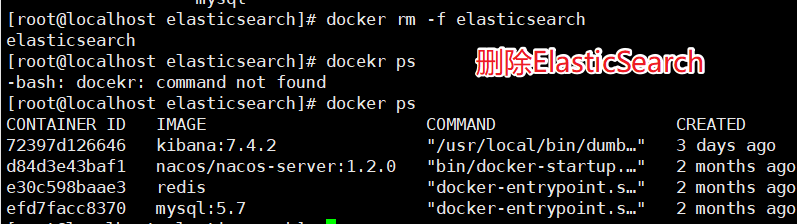

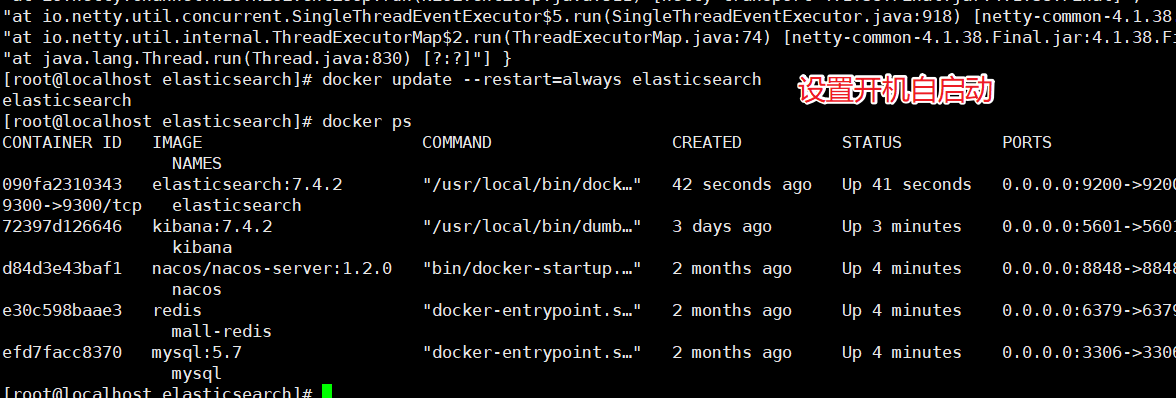

调整ElasticSearch的虚拟机内存,我们没办法直接修改,需要先删除原来的容器,然后创建新的容器。

调整JVM参数后重新启动容器:

docker run --name elasticsearch -p 9200:9200 -p 9300:9300 \-e "discovery.type=single-node" -e ES_JAVA_OPTS="-Xms64m -Xmx512m" -v /mydata/elasticsearch/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml -v /mydata/elasticsearch/data:/usr/share/elasticsearch/data -v /mydata/elasticsearch/plugins:/usr/share/elasticsearch/plugins -d elasticsearch:7.4.2

- 1

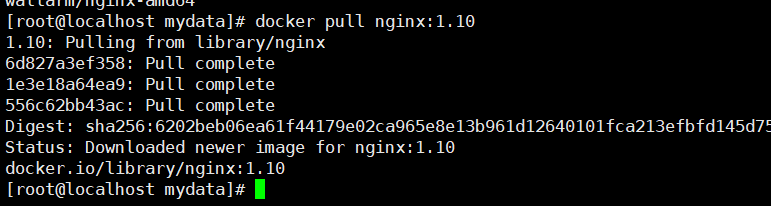

3.2 Nginx安装

先安装一个简单的Nginx实例,来获取对应的配置信息

拉取Nginx的镜像

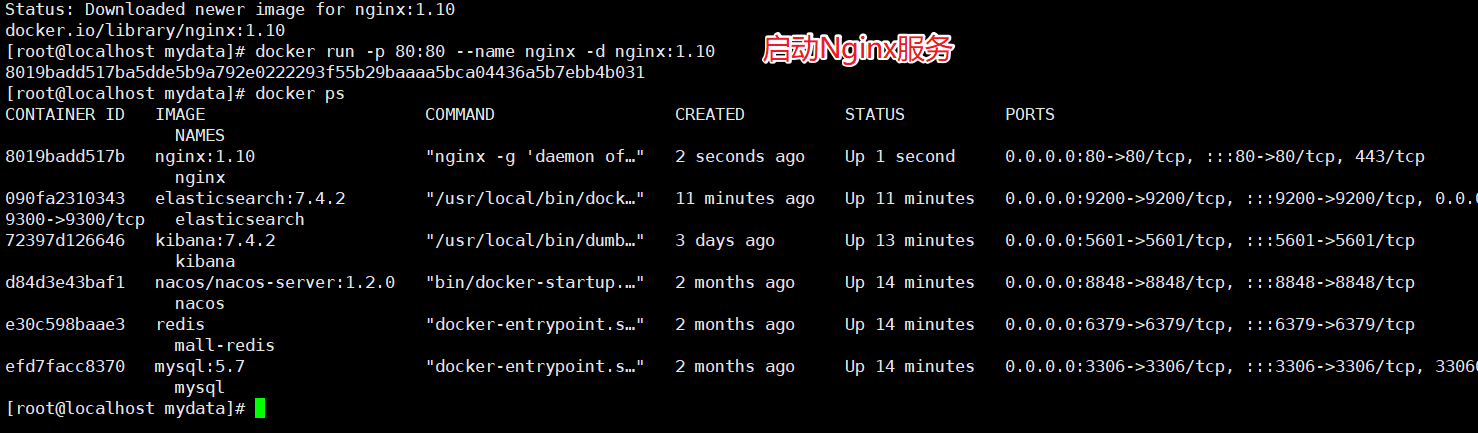

启动Nginx服务

docker run -d -p 80:80 --name nginx nginx:1.10

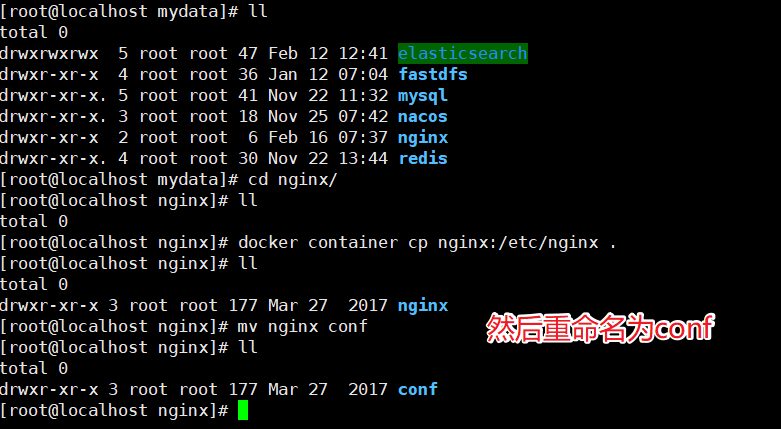

把容器中的配置文件拷贝到/mydata/nginx目录中

docker container cp nginx:/etc/nginx .

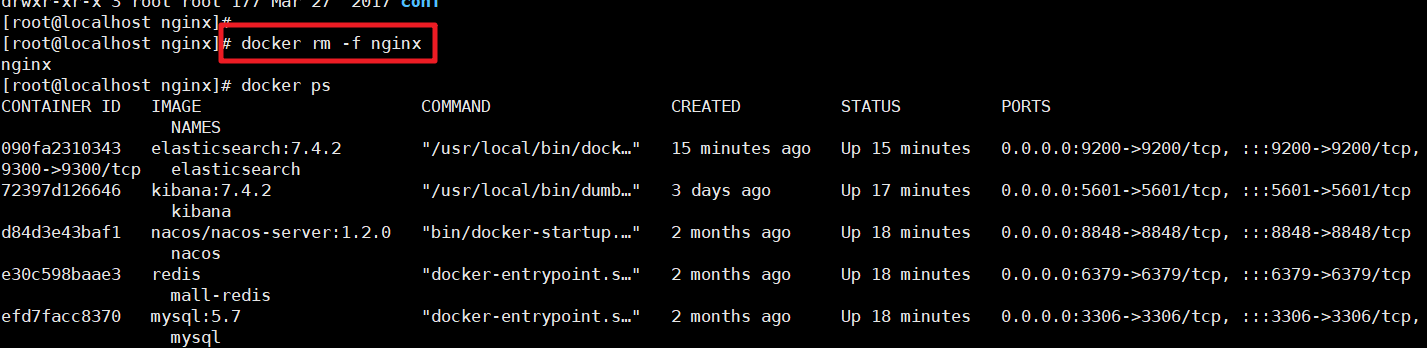

有了这个对应的配置文件夹后我们就可以删除掉之前的Nginx服务了

然后创建新的Nginx服务

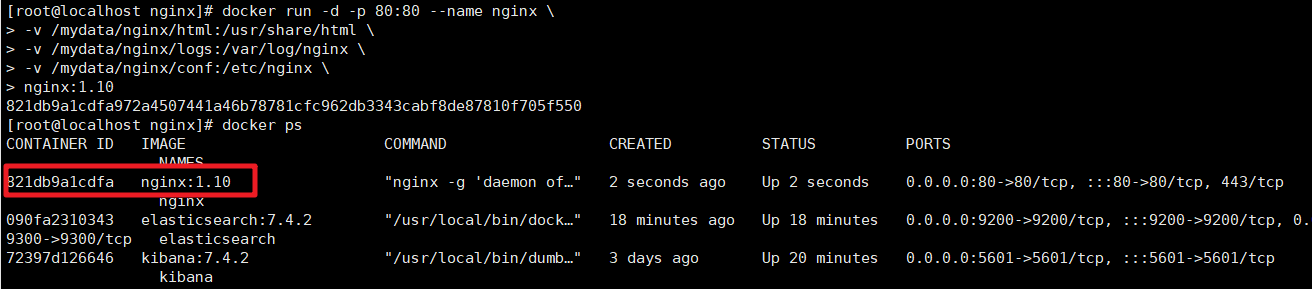

docker run -d -p 80:80 --name nginx \

-v /mydata/nginx/html:/usr/share/nginx/html \

-v /mydata/nginx/logs:/var/log/nginx \

-v /mydata/nginx/conf:/etc/nginx \

nginx:1.10

- 1

- 2

- 3

- 4

- 5

测试访问:

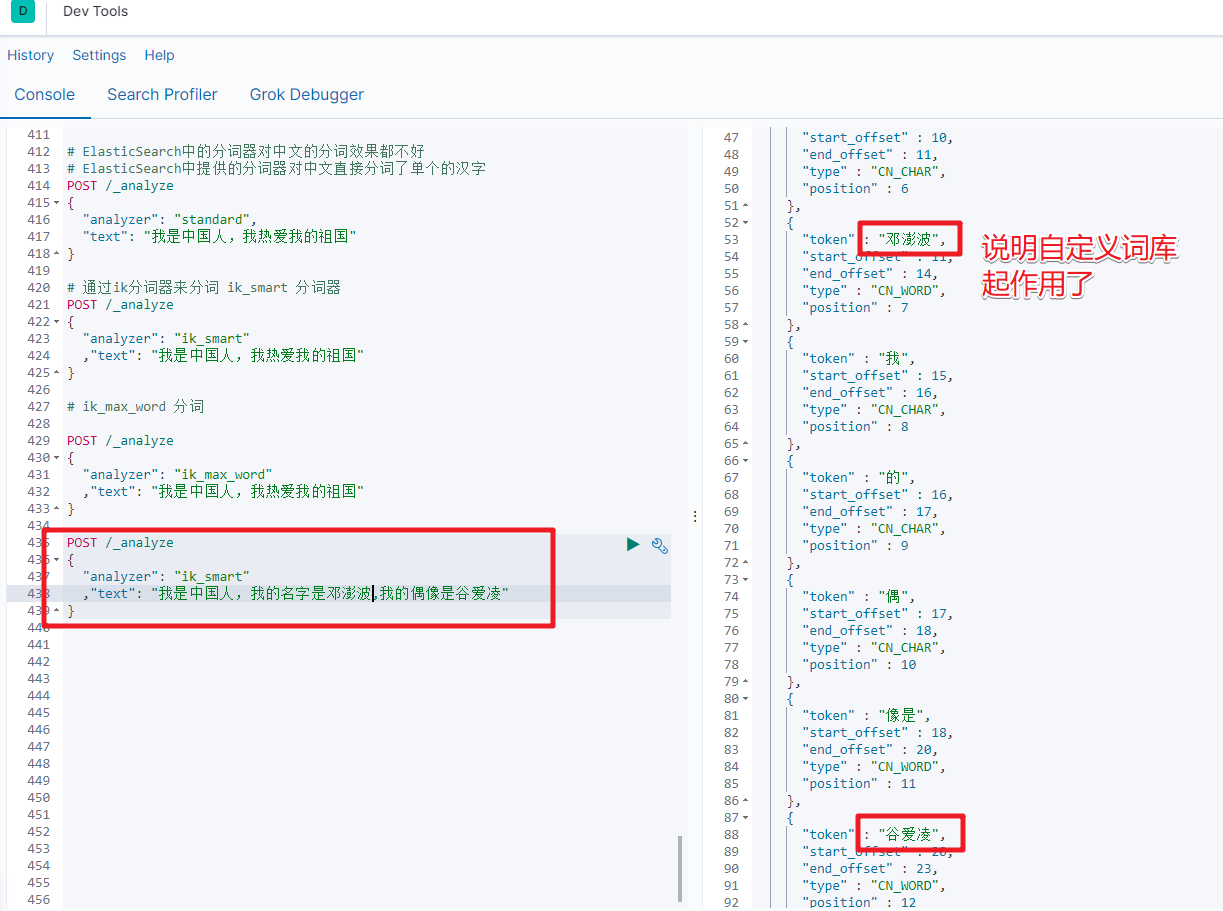

3.3 实现自定义词库

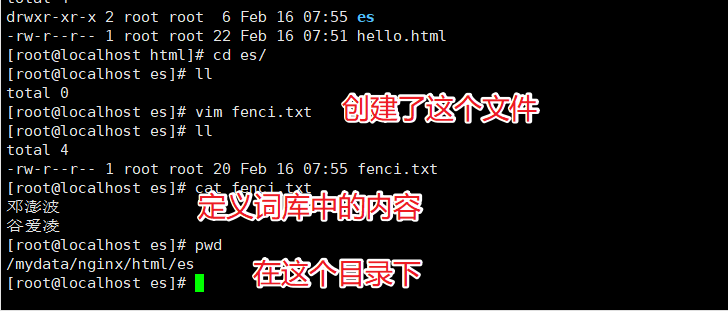

我们需要在Nginx中创建对应的词库文件

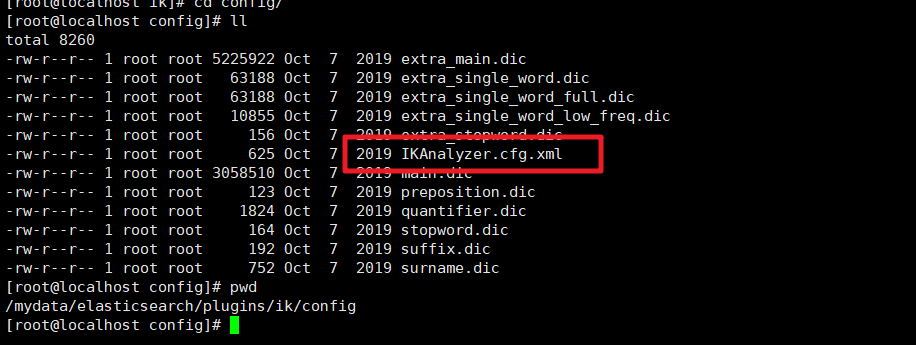

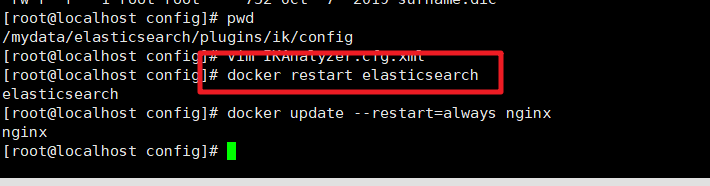

然后我们在ik分词器的插件的配置文件中修改远程词库的地址

/mydata/elasticsearch/plugins/ik/config

然后保存文件重启ElasticSearch服务即可

然后在Kibana中检索测试即可

好了,本文就分享到这里,下篇文章我们分享ElasticSearch的Java客户端实现,敬请期待哦

文章来源: dpb-bobokaoya-sm.blog.csdn.net,作者:波波烤鸭,版权归原作者所有,如需转载,请联系作者。

原文链接:dpb-bobokaoya-sm.blog.csdn.net/article/details/122974105

- 点赞

- 收藏

- 关注作者

评论(0)