【组队学习】Task03:学习BERT和GPT

【摘要】 组队学习资料:datawhale8月组队学习-基于transformers的自然语言处理(NLP)入门Task03主要学习内容:2.3-图解BERT.md2.4-图解GPT.md声明:NLP纯小白,本文内容主要是作为个人学习笔记,可能很多地方我自己理解也不是很到位,仅供参考,有争议的话可以多查点儿其他资料,并请评论区留言指正!谢谢 图解BERT 图解GPT BERT使用基本思路BERT开源...

组队学习资料:

datawhale8月组队学习

-基于transformers的自然语言处理(NLP)入门

Task03主要学习内容:

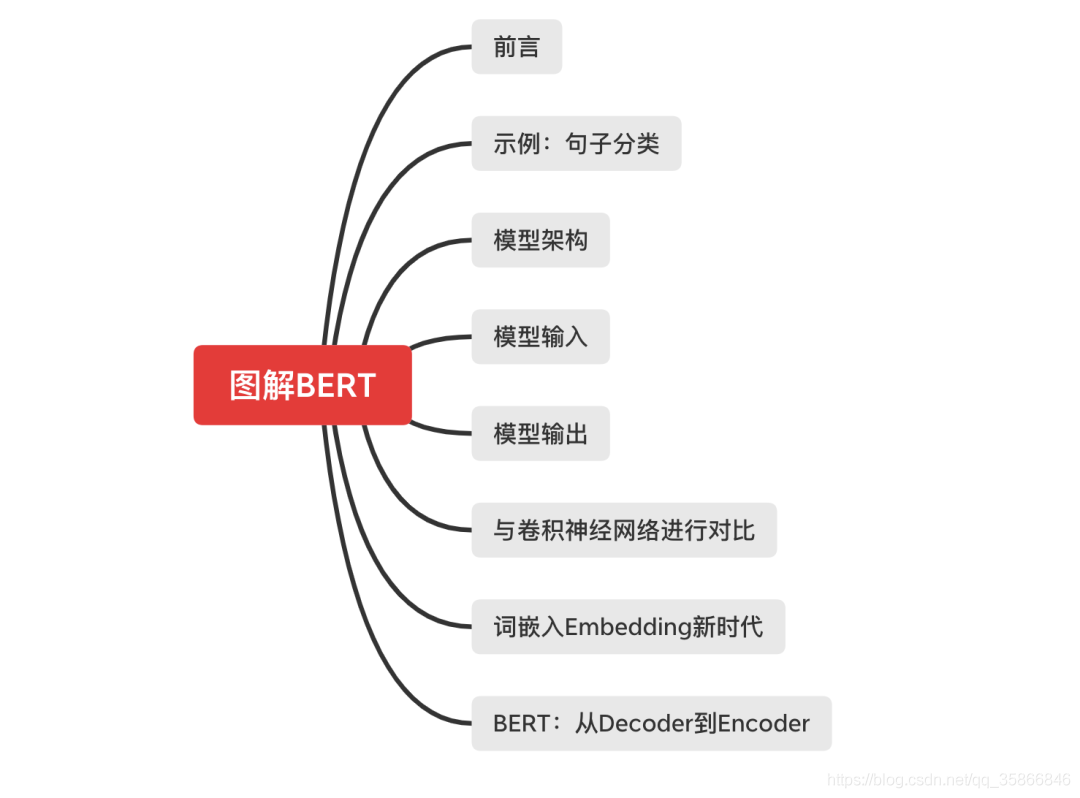

2.3-图解BERT.md

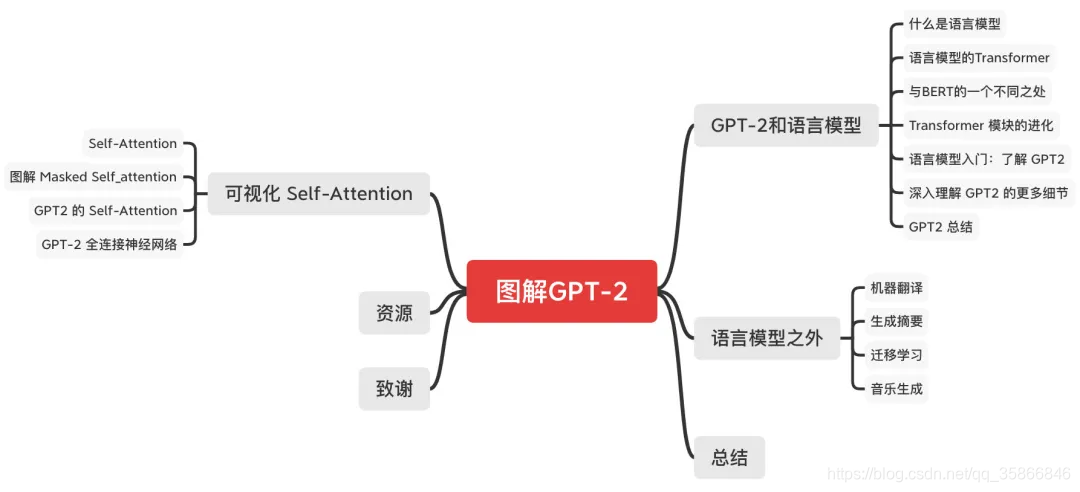

2.4-图解GPT.md

声明:NLP纯小白,本文内容主要是作为个人学习笔记,可能很多地方我自己理解也不是很到位,仅供参考,有争议的话可以多查点儿其他资料,并请评论区留言指正!谢谢

图解BERT

图解GPT

BERT使用基本思路

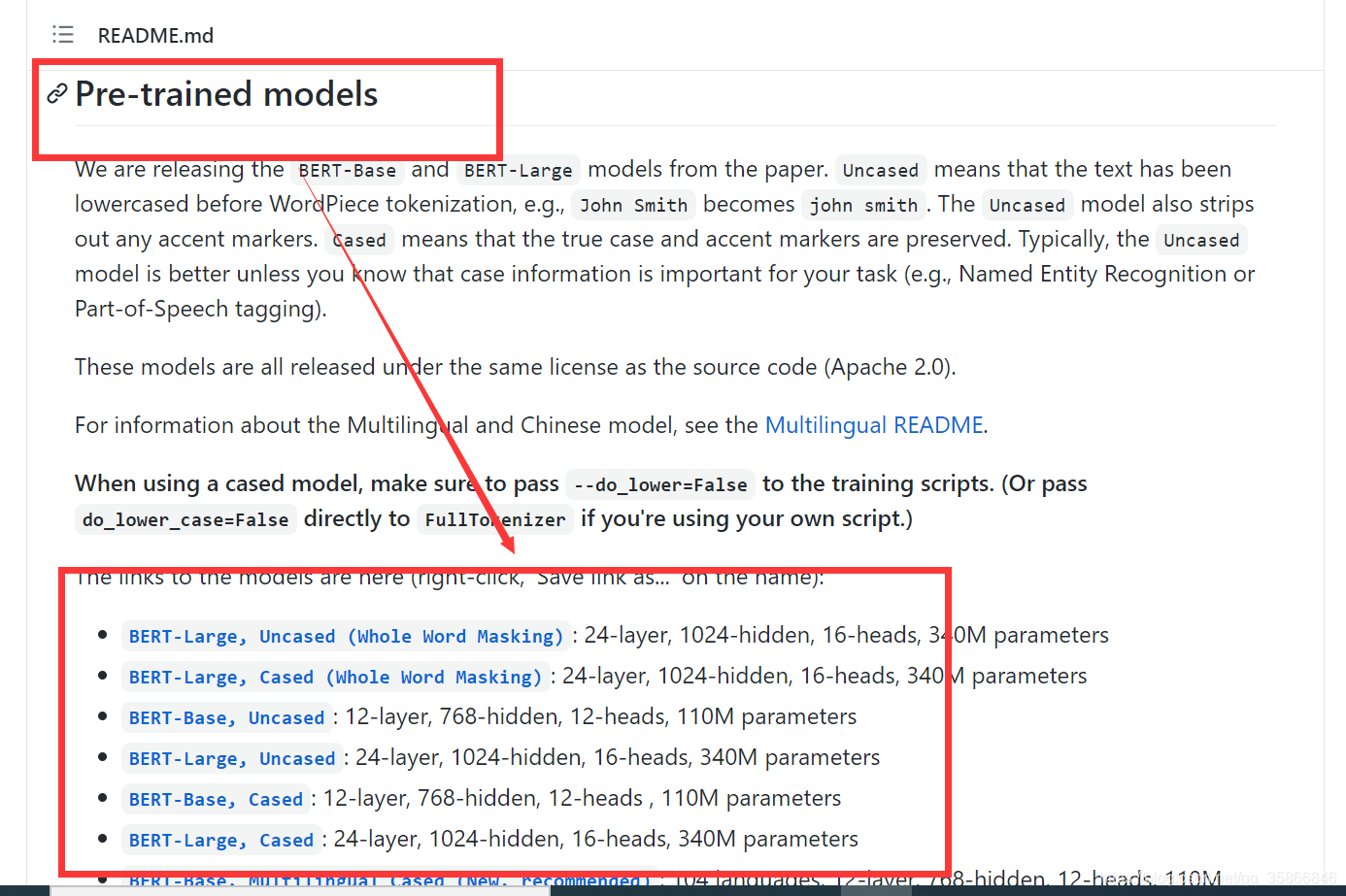

BERT开源github地址

基本使用思路:查找预训练好的模型,在别人已有模型基础上进行自主化训练

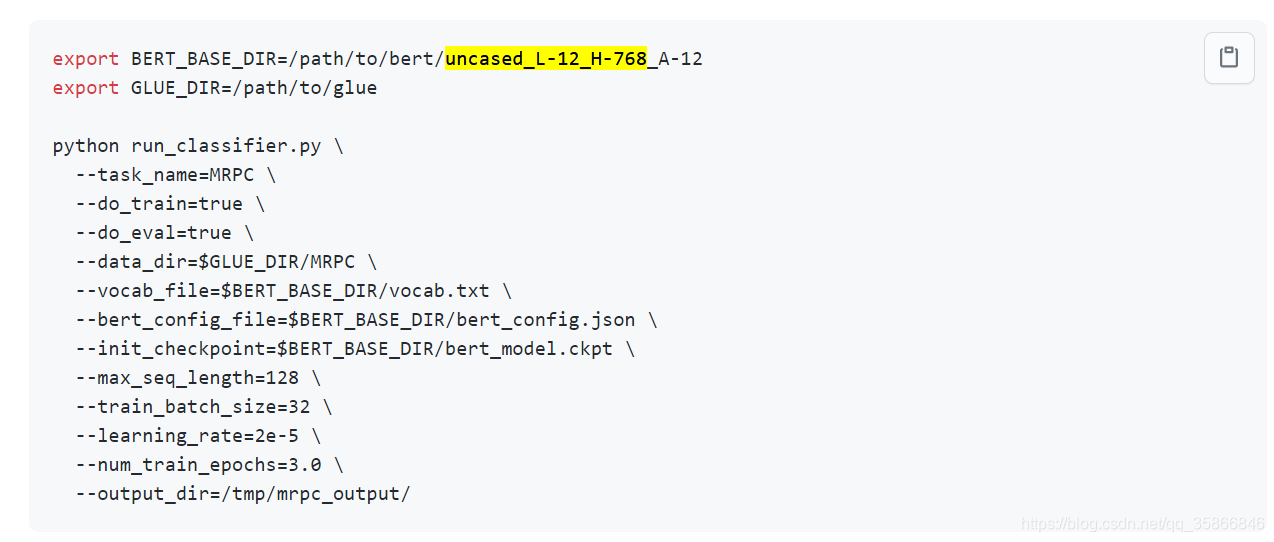

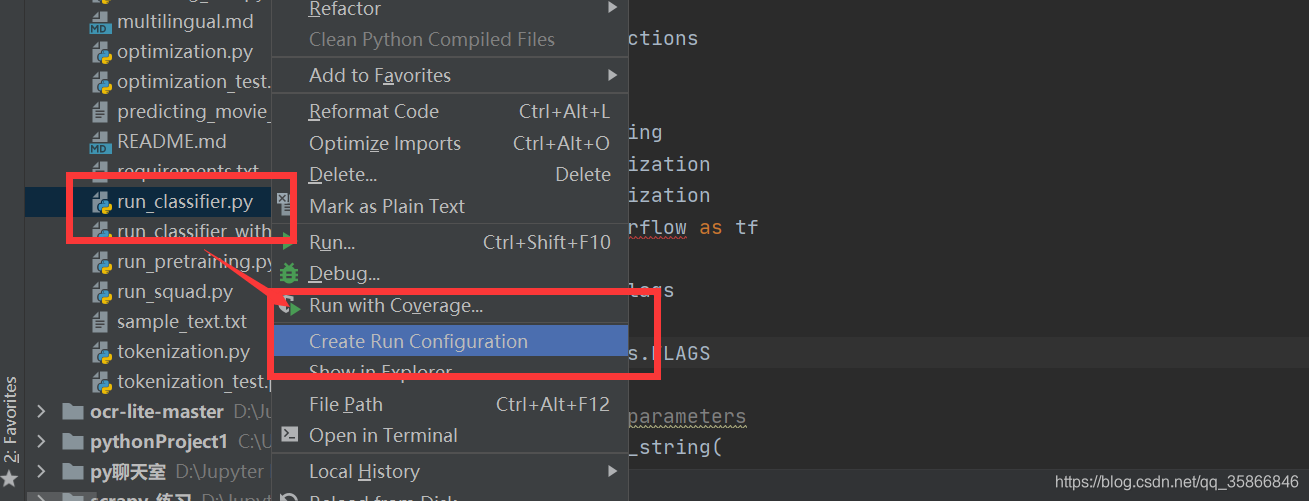

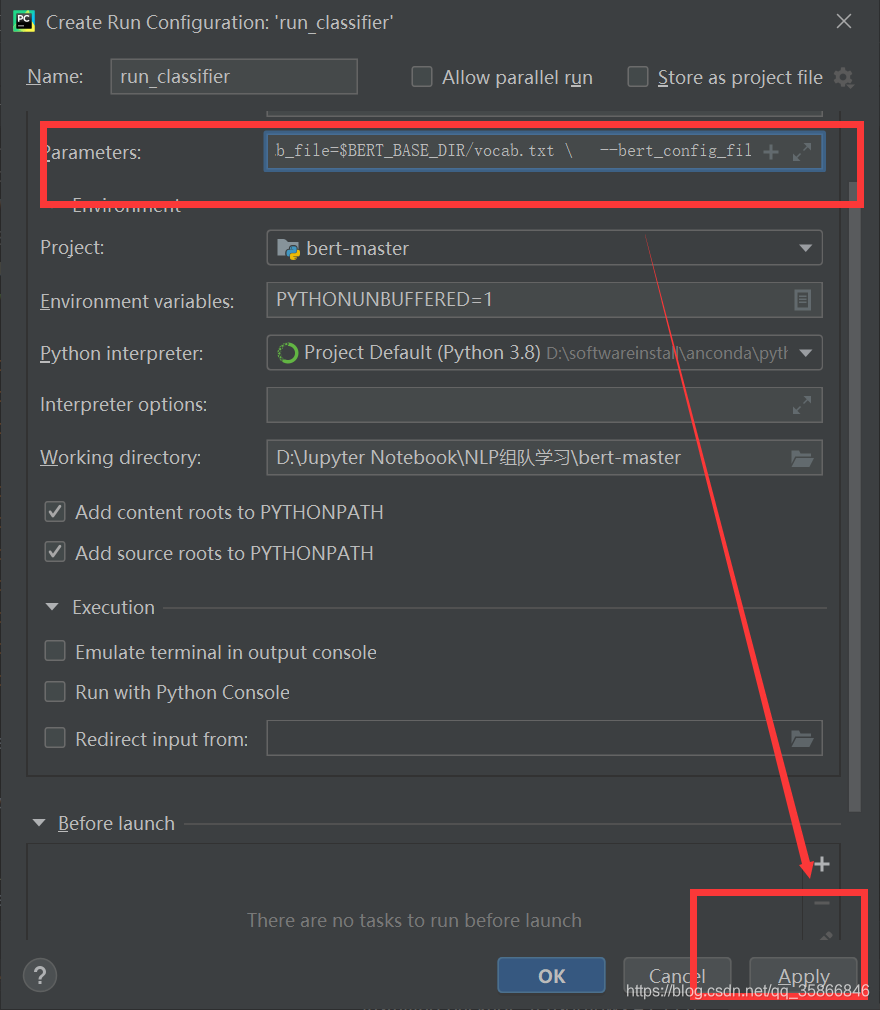

基于MRPC的BERT代码实现

篇章小测

1、问题4: BERT预训练时mask的比例,可以mask更大的比例吗?

2、问题5: BERT如何进行tokenize操作?有什么好处?

3、问题6: GPT如何进行tokenize操作?和BERT的区别是什么?

4、问题7: BERT模型特别大,单张GPU训练仅仅只能放入1个batch的时候,怎么训练?

其他参考资料

问题:AttributeError: module ‘tensorflow’ has no attribute ‘gfile’

import tensorflow 报错 as tf ImportError: DLL load failed

TensorFlow报错:AttributeError: module ‘tensorflow_core._api.v2.train’ has no attribute 'Optimizer‘

【版权声明】本文为华为云社区用户原创内容,未经允许不得转载,如需转载请自行联系原作者进行授权。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)