python pynlpir中科院分词的使用

中科院汉语分词系统是一个非常好用的分词工具,和结巴分词类似,但是比结巴分词功能更加强大,而且更加个性化。

中科院分词的使用步骤如下:

- 导入中科院分词模块 初始化pynlpir分词库。

- 在pynlpir库中提供了open()函数用来初始化pynlpir分词库

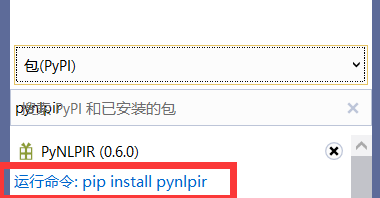

1、需要下载【pynlpir】库

2、【open()】函数介绍:

open()函数的原型如下:

pynlpir.open(data_dir=pynlpir.nlpir.PACKAGE_DIR, encoding=pynlpir.ENCODING, encoding_errors=pynlpir.ENCODING_ERRORS, license_code=None)

参数说明如下:

data_dir:表示分词数据目录对应的绝对路径,默认值为pynlpir.nlpir.PACKAGE_DIR。

encoding:表示针对中文的编码格式,默认为utf_8,也可以为gbk、big5。

encoding_errors:表示所需的编码错误处理方案,默认为strict,也可以为ignore、replace。

license_code:表示使用中科院分词的许可证编码,仅商业用户需要

3、【segment()】函数介绍:

中科院分词提供了segment()函数进行分词,并返回分词后的列表。函数原型如下:

【pynlpir.segment(s, pos_tagging=True, pos_names='parent', pos_english=True)】

参数说明如下:

s:需要分词的中文,必须是Unicode编码或者UTF-8编码的字符串。

pos_tagging:表示是否包含部分的词性标注,值为False时表示只做分词,而不显示词性(形容词、名词等)。

pos_names:参数在pos_tagging为True时才生效,只能是parent、child和all三个值,默认是parent,表示获取该词性的最顶级词性,child表示获取该词性的最具体的信息,all表示获取该词性相关的所有词性信息。

pos_english:表示词性标注结果是否以中文的形式显示,为False表示以中文的形式显示

4、【get_key_words()】函数介绍:

函数原型:【pynlpir.get_key_words(s ,max_words=50, weighted=False)】

参数说明如下:

s:需要分词的中文,必须是Unicode编码或者UTF-8编码的字符串。

max_words:表示最多能够查找的关键字,默认为50。

weighted:表示是否返回关键字的权重,默认不返回

5、实际使用:

在实际使用中,往往需要针对某一段文字统计其中关键字出现的次数。

’通过对次数的统计可以知道哪些关键字经常出现。

使用中科院分词进行关键字统计的步骤如下: 定义一个字典对象,用来保存关键字和其出现的次数。初始化该列表数据,关键字出现的次数设置为初始值0。

使用get_key_words()函数获取关键字的列表数据。

使用segment()函数对该段文字进行分词处理,从而得到返回的分词列表数据。 循环遍历分词列表数据,判断其中的元素是否属于关键字,如果属于关键字则将字典对象中对应关键字出现的次数加1

愿本文对你的文章分析能有一个非常有效的帮助。

- 点赞

- 收藏

- 关注作者

评论(0)