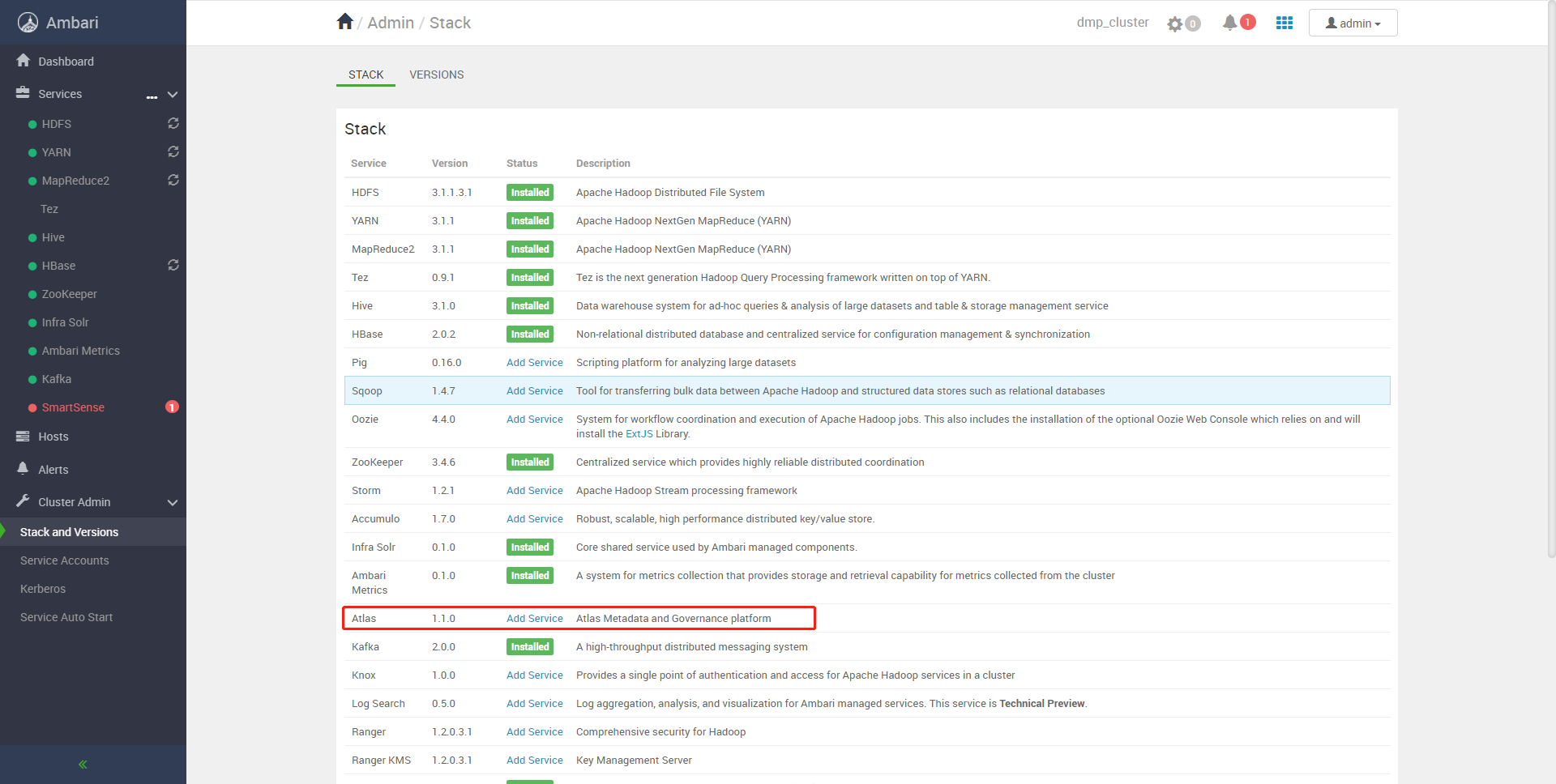

Ambari部署Atlas

选择Atlas服务

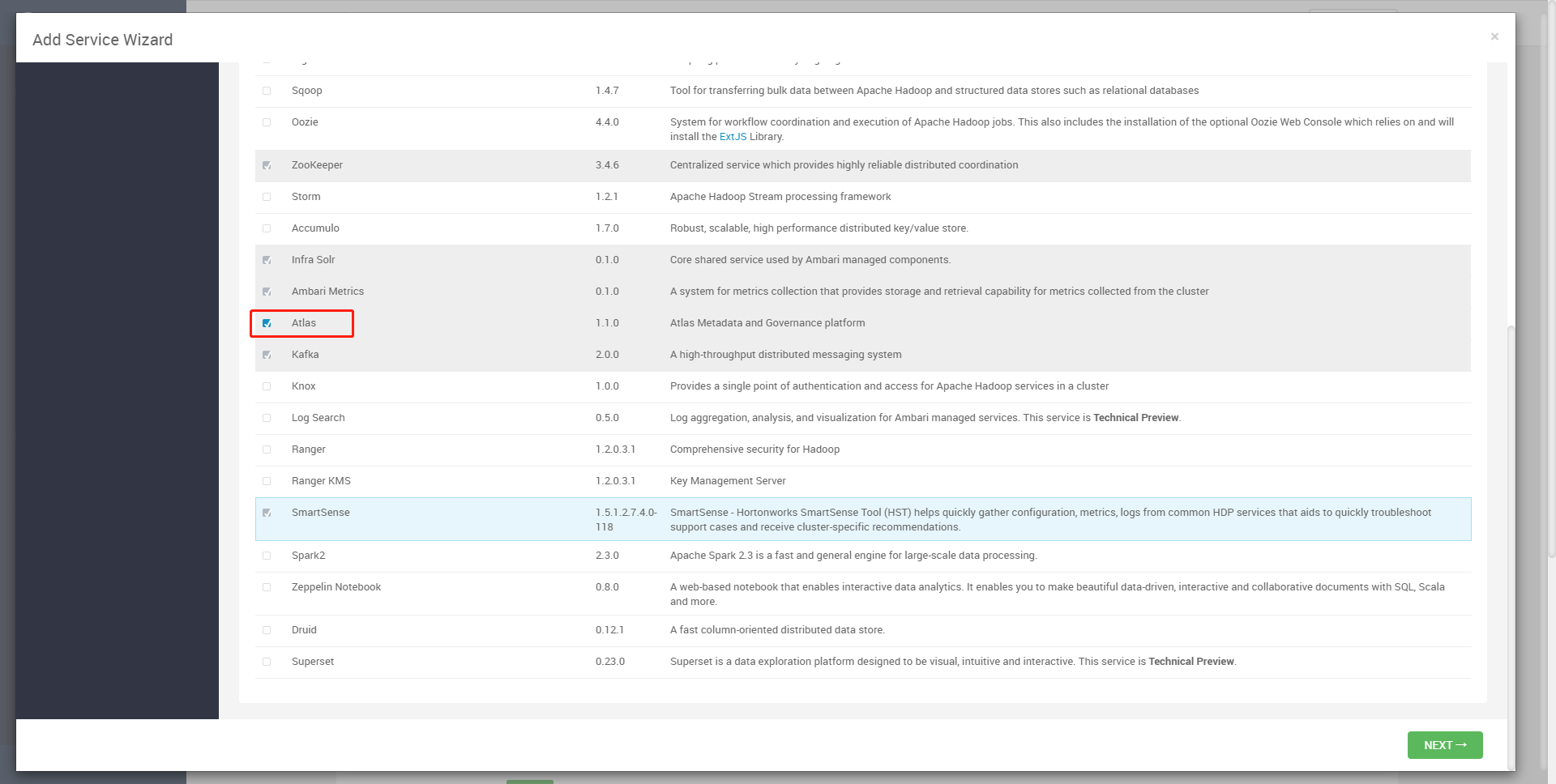

选择Atlas

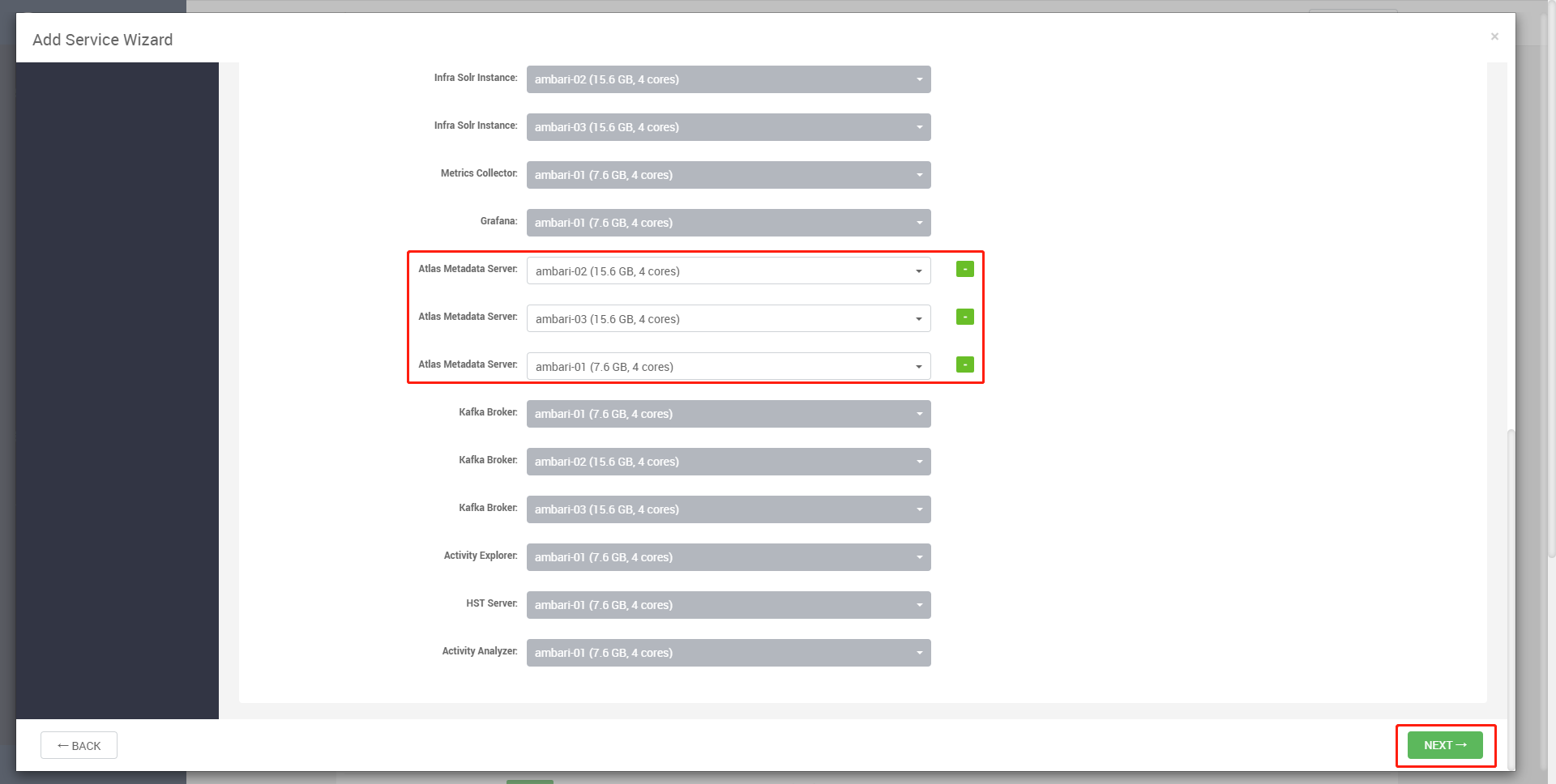

选择多节点部署HA集群

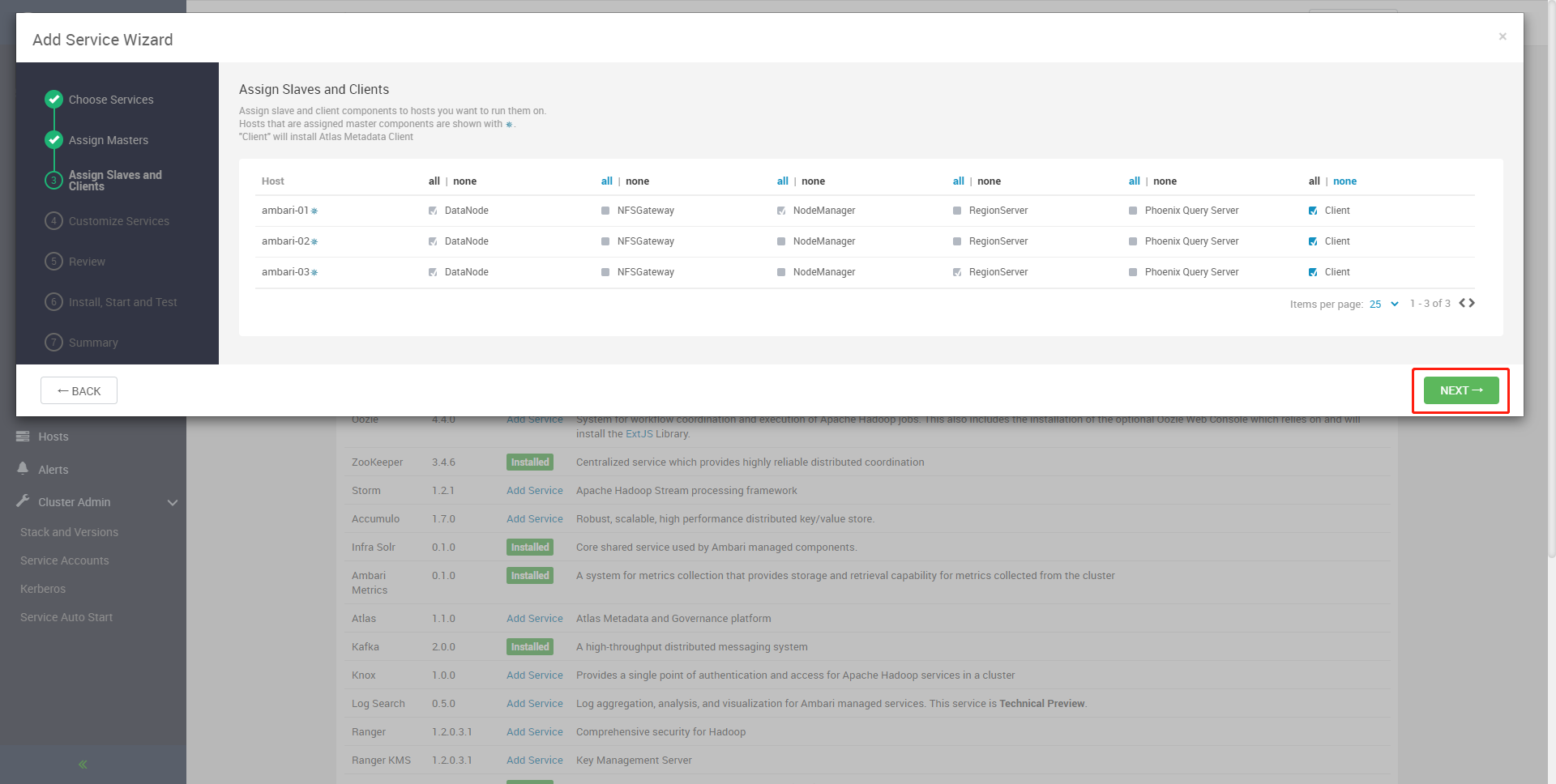

分配从站和客户端,选择客户端全节点安装 Next

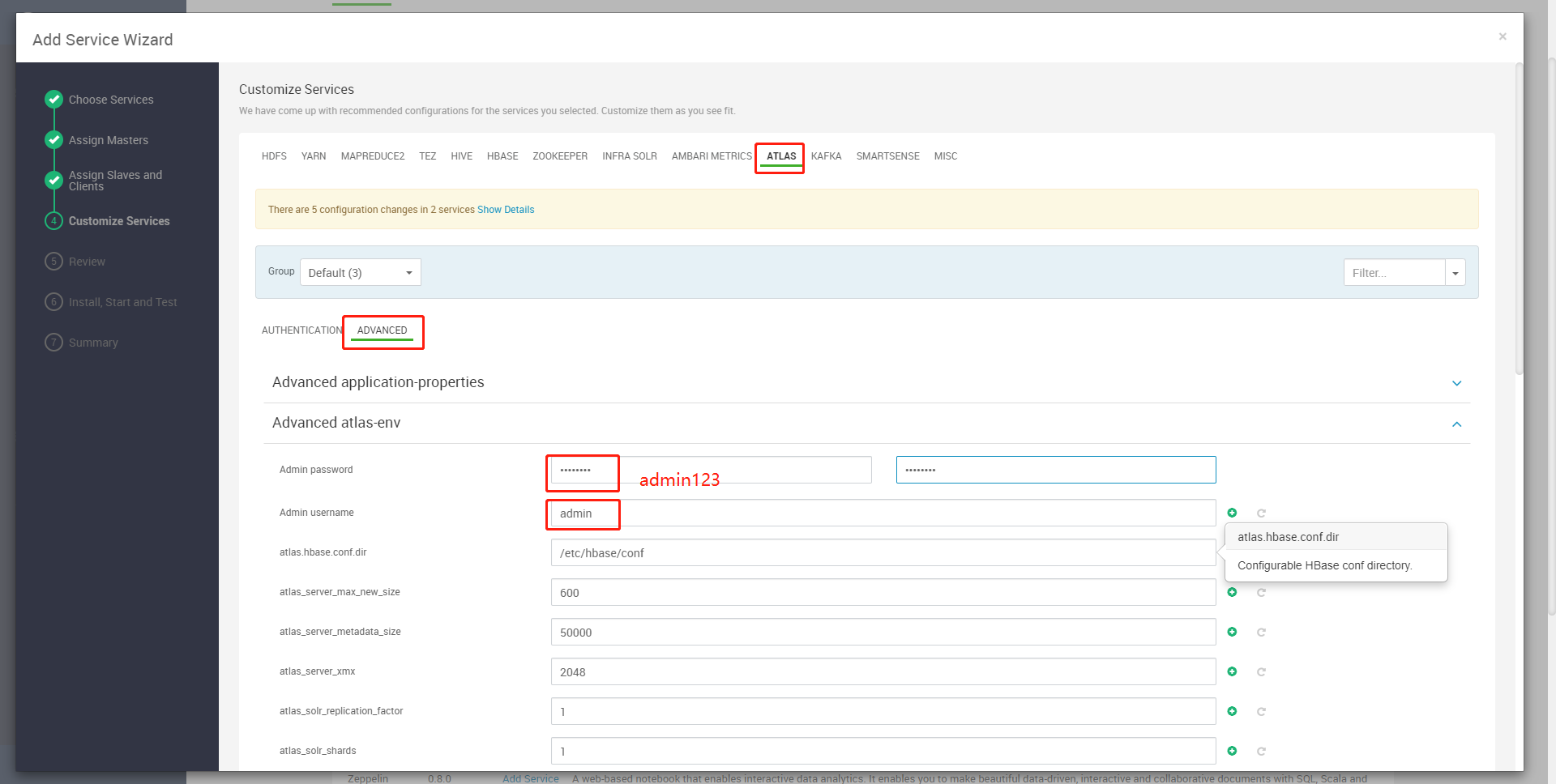

ADVANCED Advaced atlas-env

设置管理员密码为admin123,管理员用户默认为admin:

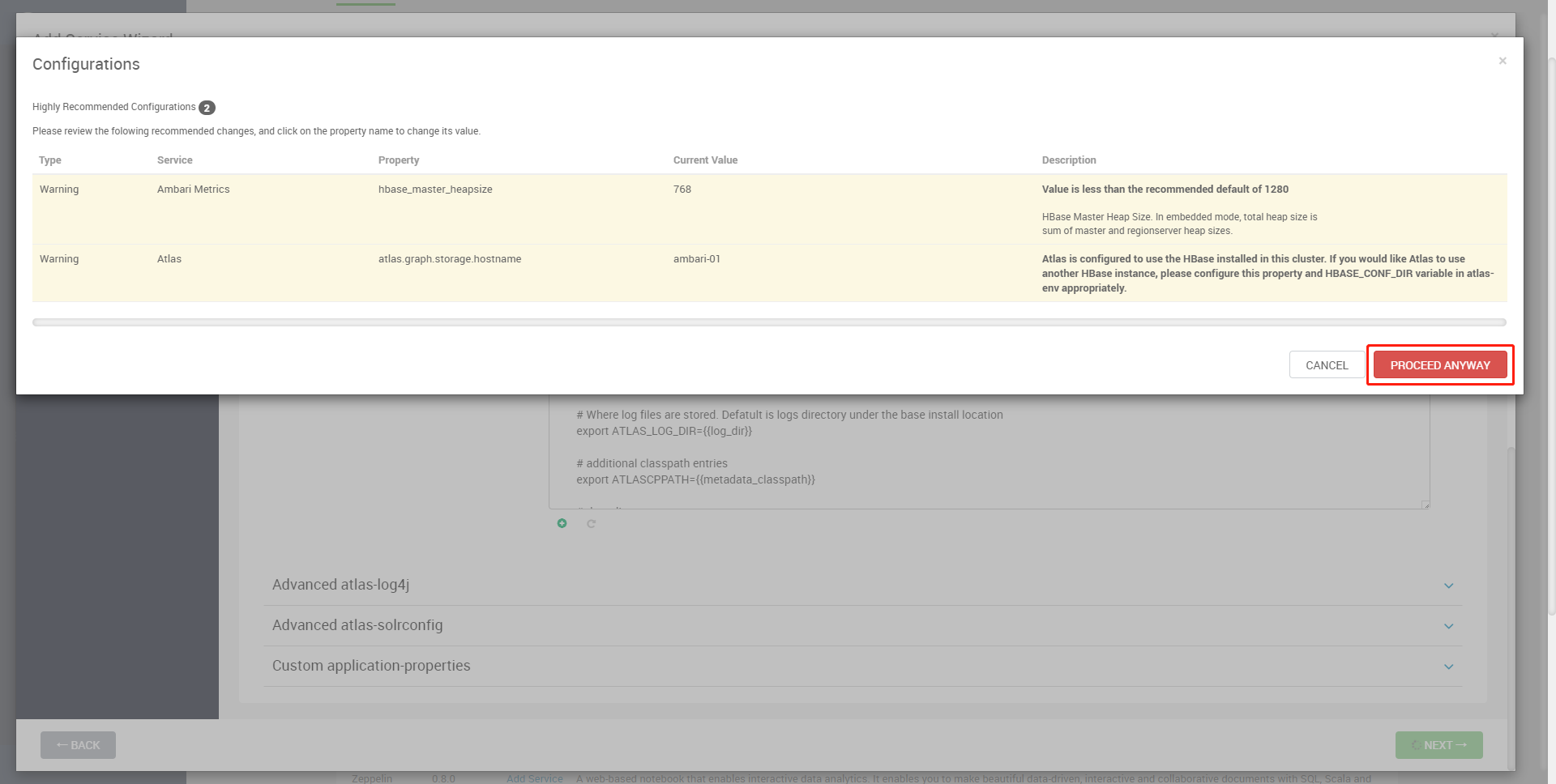

这里是HBase主堆大小没达到最小设置值,可以不用改,Proceed Anyway仍要继续

Atlas is configured to use the HBase installed in this cluster. If you would like Atlas to use another HBase instance, please configure this property and HBASE_CONF_DIR variable in atlas-env appropriately.

Atlas配置为使用此群集中安装的HBase。如果您希望Atlas使用另一个HBase实例,请在Atlas env中适当地配置此属性和HBASE_CONF_DIR变量。

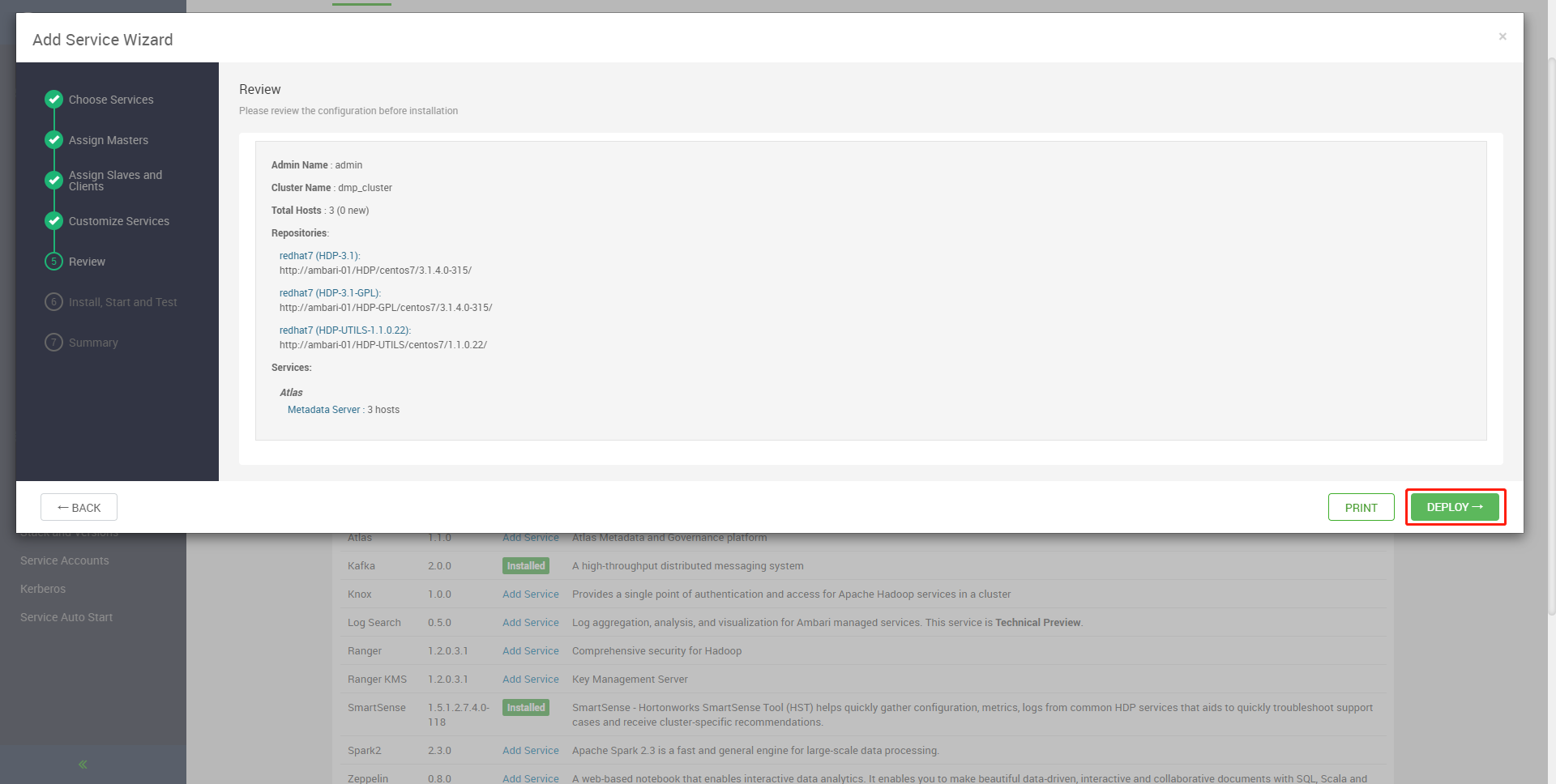

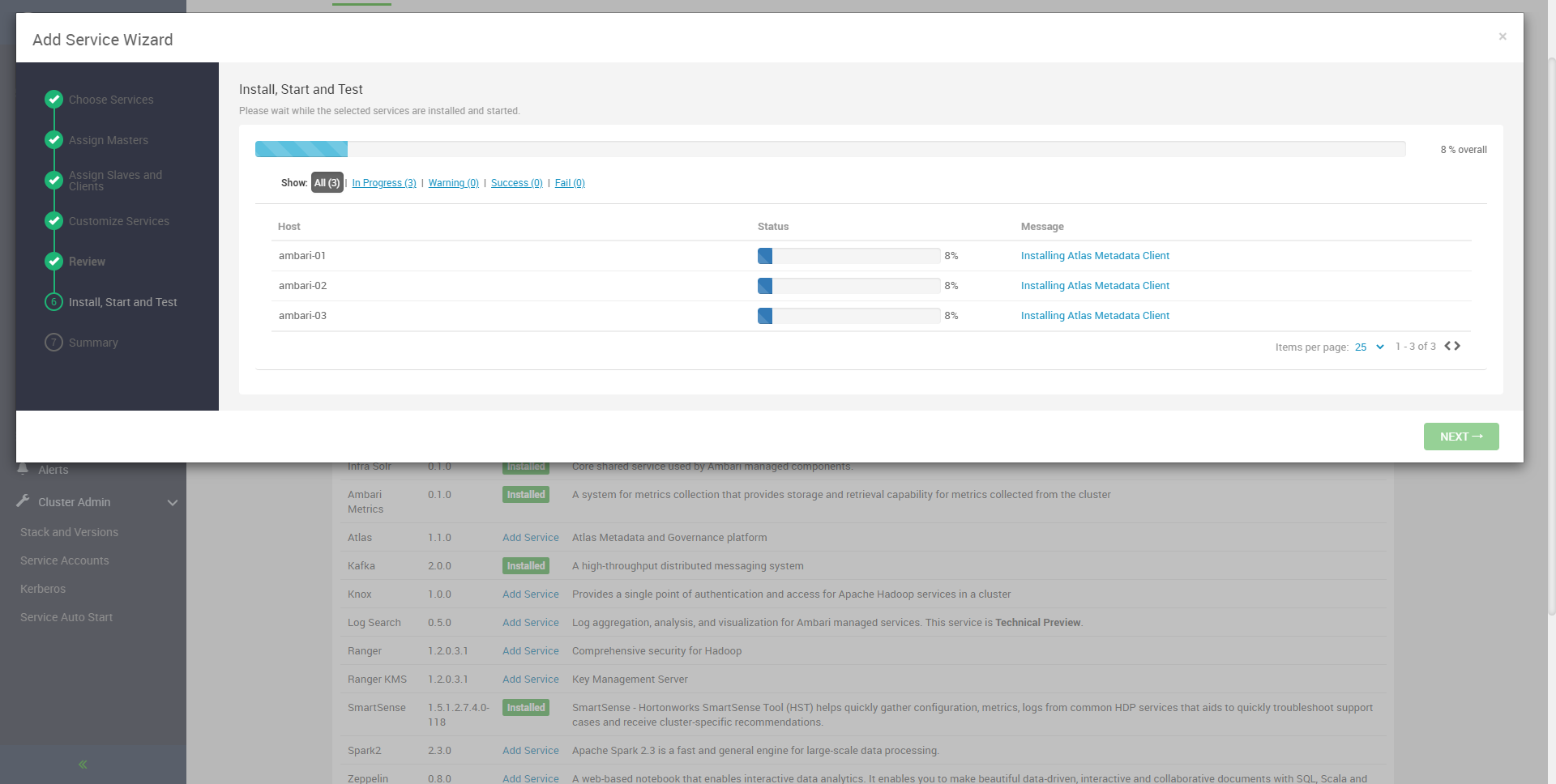

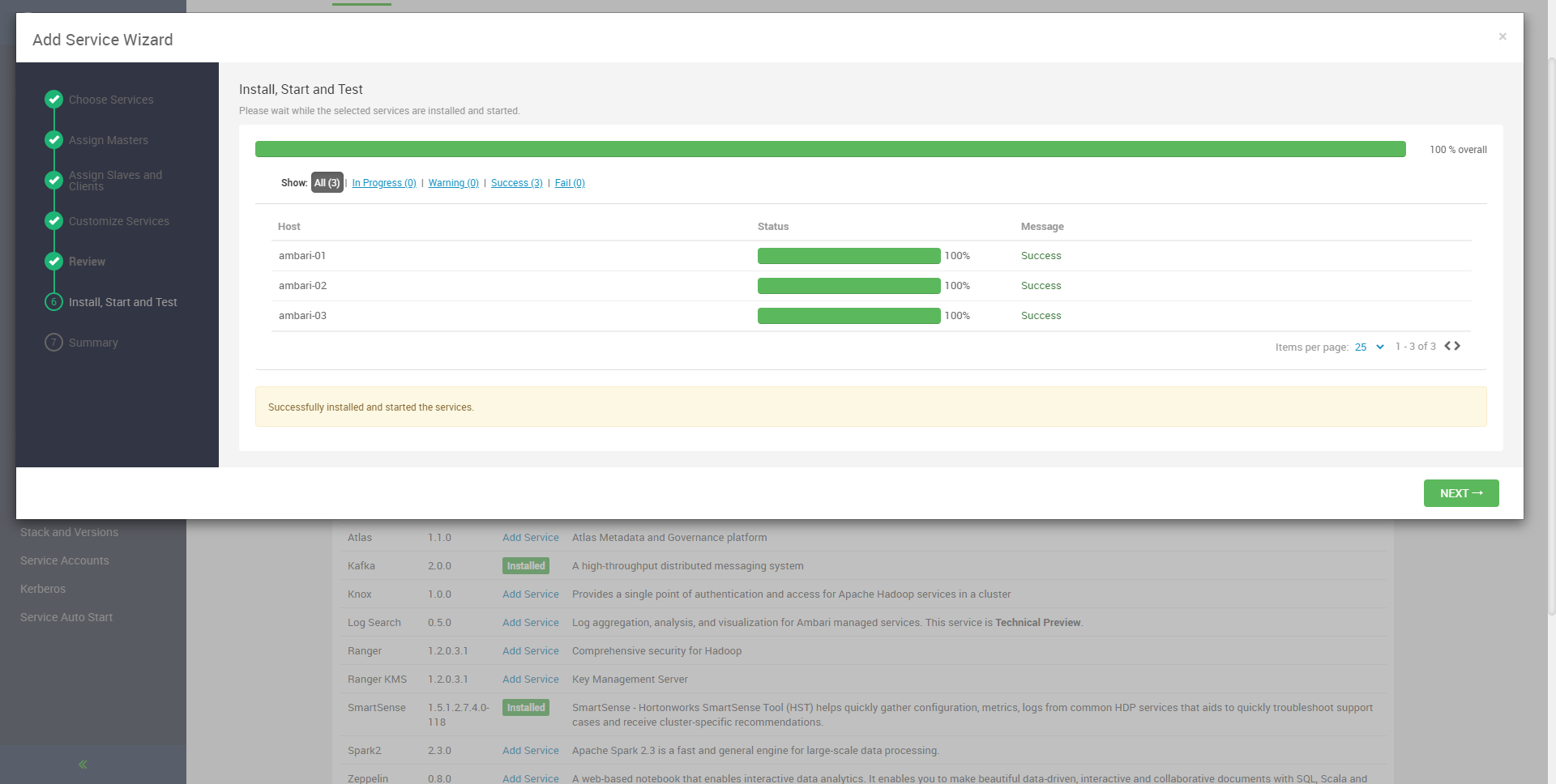

DEPLOY Install Start and Test

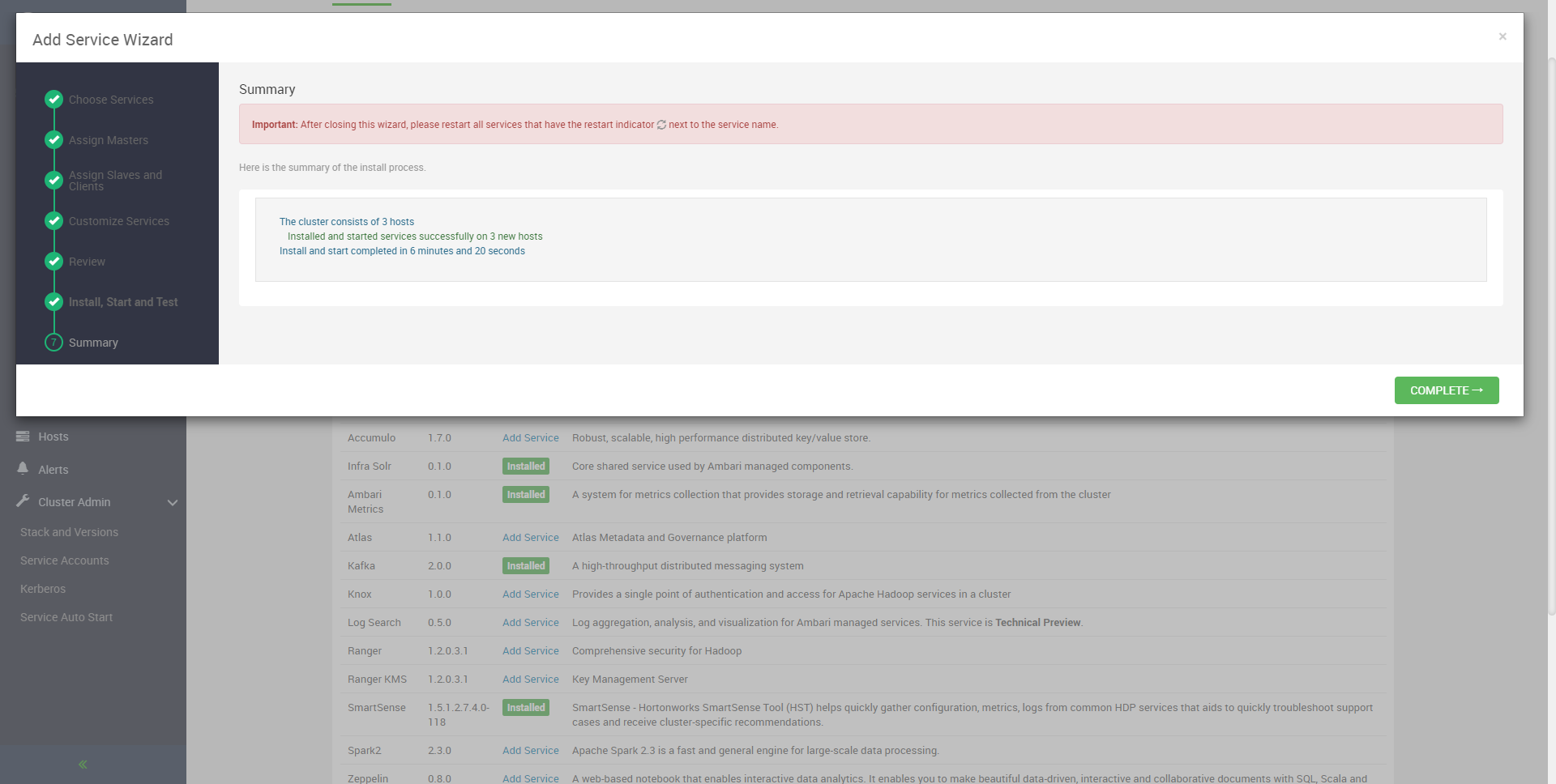

Summary 注意提示

Important: After closing this wizard, please restart all services that have the restart indicator next to the service name.

重要提示:关闭此向导后,请重新启动服务名称旁边有重新启动指示器的所有服务。

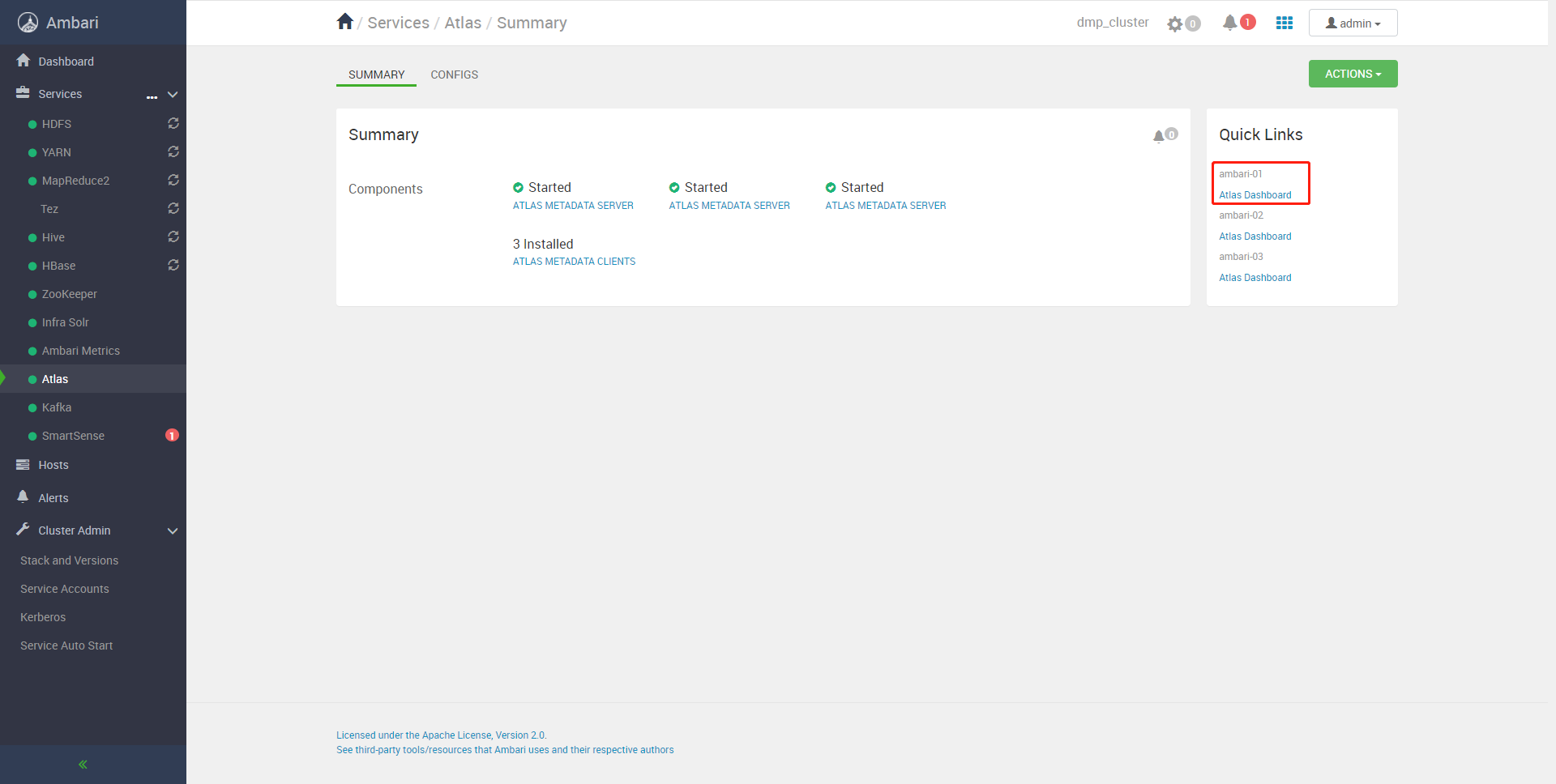

验证是否安装成功

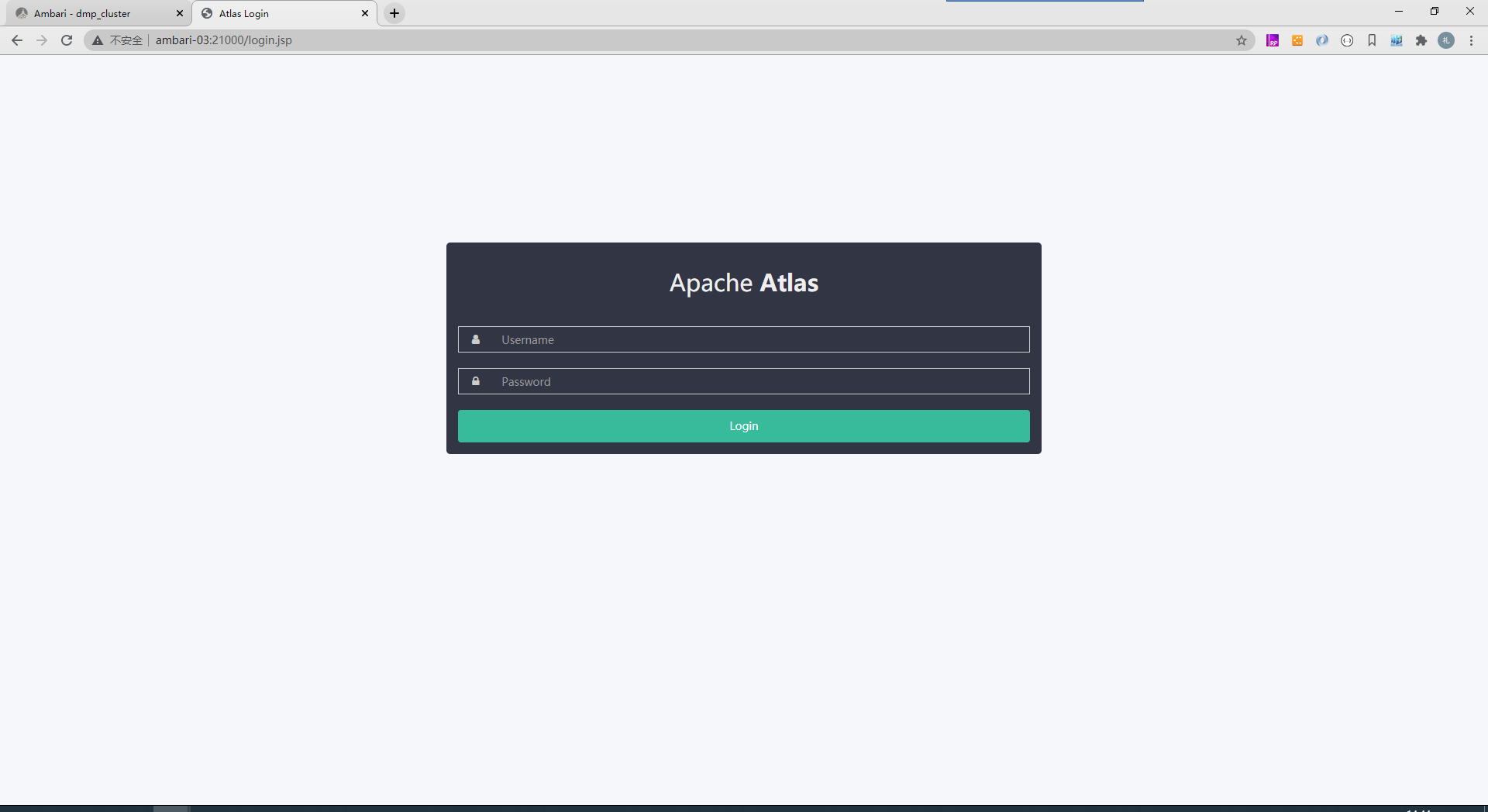

登录Atlas ambari-03:21000/login.jsp admin admin123

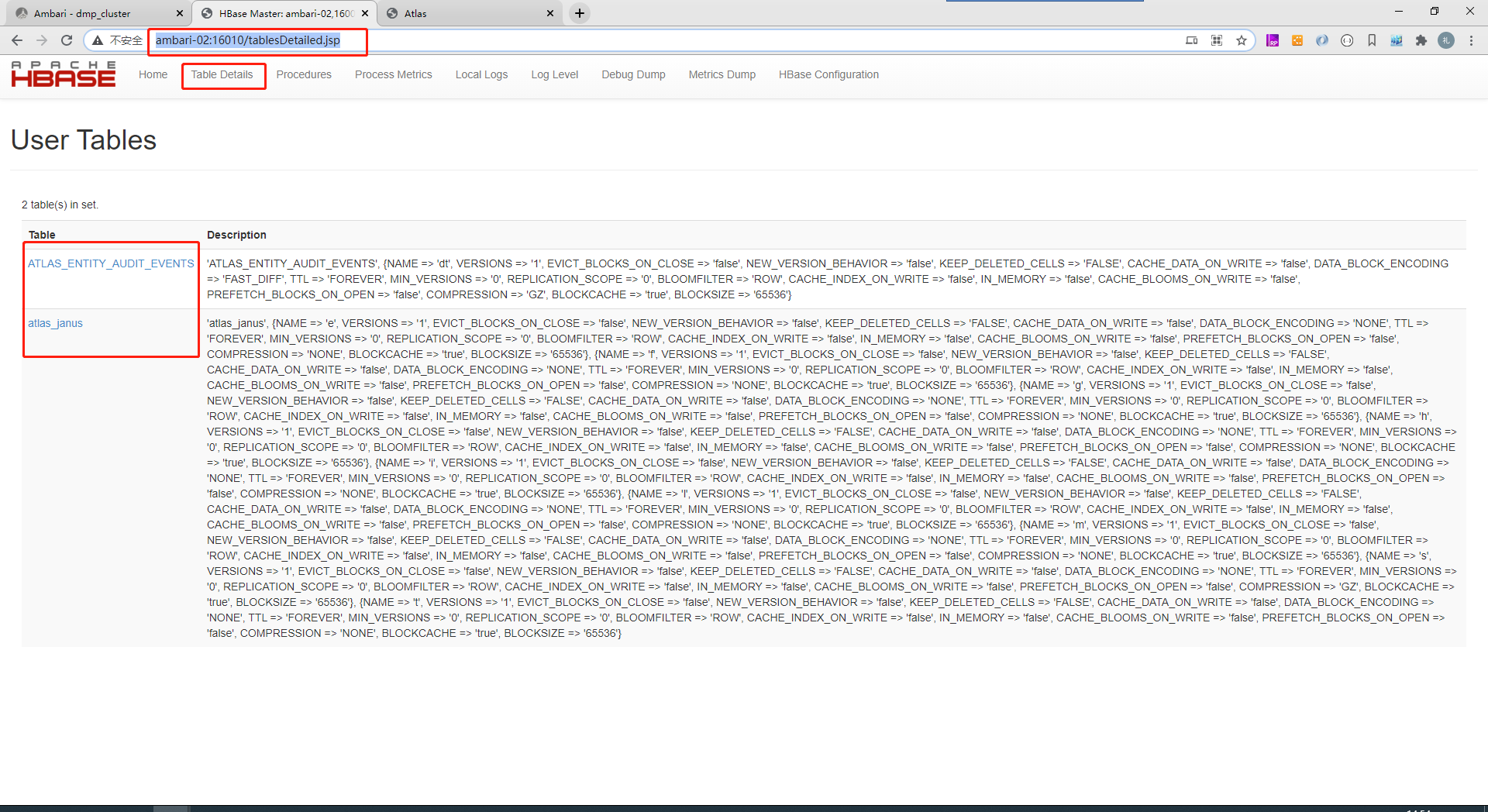

验证HBase表是否创建

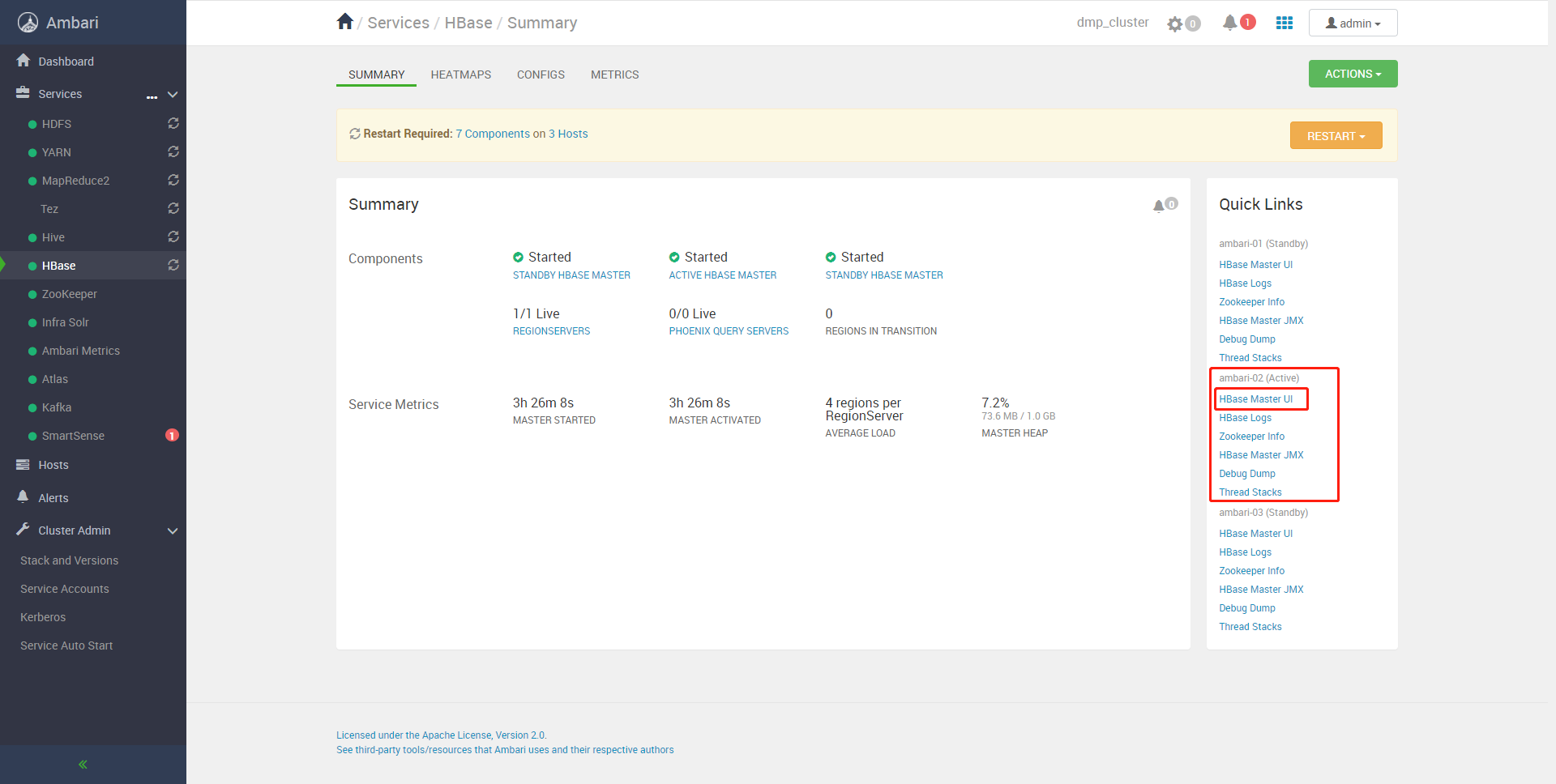

进入HBase UI应该看到Atlas创建了两个表: 找到Active

ATLAS_ENTITY_AUDIT_EVENTS

atlas_janus

Atlas会把元数据存储和事件在这两个表里。

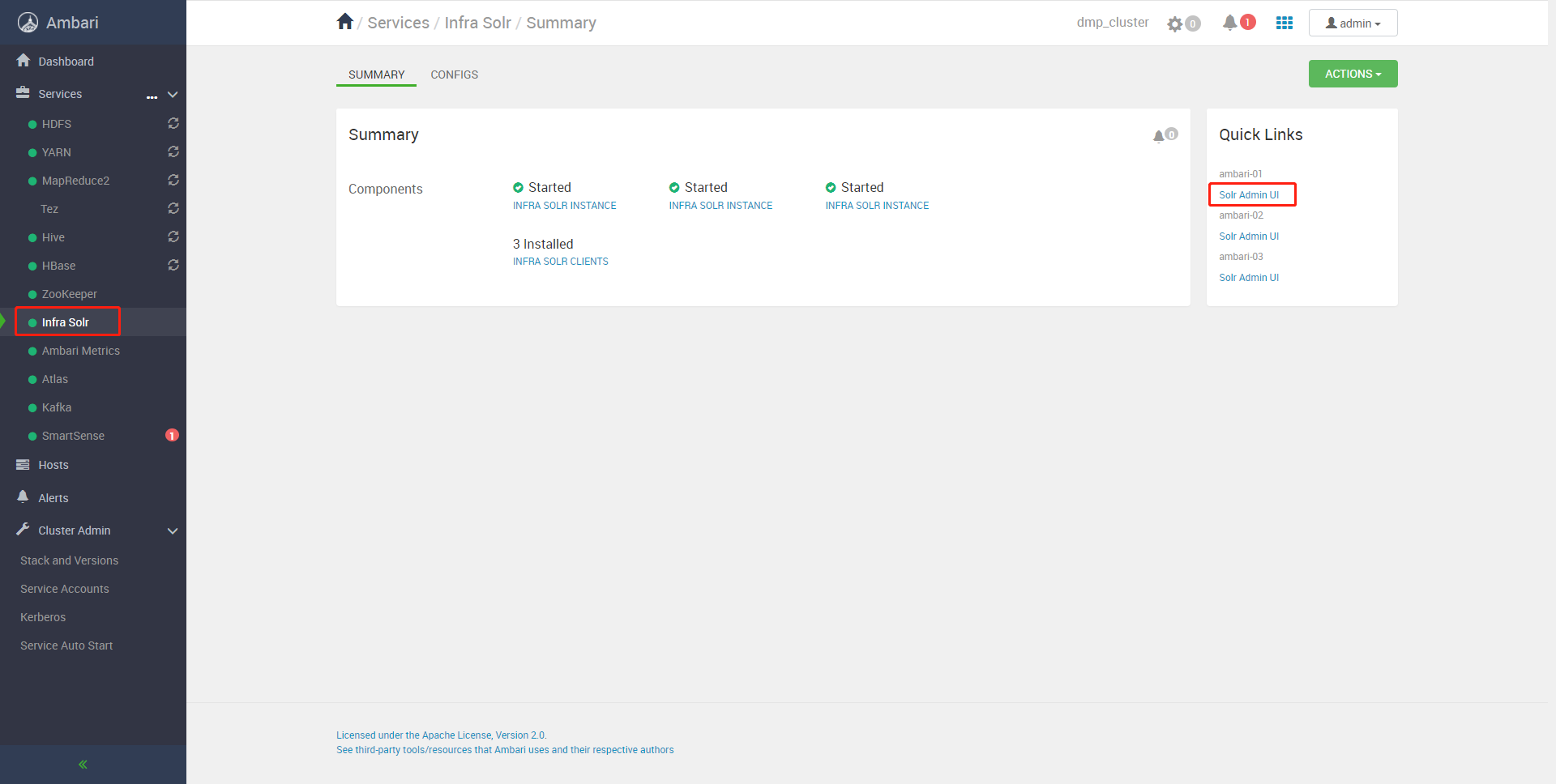

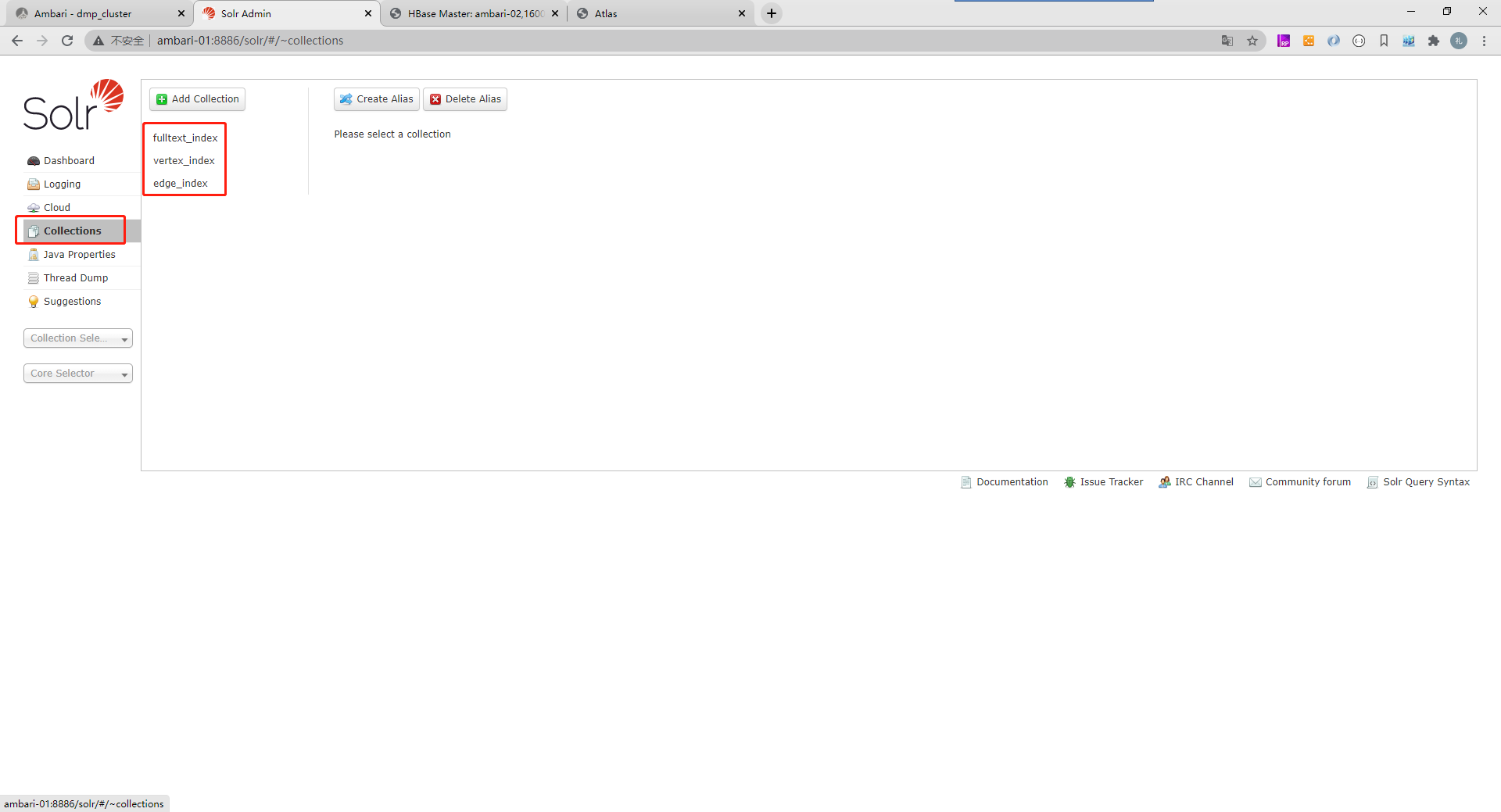

验证Solr集合是否创建

Atlas除了把元数据存储在HBase,为了实现快速检索,还会把元数据对应的索引存储在Solr中,我们登录Solr应该可以看到三个集合已经创建好:

fulltext_index

vertex_index

edge_index

验证KafkaTopic是否创建

Atlas会在Kafka中创建2个Topic用于跟外部组件做基于消息的集成:

ATLAS_HOOK: 来自 各个组件的Hook 的元数据通知事件通过写入到名为 ATLAS_HOOK 的 Kafka

topic 发送到 Atlas(消息入口:采集外部元数据)

ATLAS_ENTITIES:从 Atlas 到其他集成组件(如Ranger)的事件写入到名为 ATLAS_ENTITIES 的

Kafka topic(消息出口:暴露元数据变更事件给外部组件)

启动并进入Kafka Eagle:

- 点赞

- 收藏

- 关注作者

评论(0)