Linkis部署与安装

【摘要】 eureka访问地址http://ambari-03:20303/1、 安装java# 上传jdk8稳定版压缩包到服务器目录&解压sudo tar -zxvf jdk-8u231-linux-x64.tar.gz -C /usr/local/# 链接jdk - jdk1.8.0_231sudo ln -s /usr/local/jdk1.8.0_231/ /usr/local/jdk# 移除...

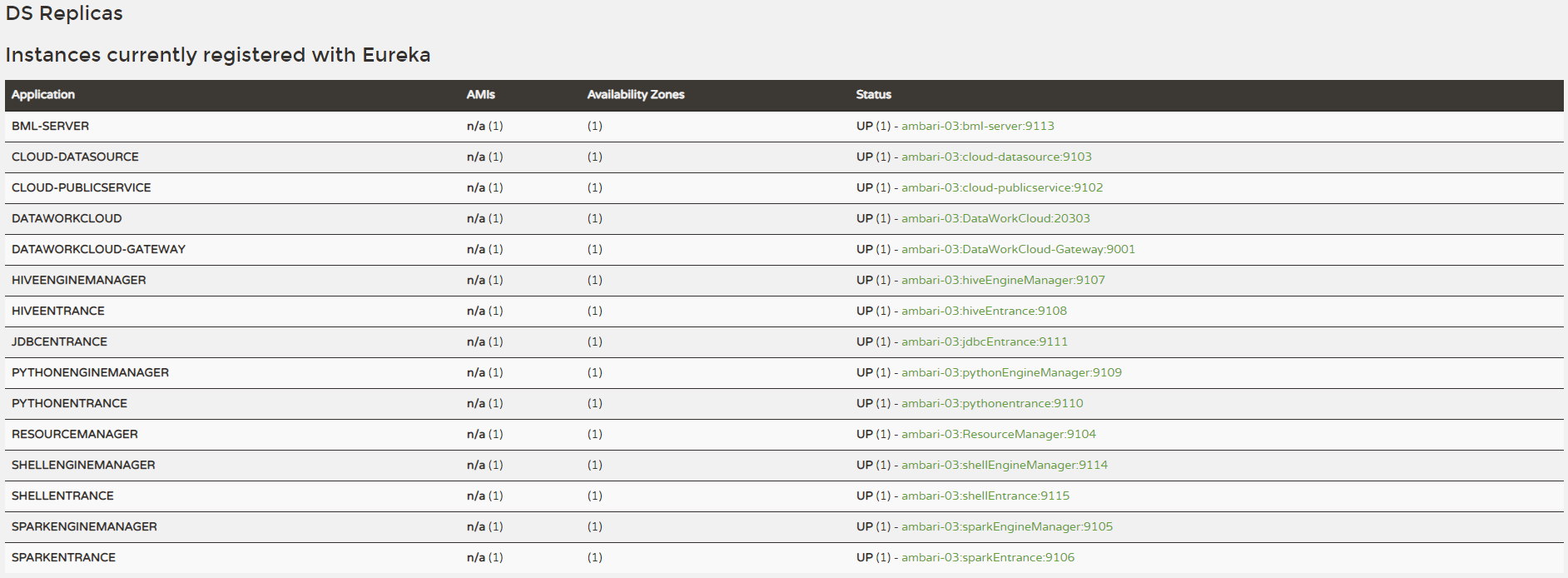

eureka访问地址

1、 安装java

# 上传jdk8稳定版压缩包到服务器目录&解压

sudo tar -zxvf jdk-8u231-linux-x64.tar.gz -C /usr/local/

# 链接jdk - jdk1.8.0_231

sudo ln -s /usr/local/jdk1.8.0_231/ /usr/local/jdk

# 移除安装包

rm -rf jdk-8u231-linux-x64.tar.gz# 配置java环境变量

sudo vi /etc/profile

# 在配置文件末尾加上如下配置

export JAVA_HOME=/usr/local/jdk

export JRE_HOME=${JAVA_HOME}/jre

export CLASS_PATH=.:${JAVA_HOME}/lib/:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

# 使环境变量生效

source /etc/profile

# 查看java版本

java -version

2、安装MySQL

# 安装mysql的yum仓库

sudo wget https://dev.mysql.com/get/mysql57-community-release-el7-9.noarch.rpm

rpm -ivh mysql57-community-release-el7-9.noarch.rpm

# 安装mysql(必须进入到 /etc/yum.repos.d/目录后再执行以下脚本)

yum install mysql-server

# 设置开机启动

sudo systemctl enable mysqld

# 启动MySQL

sudo systemctl start mysqld

# 查看MySQL的启动状态

sudo systemctl status mysqld

# 查看root临时密码(临时密码每次都是随机生成的) (&fZPOuLl19i

sudo grep 'temporary password' /var/log/mysqld.log

# 使用临时密码登录

mysql -uroot -p

# 重置密码

set password = password('密码');

# MySQL常用密码参数

set global validate_password_policy=0;

set global validate_password_mixed_case_count=0;

set global validate_password_number_count=3;

set global validate_password_special_char_count=0;

set global validate_password_length=3;

# 创建数据库

CREATE DATABASE IF NOT EXISTS linkis DEFAULT CHARSET utf8 COLLATE

utf8_general_ci;

# 修改密码('root'@'%' -- 允许远程连接)

CREATE USER 'linkis'@'%' IDENTIFIED BY 'linkis%123';

GRANT ALL ON linkis.* TO 'linkis'@'%';

FLUSH PRIVILEGES;

exit# 上传驱动包mysql-connector-java-8.0.18.jar 到服务器/usr/share/java目录

sudo mkdir -p /usr/share/java3、安装Python

安装依赖环境

yum -y install zlib-devel bzip2-devel openssl-devel ncurses-devel sqlite-devel readline-devel tk-devel gdbm-devel db4-devel libpcap-devel xz-devel下载Python

cd /opt

# 官网查看新版本 下载新版

wget https://www.python.org/ftp/python/3.7.1/Python-3.7.1.tgz

# 安装在/usr/local/python3

mkdir -p /usr/local/python3

# 解压下载好的Python-3.x.x.tgz包

tar -zxvf Python-3.7.1.tgz

# 编译安装前需要安装编译器 安装gcc

yum install gcc

# 3.7版本之后需要一个新的包libffi-devel

yum install libffi-devel -y

# 进入python文件夹,生成编译脚本(指定安装目录)

cd Python-3.7.1

./configure --prefix=/usr/local/python3

# 编译

make

# 编译成功后,编译安装

make install

# 检查python3.7的编译器

/usr/local/python3/bin/python3.7

# 建立Python3和pip3的软链

ln -s /usr/local/python3/bin/python3 /usr/bin/python3

ln -s /usr/local/python3/bin/pip3 /usr/bin/pip3

# 并将/usr/local/python3/bin加入PATH

vim /etc/profile

##########################################

# vim ~/.bash_profile

# .bash_profile

# Get the aliases and functions

if [ -f ~/.bashrc ]; then

. ~/.bashrc

fi

# User specific environment and startup programs

PATH=$PATH:$HOME/bin:/usr/local/python3/bin

export PATH

############################################

# 执行行下面的命令,让上一步的修改生效

source ~/.bash_profile

# 检查Python3及pip3是否正常可用:

python3 -V

pip3 -V4 创建部署⽤户

创建⼀个⽤于Linkis部署的⽤户并做免密,这⾥不再累述,咱们直接使⽤hadoop⽤户即可,前⾯已经做过免密了。

5 每个安装节点新增如下环境变量

export JAVA_HOME=/usr/local/jdk

export HADOOP_HOME=/usr/hdp/current/hadoop-client

export HADOOP_CONF_DIR=/etc/hadoop/conf

export HIVE_HOME=/usr/hdp/current/hive-client

export HIVE_CONF_DIR=/etc/hive/conf

export SPARK_HOME=/usr/hdp/current/spark2-client

export SPARK_CONF_DIR=/etc/spark2/conf

### Pyspark必须加的参数

export PYSPARK_ALLOW_INSECURE_GATEWAY=14、安装matplotlib

如果您的Pyspark想拥有画图功能,则还需在所有安装节点,安装画图模块。命令如下

python3 -m pip install matplotlib如果没有安装pip需要先安装pip

curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py

python3 get-pip.py5、创建本地⼯作⽬录

mkdir -p /tmp/linkis/hadoop6、安装包准备

上传并解压缩安装包到指定⽬录:

mkdir linkis

cd linkis

mv ../../wedatasphere-linkis-0.9.3-dist.tar.gz .

tar -zxvf wedatasphere-linkis-0.9.3-dist.tar.gz修改基础配置

vi conf/config.sh#指定SSH端⼝,如果单机版本安装可以不配置

SSH_PORT=22

#指定部署⽤户

deployUser=hadoop

# 指定安装⽬录

LINKIS_INSTALL_HOME=/linkis

# 指定⽤户根⽬录,⼀般⽤于存储⽤户的脚本⽂件和⽇志⽂件等,是⽤户的⼯作空间。(3.2.1.6 创建本

地⼯作⽬录)

WORKSPACE_USER_ROOT_PATH=file:///linkis/hadoop

HDFS_USER_ROOT_PATH=hdfs:///tmp/linkis # 指定⽤户的HDFS根⽬录,⼀般⽤于存储Job的结果集⽂件

# 如果您想配合Scriptis⼀起使⽤,CDH版的Hive,还需要配置如下参数(社区版Hive可忽略该配置)

## Provide the DB information of Hive metadata database.

HIVE_META_URL=jdbc:mysql://ambari-01/hive # HiveMeta元数据库的URL

HIVE_META_USER=hive # HiveMeta元数据库的⽤户

HIVE_META_PASSWORD=hive%123 # HiveMeta元数据库的密码

# 配置hadoop/hive/spark的配置⽬录

###HADOOP CONF DIR

HADOOP_CONF_DIR=/etc/hadoop/conf #hadoop的conf⽬录

###HIVE CONF DIR

HIVE_CONF_DIR=/etc/hive/conf #hive的conf⽬录

###SPARK CONF DIR

SPARK_CONF_DIR=/etc/spark/conf #spark的conf⽬录修改数据库配置

vi conf/db.sh# 设置数据库的连接信息

# 包括IP地址、数据库名称、⽤户名、端⼝

# 主要⽤于存储⽤户的⾃定义变量、配置参数、UDF和⼩函数,以及提供JobHistory的底层存储

MYSQL_HOST=node01

MYSQL_PORT=3306

MYSQL_DB=linkis

MYSQL_USER=linkis

MYSQL_PASSWORD=linkis%1237、安装

执⾏安装脚本

sh bin/install.sh安装步骤

- install.sh脚本会询问您安装模式。安装模式就是精简模式、简单模式或标准模式,请根据您准备的环境情况,选择合适的安装模式

- install.sh脚本会询问您是否需要初始化数据库并导⼊元数据。因为担⼼⽤户重复执⾏install.sh脚本,把数据库中的⽤户数据清空,所以在install.sh执⾏时,会

询问⽤户是否需要初始化数据库并导⼊元数据。第⼀次安装必须选是

是否安装成功

- 通过查看控制台打印的⽇志信息查看是否安装成功。如果有错误信息,可以查看具体报错原因。安装过程中会提示⼀些软件没装,直接安装即可

sudo yum -y install expect

sudo yum -y install telnet

sudo yum -y install dos2unix8、启动Linkis

sh ./bin/start-all.sh9、验证Linkis

可以在Eureka界⾯查看服务启动成功情况,查看⽅法:

使⽤http:// {EUREKA_PORT}, 在浏览器中打开,查看服务是否注册成

{EUREKA_PORT}, 在浏览器中打开,查看服务是否注册成

功。

如果您没有在config.sh指定EUREKA_INSTALL_IP和EUREKA_INSTALL_IP,则HTTP地址为:

http://127.0.0.1:20303

👇🏻 关注公众号 获取更多资料👇🏻

【声明】本内容来自华为云开发者社区博主,不代表华为云及华为云开发者社区的观点和立场。转载时必须标注文章的来源(华为云社区)、文章链接、文章作者等基本信息,否则作者和本社区有权追究责任。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)