Hadoop应用实战100讲(一)-Hadoop进行文件压缩

【摘要】

前言

在集群中大规模的数据的转换与传输是一项艰巨的任务,而Hadoop自带一套特有的文件I/O系统,使得这项艰巨的任务变得简单。

以下是我为大家准备的几个精品专栏,喜欢的小伙伴可自行订阅,你的支持就是我不断更新的动力哟!

MATLAB-30天带你从入门到精通

MATLAB深入理解高级教程(附源码)

tableau可视化数据分析...

前言

在集群中大规模的数据的转换与传输是一项艰巨的任务,而Hadoop自带一套特有的文件I/O系统,使得这项艰巨的任务变得简单。

以下是我为大家准备的几个精品专栏,喜欢的小伙伴可自行订阅,你的支持就是我不断更新的动力哟!

1.压缩

Hadoop文件数据存取与计算需要集群中众多的节点,通过网络连接方式进行相互协作完成作业,节点间的数据采用压缩形式进行传输,这样可以减少存储文件所需的磁盘空间,而且可以加数据在网络和磁盘上的传输。

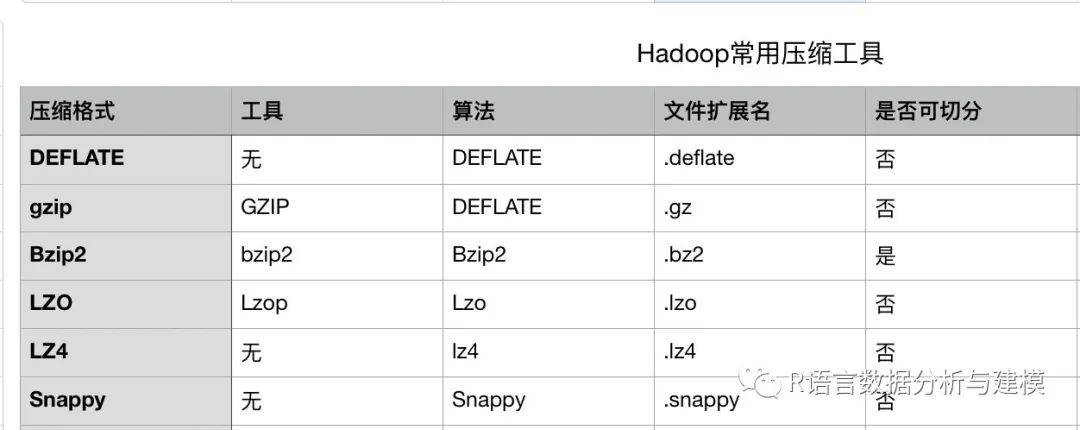

压缩类型,在采用压缩算法传输数据前,需要考虑的问题是Hadoop需要能够辨识压缩算法计算后的文件,依据业务需求考虑压缩算法的空间占比的均衡。

DEFLATE是同时使用了LZ77算法和哈夫曼编码是一个无损数据压缩算法。它最初是是由菲尔.卡茨为他的PKZIP软件

文章来源: wenyusuran.blog.csdn.net,作者:文宇肃然,版权归原作者所有,如需转载,请联系作者。

原文链接:wenyusuran.blog.csdn.net/article/details/119565215

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)