HBase的集群环境搭建

本篇博客,小菌为大家带来的是关于HBase的集群环境搭建。

在开始之前,有一个注意事项:HBase强依赖zookeeper和hadoop,安装HBase之前一定要保证zookeeper和hadoop启动成功,且服务正常运行。

第一步: 下载对应的HBase 的安装包

所有关于CDH版本的软件包下载地址如下

http://archive.cloudera.com/cdh5/cdh/5/

HBase对应的版本下载地址如下

http://archive.cloudera.com/cdh5/cdh/5/hbase-1.2.0-cdh5.14.0.tar.gz

第二步:压缩包上传并解压

将我们的压缩包上传到node01服务器的/export/softwares路径下并解压

cd /export/softwares/

tar -zxvf hbase-1.2.0-cdh5.14.0-bin.tar.gz -C ../servers/

- 1

- 2

第三步:修改配置文件

第一台机器进行修改配置文件

cd /export/servers/hbase-1.2.0-cdh5.14.0/conf

- 1

修改第一个配置文件hbase-env.sh

vim hbase-env.shll

export JAVA_HOME=/export/servers/jdk1.8.0_141

export HBASE_MANAGES_ZK=false

- 1

- 2

修改第二个配置文件hbase-site.xml

修改hbase-site.xml

vim hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://node01:8020/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- 0.98后的新变动,之前版本没有.port,默认端口为60000 -->

<property>

<name>hbase.master.port</name>

<value>16000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>node01:2181,node02:2181,node03:2181</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/export/servers/zookeeper-3.4.5-cdh5.14.0/zkdatas</value>

</property>

</configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

修改第三个配置文件regionservers

vim regionservers

node01

node02

node03

- 1

- 2

- 3

创建back-masters配置文件,实现HMaster的高可用

cd /export/servers/hbase-1.2.0-cdh5.14.0/conf

vim backup-masters

- 1

- 2

node01

node02

node03

- 1

- 2

- 3

注: HBase在决定节点接替时,用到了ZooKeeper的选举机制,具体的机制详情见《ZooKeeper的选举机制》

第四步:安装包分发到其他机器

将我们第一台机器的hbase的安装包拷贝到其他机器上面去

cd /export/servers/

scp -r hbase-1.2.0-cdh5.14.0/ node02:$PWD

scp -r hbase-1.2.0-cdh5.14.0/ node03:$PWD

- 1

- 2

- 3

第五步:三台机器创建软连接

因为hbase需要读取hadoop的core-site.xml以及hdfs-site.xml当中的配置文件信息,所以我们三台机器都要执行以下命令创建软连接

ln -s /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/core-site.xml /export/servers/hbase-1.2.0-cdh5.14.0/conf/core-site.xml

ln -s /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/hdfs-site.xml /export/servers/hbase-1.2.0-cdh5.14.0/conf/hdfs-site.xml

第六步:三台机器添加HBASE_HOME的环境变量

vim /etc/profile.d/hbase.sh

export HBASE_HOME=/export/servers/hbase-1.2.0-cdh5.14.0

export PATH=:$HBASE_HOME/bin:$PATH

- 1

- 2

第七步:HBase集群启动

第一台机器执行以下命令进行启动

cd /export/servers/hbase-1.2.0-cdh5.14.0

bin/start-hbase.sh

- 1

- 2

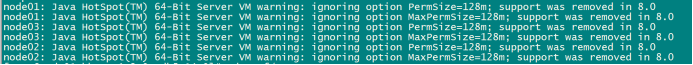

警告提示: HBase启动的时候会产生一个警告,这是因为jdk7与jdk8的问题导致的,如果linux服务器安装jdk8就会产生这样的一个警告。

我们可以通过修改所有机器的hbase-env.sh当中的’HBASE_MASTER_OPTS’和‘HBASE_REGIONSERVER_OPTS’的配置来解决这个问题。不过警告不影响我们正常运行,可以不用解决。

当然,我们也可以执行以下命令单节点进行启动。

启动HMaster 命令

bin/hbase-daemon.sh start master

启动HRegionServer命令

bin/hbase-daemon.sh start regionserver

为了解决HMaster单点故障问题,我们可以在node02和node03机器上面都可以启动HMaster节点的进程,以实现HMaster的高可用

bin/hbase-daemon.sh start master

第八步:页面访问

配置好了以上几步,接下来我们可以直接通过浏览器进行HBase的UI页面访问

http://node01:60010/master-status

那么,本次的分享到这里就结束了。受益的小伙伴们或对大数据技术感兴趣的朋友记得关注小菌哟(^U^)ノ~YO,下一篇博客,小菌将带来HBase的常用shell操作,敬请期待!!!

文章来源: alice.blog.csdn.net,作者:大数据梦想家,版权归原作者所有,如需转载,请联系作者。

原文链接:alice.blog.csdn.net/article/details/103486461

- 点赞

- 收藏

- 关注作者

评论(0)