Hue集成HDFS

相信大家在看了《Hue的安装,配置,编译》之后,都已经成功把Hue安装好了。

接下来,小菌为大家分享的是如何在Hue上集成HDFS!

首先我们需要进入到我们hadoop的指定目录下

/export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

1.修改core-site.xml配置

在文件中添加下面的内容

<!—允许通过httpfs方式访问hdfs的主机名 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<!—允许通过httpfs方式访问hdfs的用户组 -->

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

2.修改hdfs-site.xml配置

同样的,在文件中添加下面的内容

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

- 1

- 2

- 3

- 4

注意修改完HDFS相关配置后,需要把配置scp给集群中每台机器,重启hdfs集群。

把数据同步到每台节点上之后,我们接着需要修改hue安装目录下的文件

3.修改hue.ini

cd /export/servers/hue-3.9.0-cdh5.14.0/desktop/conf

vim hue.ini

注意把对应的属性设置成下面的内容

[[hdfs_clusters]]

[[[default]]]

fs_defaultfs=hdfs://node01:9000

webhdfs_url=http://node01:50070/webhdfs/v1

hadoop_hdfs_home= /export/servers/hadoop-2.7.5

hadoop_bin=/export/servers/hadoop-2.7.5/bin

hadoop_conf_dir=/export/servers/hadoop-2.7.5/etc/hadoop

- 1

- 2

- 3

- 4

- 5

- 6

- 7

其中,node01为主节点的ip

hadoop_hdfs_home,hadoop_bin,hadoop_conf_dir需要根据自己hadoop的安装路径自行修改

4.重启HDFS、Hue

做完了上面的步骤,到这一步就只剩下重启HDFS和Hue了

因为我们配置了Hadoop的环境变量,所以直接在命令行输入

stop-dfs.sh关闭HDFS,然后再start-dfs.sh开启集群。

启动Hue也很简单

直接输入以下命令即可

cd /export/servers/hue-3.9.0-cdh5.14.0/

build/env/bin/supervisor

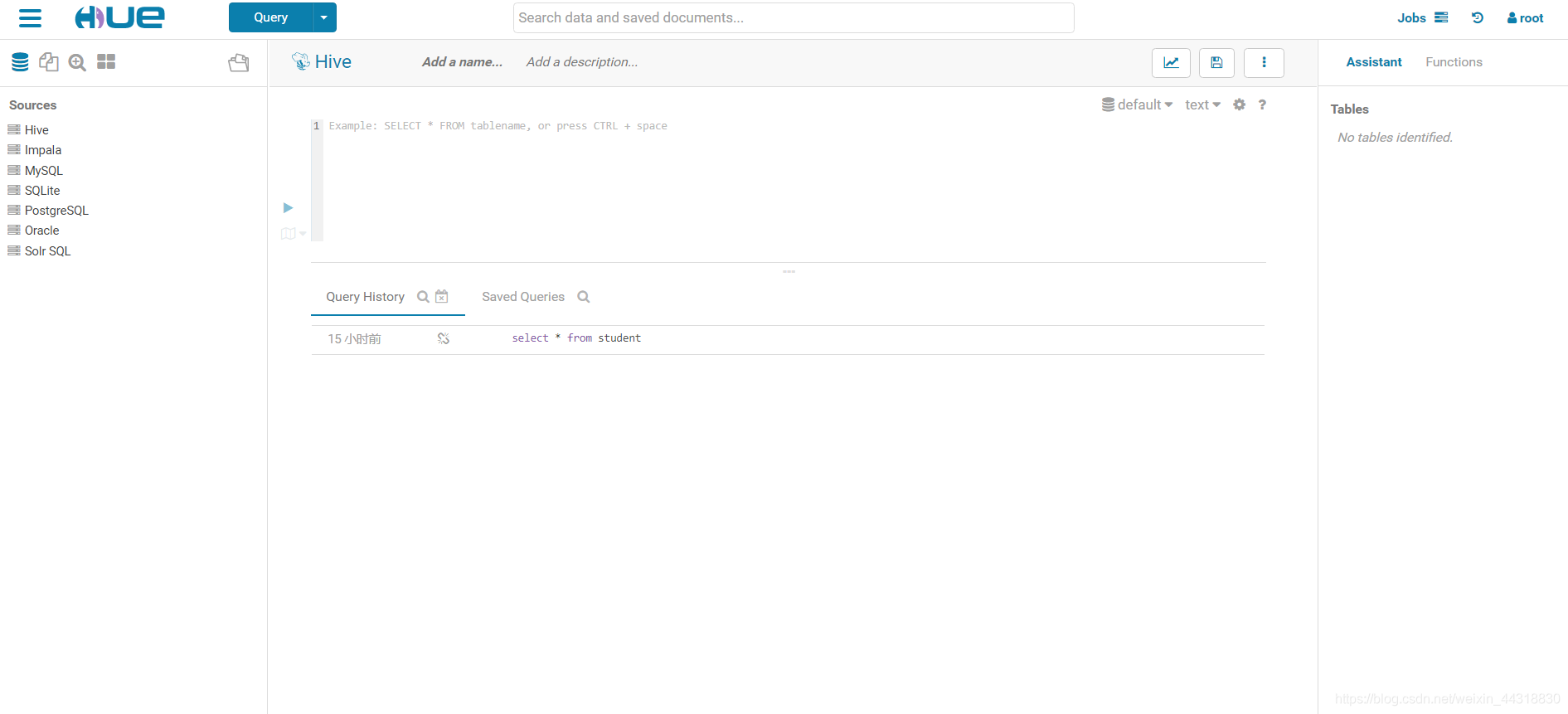

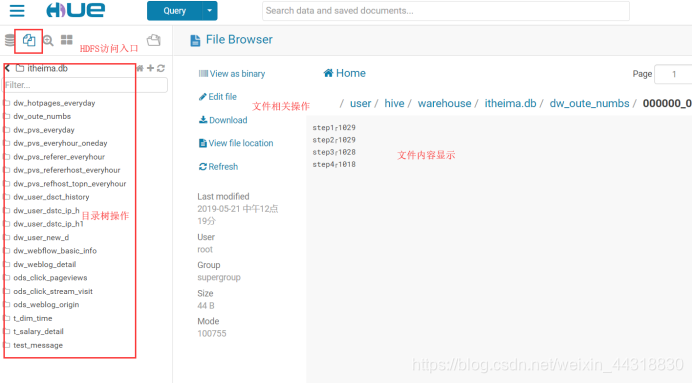

然后,来到我们的Hue的UI界面上

看到类似这样的效果,说明我们的Hue集成HDFS就成功了

当然,大家在启动Hue的时候可能会遇到端口被占用的情况,具体的解决方案可以去看看《Hue启动异常,提示address already in use》

那么本次的分享就到这里了,受益的小伙伴或者对大数据技术感兴趣的朋友们记得关注小菌哟(^U^)ノ~YO

文章来源: alice.blog.csdn.net,作者:大数据梦想家,版权归原作者所有,如需转载,请联系作者。

原文链接:alice.blog.csdn.net/article/details/103432340

- 点赞

- 收藏

- 关注作者

评论(0)