pandas根据某列去重

【摘要】

pandas根据某列去重

drop_duplicates(subset=[‘comment’], keep=‘first’, inplace=True)

参数:

subset: ...

drop_duplicates(subset=[‘comment’], keep=‘first’, inplace=True)

参数:

subset: 列表的形式填写要进行去重的列名,默认为None,表示根据所有列进行。keep: 可选参数有三个:first、last、False, 默认值first。其中,

(1)first表示: 保留第一次出现的重复行,删除后面的重复行。

(2)last表示: 删除重复项,保留最后一次出现。

(3)False表示: 删除所有重复项。inplace:默认为False,删除重复项后返回副本。True,直接在原数据上删除重复项。

✪ 栗子 ✪

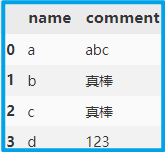

首先创建一个 DataFrame。

import pandas as pd

dic = {'name':['a', 'b', 'c', 'd'], 'comment':['abc', '真棒', '真棒', '123']}

df = pd.DataFrame(dic)

df

- 1

- 2

- 3

- 4

使用 drop_duplicates 来去除重复值,如果不指明 subset ,那么默认根据所有列来考虑,即当某两行数据所有列都重复时进行去重。

df.drop_duplicates(keep='first', inplace=True)

- 1

subset默认为None,根据所有列考虑,1,2行虽然comment相同,但name不相同,故保留,使用时根据具体情况进行选择。

现在设置 subset 为 comment 即可删除该列重复值。

df.drop_duplicates(subset=['comment'], keep='first', inplace=True)

- 1

注意:此时索引没有重置,如有需要可使用 reset_index() 重置索引。

df.reset_index(drop=True, inplace=True)

- 1

文章来源: blog.csdn.net,作者:Dream丶Killer,版权归原作者所有,如需转载,请联系作者。

原文链接:blog.csdn.net/qq_43965708/article/details/109892053

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)