keras从入门到放弃(三)逻辑回归 softmax

【摘要】 逻辑回归

之前写过逻辑回归,是sklearn的方法,基本一样

https://blog.csdn.net/weixin_44510615/article/details/88608831

补充一个概念: 交叉商损失函数

交叉商是实际输出概率于期望输出概率的距离,也就是交叉商的值越小,两个概率分布就越接近。

假设概率分布p为期望输出,概率分布q是实际输出,H(p...

逻辑回归

之前写过逻辑回归,是sklearn的方法,基本一样

https://blog.csdn.net/weixin_44510615/article/details/88608831

补充一个概念:

交叉商损失函数

交叉商是实际输出概率于期望输出概率的距离,也就是交叉商的值越小,两个概率分布就越接近。

假设概率分布p为期望输出,概率分布q是实际输出,H(p,q)为交叉商,则:

H(p,q)=−∑p(x)logq(x)

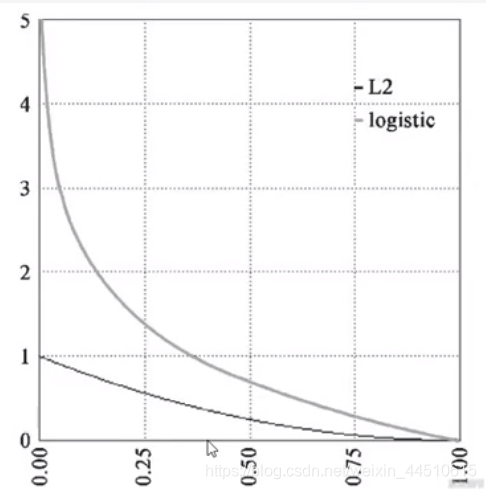

l2是均方差损失函数

在keras交叉熵中,我们使用binary_crossentropy来计算二元交叉熵

对数几率回归解决的是二分类问题,对于多分类问题我们可以使用softmax分类函数,它是对数几率在N个可能不同的值上的推广

softmax分类

神经网络的原始输出不是一个概率值没实际上知识输入的数值做了复杂的加权和与非线性处理智慧的一个值而已,那么如何将这个输出变为概率分布呢

这就是 softm

文章来源: maoli.blog.csdn.net,作者:刘润森!,版权归原作者所有,如需转载,请联系作者。

原文链接:maoli.blog.csdn.net/article/details/88768638

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)