利用学习率衰减找到最优结果(基于Iris数据集)

【摘要】 学习率是深度学习中的一个重要的超参,如何调整学习率是训练出好模型的关键要素之一。

关于学习率的大小

在训练过程中,一般根据训练轮数设置动态变化的学习率。

刚开始训练时:学习率以 0.01 ~ 0.001 为宜。

一定轮数过后:逐渐减缓。

接近训练结束:学习速率的衰减应该在100倍以上。

两种学习率衰减模式,一种为线性衰减,一种为指数衰减...

学习率是深度学习中的一个重要的超参,如何调整学习率是训练出好模型的关键要素之一。

关于学习率的大小

在训练过程中,一般根据训练轮数设置动态变化的学习率。

-

刚开始训练时:学习率以 0.01 ~ 0.001 为宜。

-

一定轮数过后:逐渐减缓。

-

接近训练结束:学习速率的衰减应该在100倍以上。

-

两种学习率衰减模式,一种为线性衰减,一种为指数衰减。

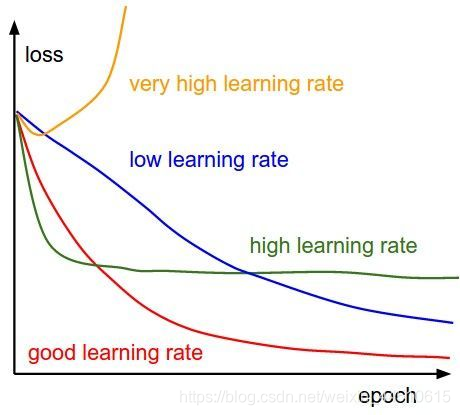

如果学习率过小,梯度下降很慢,如果学习率过大,如Andrew Ng的Stanford公开课程所说梯度下降的步子过大可能会跨过最优值。不同的学习率对loss的影响如下图所示:

常见学习率衰减方式

https://www.jianshu.com/p/125fe2ab085b

线性衰减

momentum 动量法

网络权值时,存在一些不确定因素&#

文章来源: maoli.blog.csdn.net,作者:刘润森!,版权归原作者所有,如需转载,请联系作者。

原文链接:maoli.blog.csdn.net/article/details/102997688

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)