DL:神经网络算法简介之耗算力的简介、原因、经典模型耗算力计算、GPU使用之详细攻略

【摘要】 DL:神经网络算法简介之耗算力的简介、原因、经典模型耗算力计算、GPU使用之详细攻略

目录

神经网络算法耗算力的简介

神经网络算法耗算力的原因

神经网络算法耗算力的经典模型耗算力计算

1、AlexNet网络

GPU使用

神经网络算法耗算力的简介

通过比特币来理解算力。算力(也称哈希率)是比特币网络处理能力的...

DL:神经网络算法简介之耗算力的简介、原因、经典模型耗算力计算、GPU使用之详细攻略

目录

神经网络算法耗算力的简介

通过比特币来理解算力。算力(也称哈希率)是比特币网络处理能力的度量单位。即为计算机(CPU)计算哈希函数输出的速度。比特币网络必须为了安全目的而进行密集的数学和加密相关操作。 例如,当网络达到10Th/s的哈希率时,意味着它可以每秒进行10万亿次计算。

神经网络算法耗算力的原因

随着大数据和网络的大规模化,深度学习需要进行大量的运算。

神经网络算法耗算力的经典模型耗算力计算

1、AlexNet网络算力

DL之AlexNet:AlexNet算法的简介(论文介绍)、架构详解、案例应用等配图集合之详细攻略之AlexNet网络所需算力

GPU使用

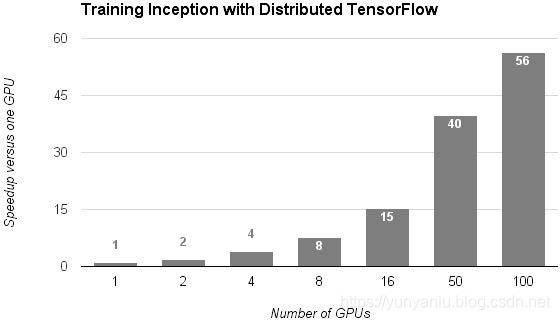

1、基于TensorFlow 的分布式学习的效果:横轴是GPU的个数,纵轴是与单个GPU相比时的高速化率。

图片源自 Google Research Blog “Announcing TensorFlow 0.8 – now with distributed computing support!”

文章来源: yunyaniu.blog.csdn.net,作者:一个处女座的程序猿,版权归原作者所有,如需转载,请联系作者。

原文链接:yunyaniu.blog.csdn.net/article/details/89519978

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)