Python之pyspark:pyspark的简介、安装、使用方法之详细攻略

Python之pyspark:pyspark的简介、安装、使用方法之详细攻略

目录

pyspark的简介

Spark是一个用于大规模数据处理的统一分析引擎。它提供Scala、Java、Python和R中的高级api,以及一个优化的引擎,该引擎支持用于数据分析的通用计算图。它还支持一组丰富的高级工具,包括用于SQL和DataFrames的Spark SQL、用于机器学习的MLlib、用于图形处理的GraphX和用于流处理的结构化流。

Python Packaging,这个自述文件只包含与PySpark安装的pip相关的基本信息。这个打包目前还处于试验阶段,在未来的版本中可能会有变化(尽管我们会尽力保持兼容性)。使用PySpark需要Spark jar,如果您是从源代码构建它,请参阅“构建Spark”中的构建器说明。

Spark的Python打包并不打算取代所有其他用例。这个Python打包版本的Spark适合与现有集群交互(无论是Spark independent、YARN还是Mesos)—但是不包含设置自己的独立Spark集群所需的工具。您可以从Apache Spark下载页面下载完整版本的Spark。

注意:如果您在Spark独立集群中使用它,您必须确保版本(包括次要版本)匹配,否则您可能会遇到奇怪的错误。

官网:https://spark.apache.org/

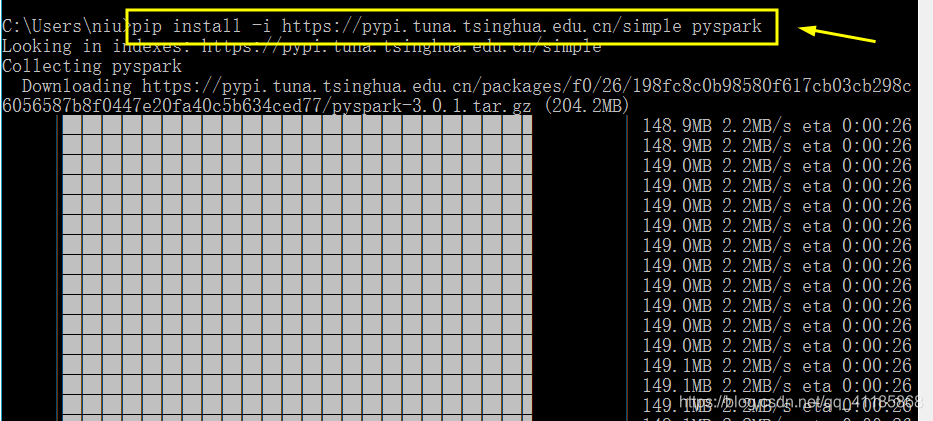

pyspark的安装

pip install pyspark

pyspark的使用方法

-

from pyspark import SparkContext, SparkConf

-

from pyspark.sql.session import SparkSession

-

-

-

conf = SparkConf().setAppName('test_parquet')

-

sc = SparkContext('local', 'test', conf=conf)

-

spark = SparkSession(sc)

-

-

# parquetFile = r"hdfs://host:port/Felix_test/test_data.parquet"

-

parquetFile = r"data.gz.parquet"

-

df = spark.read.parquet(parquetFile)

-

print(df.first())

文章来源: yunyaniu.blog.csdn.net,作者:一个处女座的程序猿,版权归原作者所有,如需转载,请联系作者。

原文链接:yunyaniu.blog.csdn.net/article/details/80213998

- 点赞

- 收藏

- 关注作者

评论(0)