解决 Apache Hadoop 启动时 DataNode 没有启动的问题(注意这会删除 HDFS 中原有的所有数据)

【摘要】 解决 Apache Hadoop 启动时 DataNode 没有启动的问题(注意这会删除 HDFS 中原有的所有数据,如果原有的数据很重要请不要这样做)。

文章目录

- 前言

- 一、启动 HDFS 并显示当前所有 Java 进程

- 二、DataNode 启动异常

- 2.1、DataNode 启动异常描述

- 2.2、解决方式

- 三、Web 界面来查看 Hadoop 信息

- 总结

解决 Apache Hadoop 启动时 DataNode 没有启动的问题(注意这会删除 HDFS 中原有的所有数据,如果原有的数据很重要请不要这样做)。

依次在 Hadoop 安装目录下执行以下指令启动 HDFS 并显示当前所有 Java 进程:

./bin/hdfs namenode -format #格式化NameNode

./sbin/start-dfs.sh #启动HDFS

jps #显示当前所有的Java进程当 DataNode 启动异常时或者没有启动时我们调用 jps 命令不会显示其进程,如下图所示:

2.2、解决方式

./sbin/stop-dfs.sh #关闭HDFS

rm -r ./tmp #删除tmp文件,注意这会删除HDFS中原有的所有数据,tmp文件目录根据本地目录寻找

./bin/hdfs namenode -format #重新格式化NameNode

./sbin/start-dfs.sh #重启HDFS

jps #显示当前所有的Java进程成功启动后我们可以看到 DataNode 的进程,如下图所示:

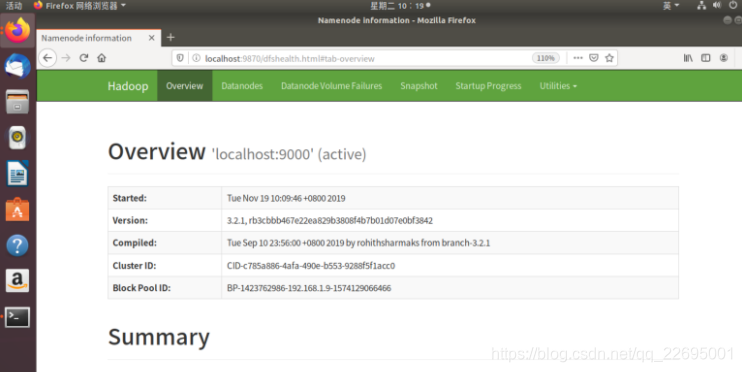

同时,可以通过 Linux 本地浏览器访问 Web 界面(http://localhost:9870)来查看 Hadoop 的信息:

本文解决了 Apache Hadoop 启动时 DataNode 没有启动的问题,但是请注意这会删除 HDFS 中原有的所有数据,如果原有的数据很重要请不要这样做。其他的方法暂时还没有发现,这个方法百试百灵,有其他的方法的小伙伴欢迎补充!

感谢大家的支持,我是白鹿,一个不懈奋斗的程序猿。希望本贴能帮助到大家,欢迎大家的一键三连!如果还有什么问题、建议或者补充可以留言在帖子下方,给予更多人帮助!

【版权声明】本文为华为云社区用户原创内容,未经允许不得转载,如需转载请自行联系原作者进行授权。如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)