HDFS系列(5) | 进行API操作前的准备

【摘要】

本篇博文给大家介绍的是进行JavaAPI操作前的准备工作

目录

一. 电脑安装配置Hadoop1. 将下载的jar包放到非中文路径2. 配置HADOOP_HOME环境变量3. 配置Path环境变量4. 测试是否成功

二. maven1. 此步可省略,一般用自带的即可2. 创建一个Maven工程

三. 创建包和类1. 创建2. 输入测试代码

...

本篇博文给大家介绍的是进行JavaAPI操作前的准备工作

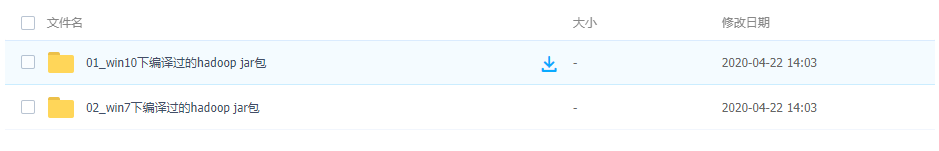

个人可根据自己电脑的操作系统下载对应的hadoop.jar包到非中文路径

所用jar包的连接如下:

链接:https://pan.baidu.com/s/1krbLrnejfXSsLppauxrCTg

提取码:jbsr

一. 电脑安装配置Hadoop

1. 将下载的jar包放到非中文路径

博主路径为:D:\hadoop\hadoop-2.7.2

2. 配置HADOOP_HOME环境变量

3. 配置Path环境变量

4. 测试是否成功

输入:winutils

如果出现上述界面,即代表成功,否则为失败

二. maven

1. 此步可省略,一般用自带的即可

2. 创建一个Maven工程

- 1. 创建过程

- 2. 添加依赖

在pom.xml中添加如下内容:

<dependencies> <dependency> <groupId>junit</groupId> <artifactId>junit</artifactId> <version>RELEASE</version> </dependency> <dependency> <groupId>org.apache.logging.log4j</groupId> <artifactId>log4j-core</artifactId> <version>2.8.2</version> </dependency> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-common</artifactId> <version>2.7.2</version> </dependency> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-client</artifactId> <version>2.7.2</version> </dependency> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-hdfs</artifactId> <version>2.7.2</version> </dependency> <dependency> <groupId>jdk.tools</groupId> <artifactId>jdk.tools</artifactId> <version>1.8</version> <scope>system</scope> <systemPath>D:/java/jdk-1.8.0/lib/tools.jar</systemPath> </dependency> </dependencies>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 3. 添加完毕之后,右上角检查没有报错说明我们的maven项目的jar包配置成功!

- 4. 如果Eclipse/Idea打印不出日志,在控制台上只显示:

1.log4j:WARN No appenders could be found for logger (org.apache.hadoop.util.Shell).

2.log4j:WARN Please initialize the log4j system properly.

3.log4j:WARN See http://logging.apache.org/log4j/1.2/faq.html#noconfig for more info.

- 1

- 2

- 3

- 4

需要在项目的src/main/resources目录下,新建一个文件,命名为“log4j.properties”,在文件中填入

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

三. 创建包和类

1. 创建

2. 输入测试代码

package com.buwenbuhuo.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

/**

* @author buwenbuhuo

* @create 2020-04-22 16:45

* com.buwenbuhuo.hdfs - the name of the target package where the new class or interface will be created.

* hdfs0422 - the name of the current project.

*/

public class HDFSClient { @Test public void testMkdirs() throws IOException, InterruptedException, URISyntaxException { // 1 获取文件系统 Configuration configuration = new Configuration(); // 配置在集群上运行 FileSystem fs = FileSystem.get(URI.create("hdfs://hadoop001:9000"), configuration, "bigdata"); // 2 创建目录 fs.mkdirs(new Path("/0422/buwenbuhuo/test")); // 3 关闭资源 fs.close(); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

在集群上查看是否成功

本篇博文到这里就结束了,小伙伴们有什么疑惑或好的建议可以积极在评论区留言,博主会在后续继续推出HDFS系列的其他内容,希望大家持续关注博主~~

文章来源: buwenbuhuo.blog.csdn.net,作者:不温卜火,版权归原作者所有,如需转载,请联系作者。

原文链接:buwenbuhuo.blog.csdn.net/article/details/105680669

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)