【Pytorch】torch.nn.Linear()

【摘要】

目录

简介torch.nn.Linear()语法作用举例参考

结语

简介

Hello! 非常感谢您阅读海轰的文章,倘若文中有错误的地方,欢迎您指出~ ଘ(੭ˊᵕ...

简介

Hello!

非常感谢您阅读海轰的文章,倘若文中有错误的地方,欢迎您指出~

ଘ(੭ˊᵕˋ)੭

昵称:海轰

标签:程序猿|C++选手|学生

简介:因C语言结识编程,随后转入计算机专业,获得过国家奖学金,有幸在竞赛中拿过一些国奖、省奖…已保研

学习经验:扎实基础 + 多做笔记 + 多敲代码 + 多思考 + 学好英语!

唯有努力💪

本文仅记录自己感兴趣的内容

torch.nn.Linear()

语法

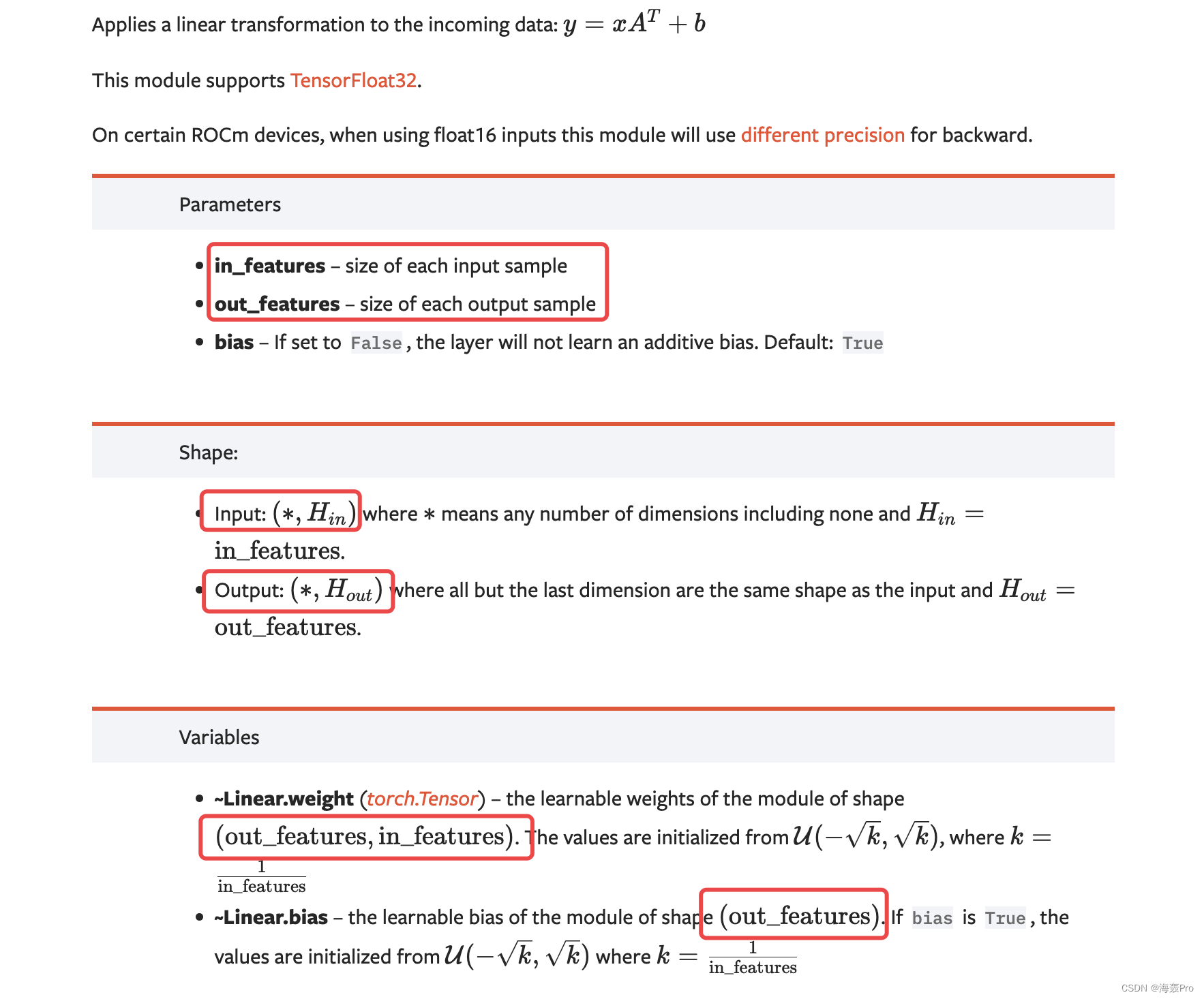

torch.nn.Linear(in_features, out_features, bias=True, device=None, dtype=None)

作用

对输入数据应用线性变换: y = x A T + b y = xA^T + b y=xAT+b

构建一个全连接层(liner的作用,个人更加倾向于这样理解)

输入作为全连接层的输入

输出为全连接层的输出

举例

m = nn.Linear(2, 3) # 构建一个全连接层 输入神经元个数:2 输出神经元个数:3

input = torch.randn(4, 2) # 输入维度 4 * 2

output = m(input) # 向全连接层中加入输入数据 得到输出

print(input)

print(output)

print(output.size())

- 1

- 2

- 3

- 4

- 5

- 6

解释

- 利用nn.Linear(2, 3)构建一个 2 * 3 的全连接层 , 即m

- 将input应用到m上,得到output ,维度为 4 * 3

- (4 * 2) * (2 * 3) = (4 * 3)

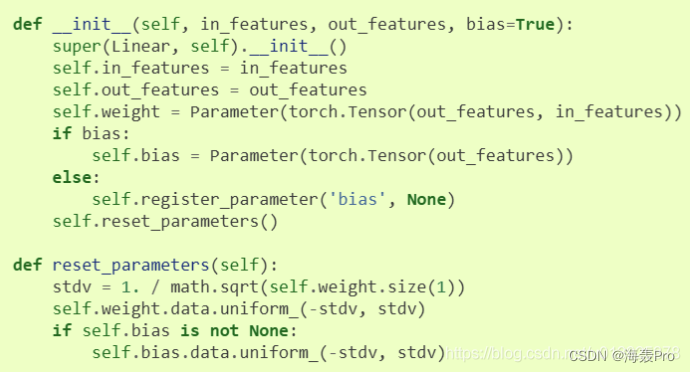

linear源码实现:

图片来源:https://blog.csdn.net/u013925378/article/details/103366064

从上面源码中可以看出,我们可以得到全连接层m中的weight、bias

print(m.weight)

print(m.weight.shape)

print(m.bias)

print(m.bias.shape)

- 1

- 2

- 3

- 4

参考

- https://pytorch.org/docs/stable/generated/torch.nn.Linear.html#torch.nn.Linear

- https://blog.csdn.net/u013925378/article/details/103366064

结语

文章仅作为个人学习笔记记录,记录从0到1的一个过程

希望对您有一点点帮助,如有错误欢迎小伙伴指正

文章来源: haihong.blog.csdn.net,作者:海轰Pro,版权归原作者所有,如需转载,请联系作者。

原文链接:haihong.blog.csdn.net/article/details/126639413

【版权声明】本文为华为云社区用户转载文章,如果您发现本社区中有涉嫌抄袭的内容,欢迎发送邮件进行举报,并提供相关证据,一经查实,本社区将立刻删除涉嫌侵权内容,举报邮箱:

cloudbbs@huaweicloud.com

- 点赞

- 收藏

- 关注作者

评论(0)